Jest to instrukcja obsługi systemu VCAcore - Analizy Zawartości Wideo. W tym podręczniku opisano, jak przygotować i skonfigurować silnik analizy wideo, aby wykrywać interesujące zdarzenia, jednocześnie minimalizując fałszywe alarmy.

System VCAcore - Analizy Zawartości Wideo jest dostępny na wielu platformach:

Funkcjonalność i interfejs użytkownika zostały zaprojektowane tak, aby były spójne na wszystkich platformach, a wszelkie różnice zostaną w razie potrzeby wyróżnione w tym podręczniku.

Menu po lewej stronie zawiera skróty do głównych obszarów tematycznych. Możesz również zapoznać się z tematem Pierwsze Kroki, aby uzyskać podstawowe informacje niezbędne do szybkiego rozpoczęcia pracy.

Ten podręcznik użytkownika szczegółowo omawia każdy temat, który jest dostępny za pośrednictwem menu. Jednak, aby szybko rozpocząć, podstawowe zagadnienia są wymienione poniżej.

Wybierz odpowiedni Mostek VCA, dla Twoich potrzeb.

Dowiedz się, jak poruszać się po interfejsie urządzenia.

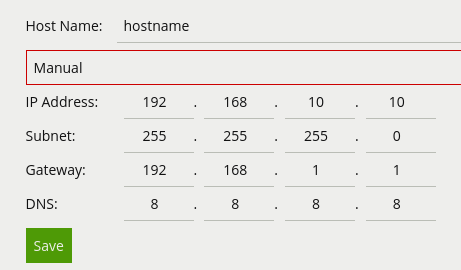

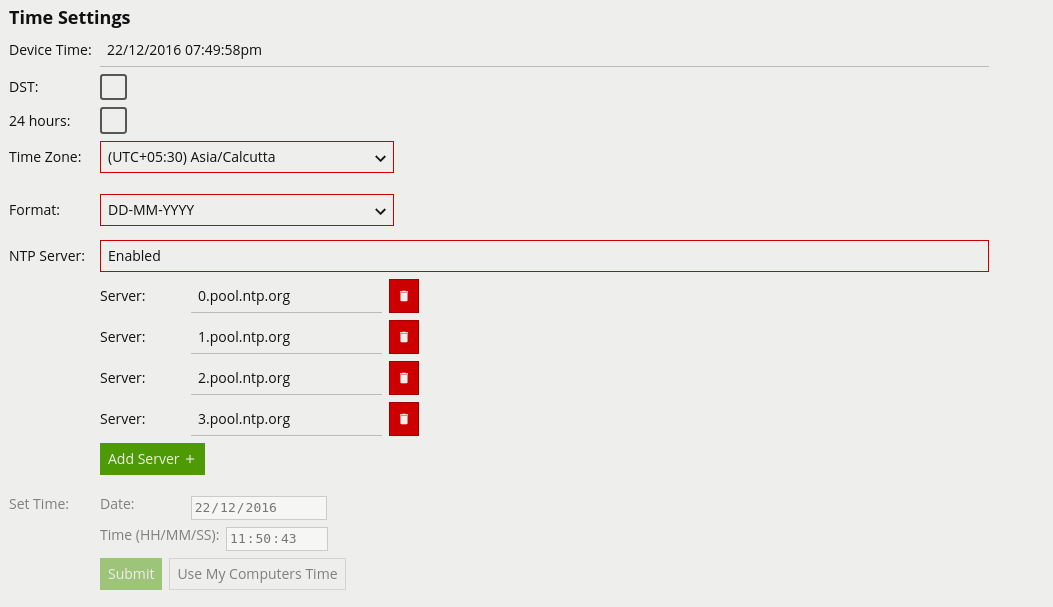

Jeśli korzystasz z VCAcore na platformie VCAbridge, skonfiguruj ustawienia sieci i czasu za pomocą strony Ustawienia Systemu.

Upewnij się, że VCAcore posiada licencję na wymagane funkcje, sprawdzając stronę Aktywacja.

Sprawdź czy urządzenie VCAbridge posiada aktualny firmware, jeśli nie, ZAKTUALIZUJ je.

Dodaj źródło wideo.

Utwórz kilka stref i reguł detekcji oraz SKALIBRUJ kanał.

Utwórz akcję aby wysyłać alerty do systemu innej firmy, lub sterować przekaźnikami.

Pamiętaj, że domyślna nazwa użytkownika i hasło dla urządzenia VCA to:

Użytkownik: admin

Hasło: admin

| Model | Maksymalne obsługiwane strumienie | Kodek | Bitrate |

|---|---|---|---|

| VBP3510 | 4x HD @ 15 kl/s LUB 8x D1 @ 15 kl/s LUB 16x VGA @ 15 kl/s |

H.264 | max 1500 kbps |

| VBP3500 | 4x HD @ 15 kl/s LUB 8x D1 @ 15 kl/s LUB 16x VGA @ 15 kl/s |

H.264 | max 1500 kbps |

| VBP2000 | 1x HD @ 15 kl/s LUB 2x D1 @ 15 kl/s LUB 4x VGA @ 15 kl/s |

H.264 | max 1500 kbps |

Zaleca się stosowanie CBR zamiast VBR ze względu na to, że zmienny bitrate (VBR) powoduje dość często dodatkowe niepożadane "szumy" w obrazie. Szczególnie za poruszającymi się obiektami. Zaleca się ustawienie wartości GOP w taki sposób aby klatka kluczowa pojawiała się raz na sekundę.

Po skonfigurowaniu podstawowych ustawień istotne mogą być następujące zaawansowane opcje:

Skonfiguruj klasyfikatory za pomocą funkcji klasyfikacji.

Wykryj sabotaż aparatu lub zaciemnienie za pomocą funkcji wykrywania sabotażu.

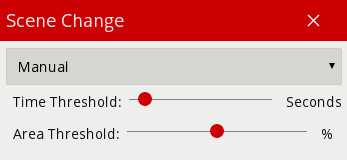

Dowiedz się, jak urządzenie wykrywa duże zmiany sceny za pomocą funkcji wykrywania zmiany sceny function.

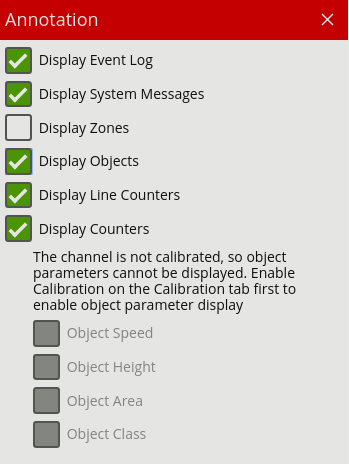

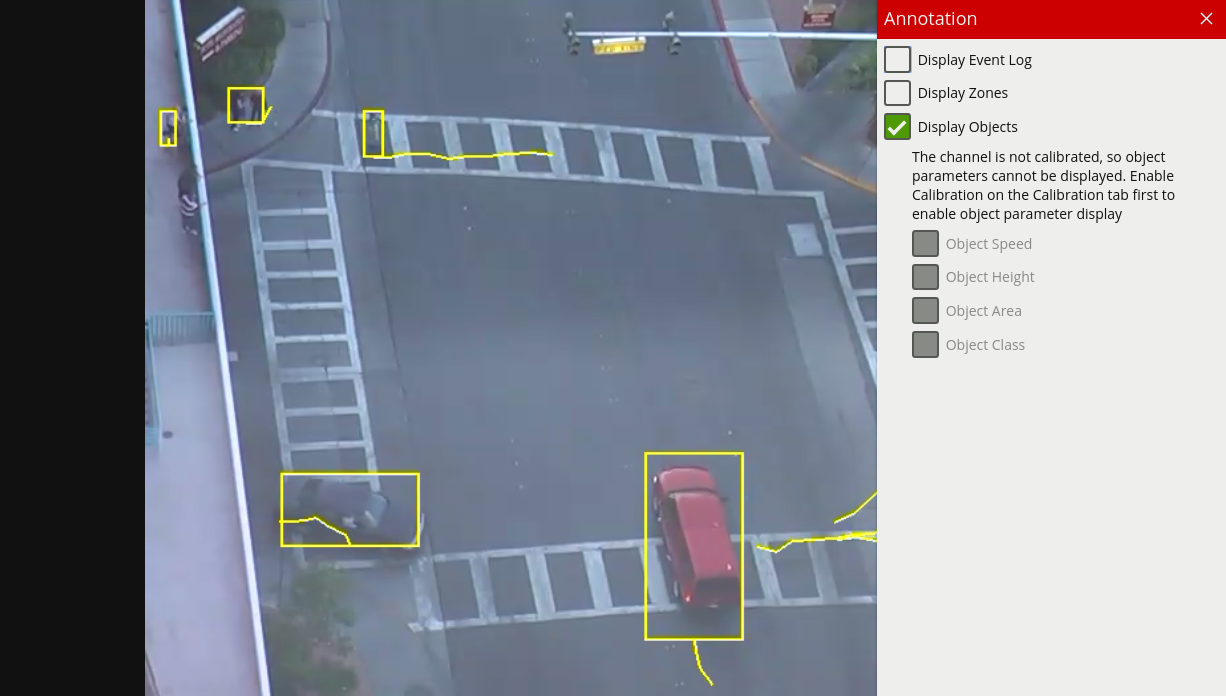

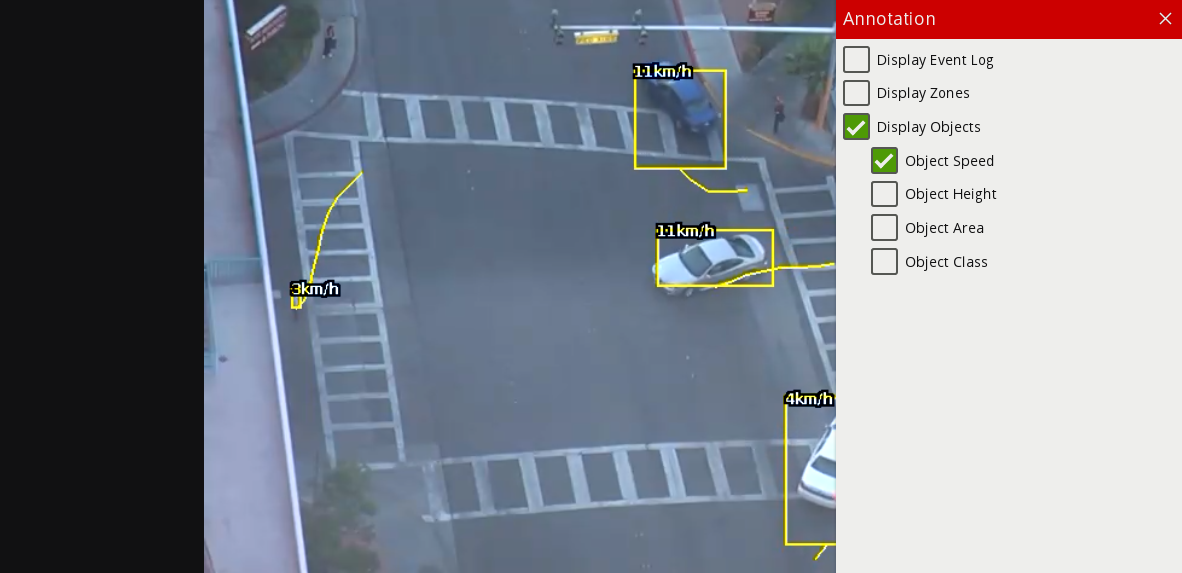

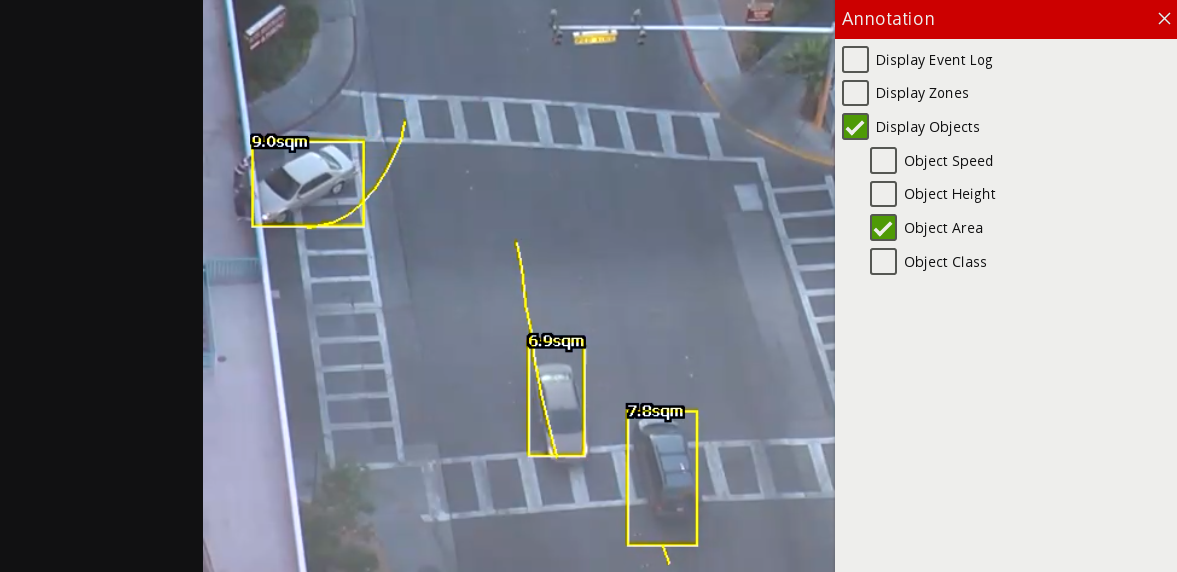

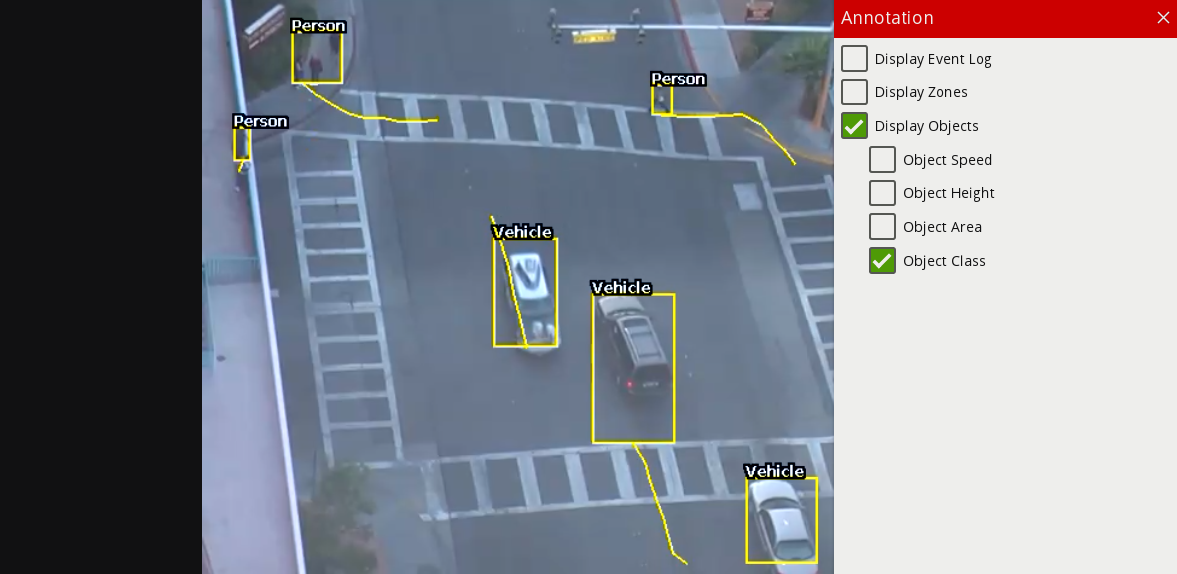

Dostosuj wyświetlanie dodatkowych adnotacji o obiekcie na obrazie wideo w ustawieniach nadukowywanie adnotacji.

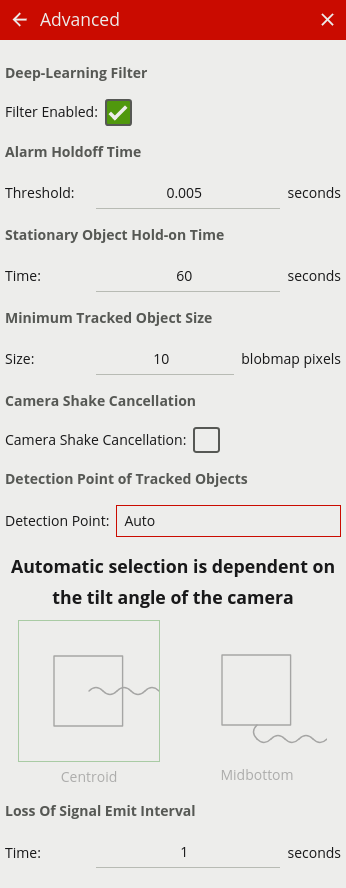

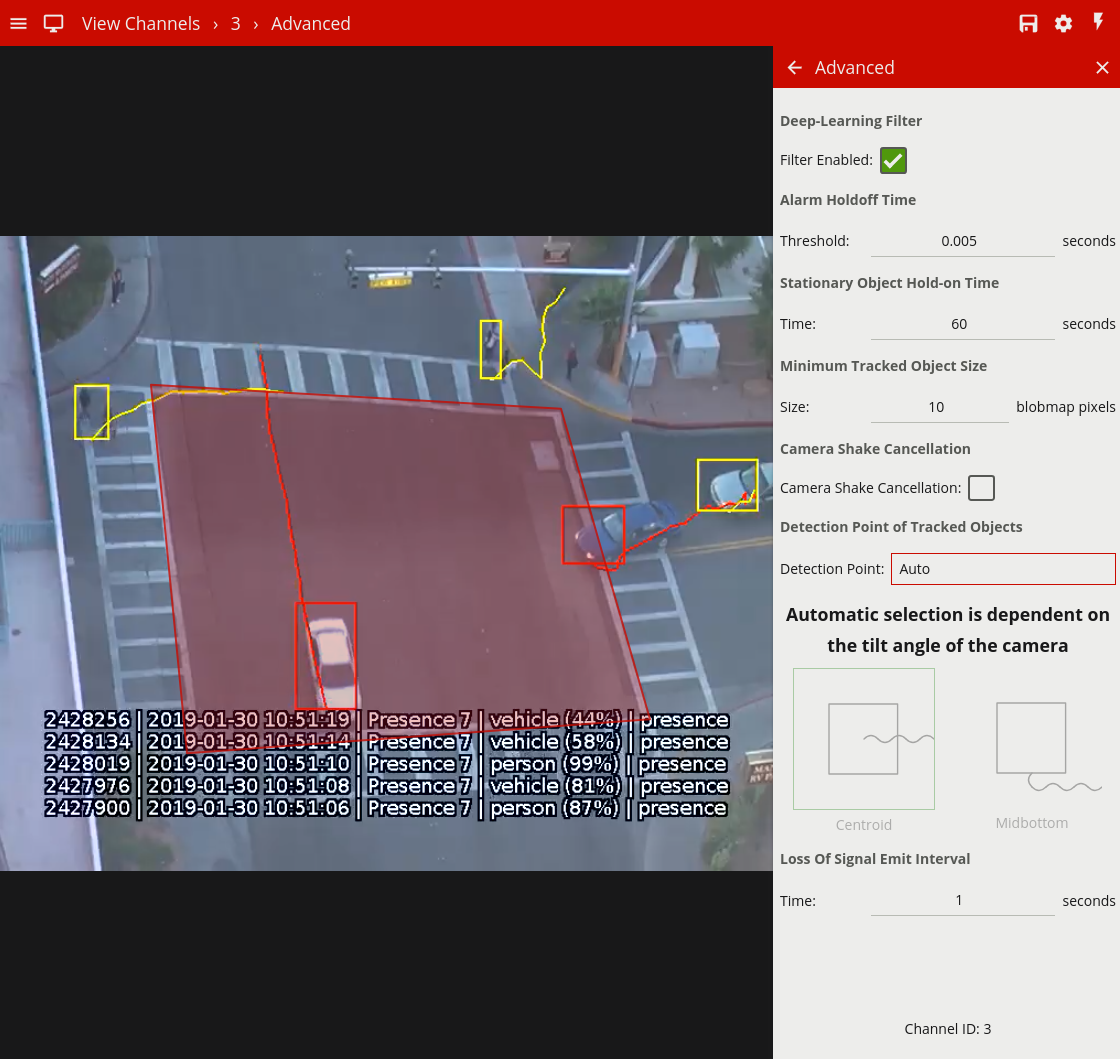

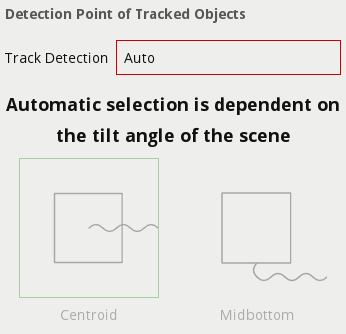

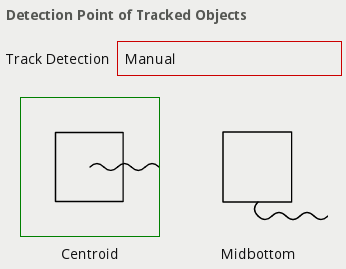

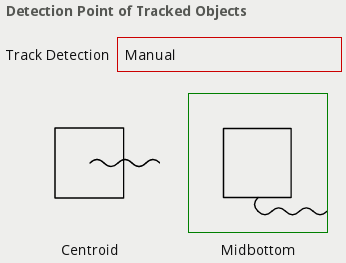

Dostosuj zaawansowane ustawienia, takie jak czas wstrzymania alarmu, punkt wykrywania i redukcję drgań, korzystając ze strony ustawień zaawansowanych.

Dodaj Integrację z oprogramowaniem Stacji Monitoringu Safestar aby wysyłać alerty z systemu do swojej Agencji Ochrony.

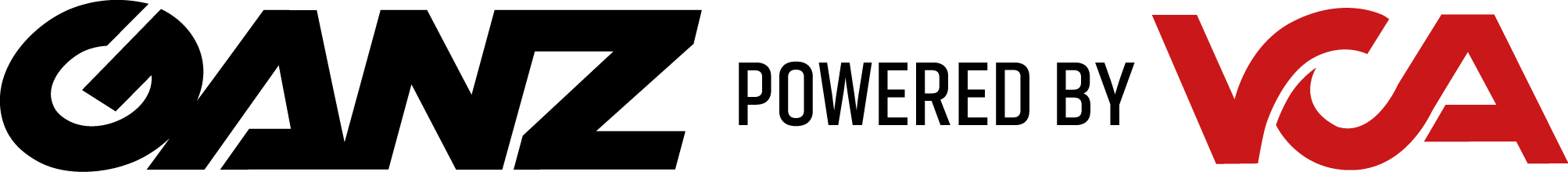

Narzędzie do wykrywania urządzeń może być używane do lokalizowania urządzeń VCAbridge w sieci.

Znajdź urządzenie VCAbridge w sieci i wybierz odpowiedni wiersz na liście w narzędziu wykrywania.

Narzędzie do wykrywania urządzeń jest dostępne na stronie internetowej www.cbcpoland.pl

Dowiedz się więcej, jak poruszać się po interfejsie, sprawdź i zaktualizuj wersję VCAcore lub powróć do Pierwszych Kroków.

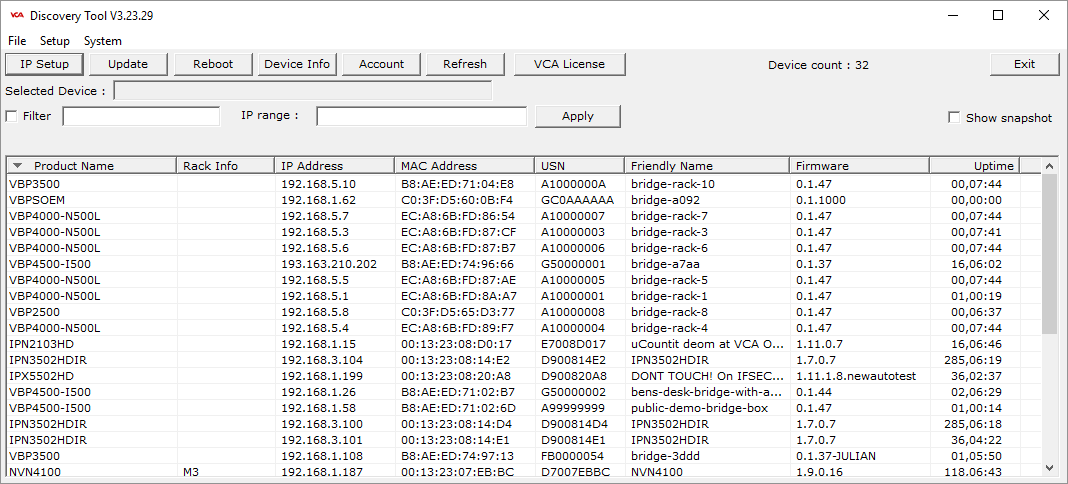

Ten temat zawiera ogólny przegląd elementów sterujących i kontrolnych interfejsu konfiguracyjnego VCAcore.

Interfejs użytkownika VCA zawiera stały pasek nawigacyjny wyświetlany w górnej części okna.

Na tym pasku nawigacji znajduje się wiele elementów, z których każdy jest opisany poniżej:

: Ikona menu. Kliknij ikonę menu, aby uzyskać dostęp do Menu Bocznego

w celu wygodnej nawigacji po aplikacji.

: Ikona menu. Kliknij ikonę menu, aby uzyskać dostęp do Menu Bocznego

w celu wygodnej nawigacji po aplikacji. : Ikona podglądu kanałów. Kliknij ikonę, aby przejść na stronę Podglądu

Kanałów.

: Ikona podglądu kanałów. Kliknij ikonę, aby przejść na stronę Podglądu

Kanałów. : Ikona stanu konfiguracji. Wskazuje aktualny stan synchronizacji konfiguracji między

interfejsem użytkownika a rzeczywistym urządzeniem. Może być w jednym z dwóch stanów:

: Ikona stanu konfiguracji. Wskazuje aktualny stan synchronizacji konfiguracji między

interfejsem użytkownika a rzeczywistym urządzeniem. Może być w jednym z dwóch stanów: : Wszystkie zmiany konfiguracji zostały pomyślnie zsynchronizowane między interfejsem WWW a urządzeniem.

: Wszystkie zmiany konfiguracji zostały pomyślnie zsynchronizowane między interfejsem WWW a urządzeniem. : Konfiguracja jest obecnie synchronizowana między interfejsem WWW a urządzeniem.

: Konfiguracja jest obecnie synchronizowana między interfejsem WWW a urządzeniem. : Ikona ustawień. Kliknij, aby przejść na Stronę Ustawień.

: Ikona ustawień. Kliknij, aby przejść na Stronę Ustawień. : Ikona uzbrajania / rozbrajania. Kliknij, aby zmienić Stan uzbrojenia / rozbrojenia urządzenia.

: Ikona uzbrajania / rozbrajania. Kliknij, aby zmienić Stan uzbrojenia / rozbrojenia urządzenia.Kliknięcie ikony  wyświetla boczne menu nawigacyjne:

wyświetla boczne menu nawigacyjne:

Każda strona interfejsu użytkownika VCA jest dostępna z menu bocznego. Ikona  obok elementu menu wskazuje,

że menu ma elementy podrzędne i można je rozwinąć.

obok elementu menu wskazuje,

że menu ma elementy podrzędne i można je rozwinąć.

Elementy w menu bocznym są automatycznie rozwijane, aby odzwierciedlić bieżącą lokalizację w interfejsie aplikacji.

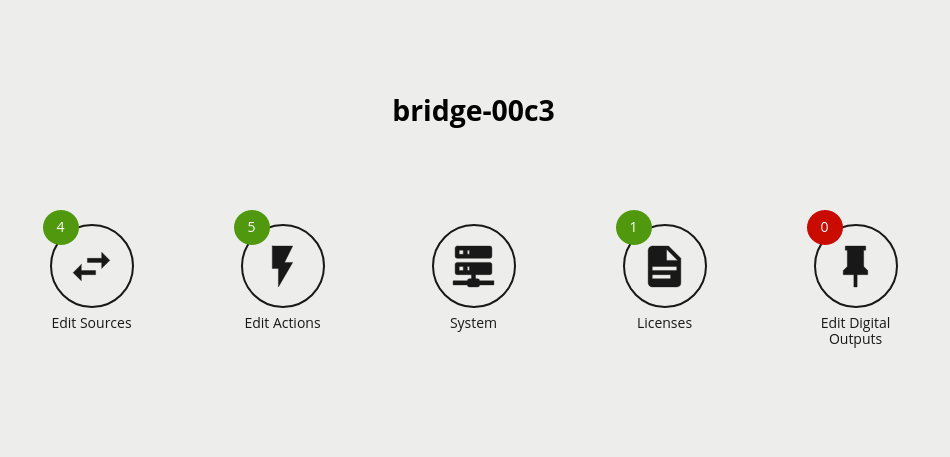

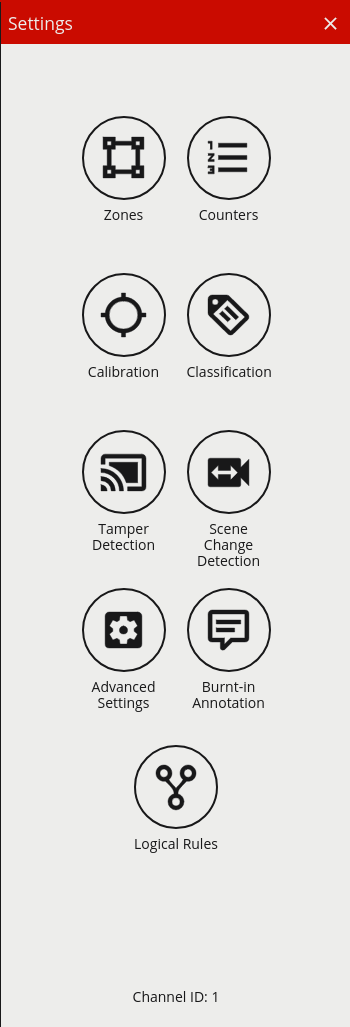

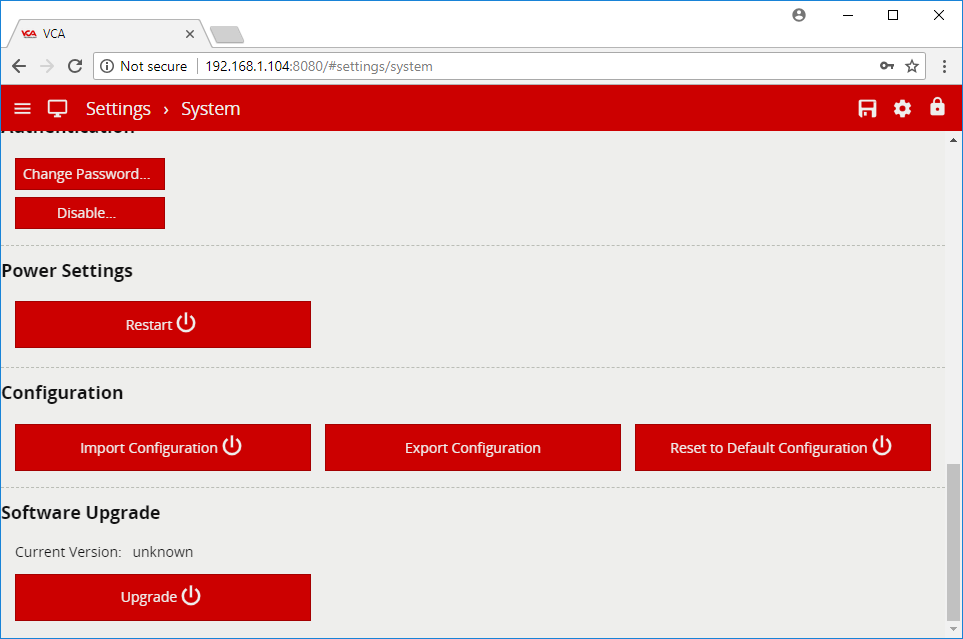

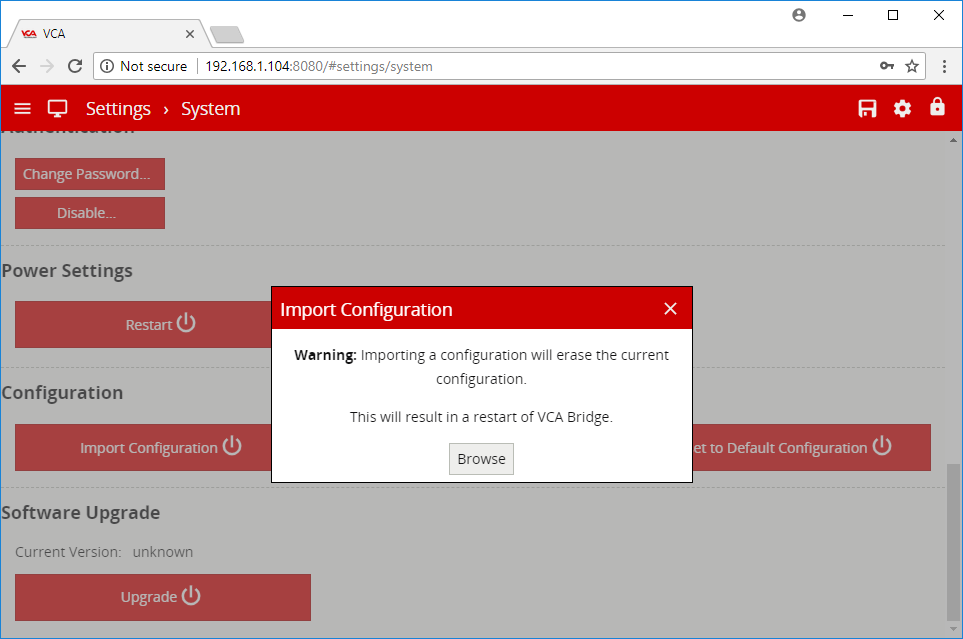

Strona ustawień wyświetla szereg linków do różnych stron konfiguracji:

Dowiedz się więcej o Aktywacji lub powróć do Pierwszych Kroków.

Aby utworzyć źródła i skorzystać z analityki VCAcore, wymagana jest licencja.

W wielu przypadkach VCAcore na platformie VCAbridge jest wstępnie aktywowany w fabryce, a dalsza aktywacja jest konieczna tylko w celu włączenia dodatkowej funkcjonalności. W przypadku VCAserver kod aktywacyjny, powiązany z konfiguracją sprzętową, zostanie dostarczony przez sprzedawcę.

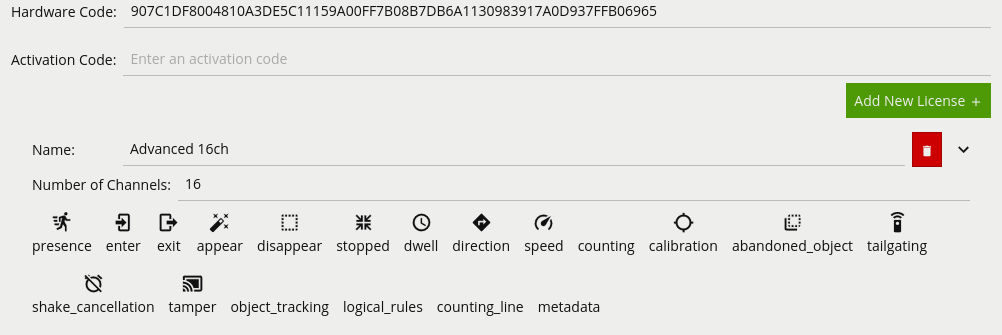

Dodatkowe funkcje można aktywować, wprowadzając nowy kod aktywacyjny do urządzenia. Każda licencja jest ważna tylko dla określonego urządzenia, a każde urządzenie jest jednoznacznie identyfikowane przez kod sprzętowy.

Aby zarządzać aktywacjami oraz by sprawdzić kod sprzętowy, przejdź do strony ustawień licencji:

Hardware Code: Unikalny kod sprzętowy tego urządzenia. Potrzebny do wygenerowania kodu aktywacyjnego.

Activation Code: Wprowadź kod aktywacyjny, aby włączyć dodatkowe funkcje lub kanały.

Lista zainstalowanych licencji i funkcji jest wyświetlana poniżej.

Skopiuj kod sprzętu i wyślij go do sprzedawcy sprzętu.

Sprzedawca wysyła zwrotnie kod aktywacyjny.

Zastosuj kod aktywacyjny do urządzenia i sprawdź, czy wymagane funkcje są aktywne.

Aby uzyskać więcej informacji na temat pełnej gamy dodatkowych funkcji, odwiedź CBC Poland

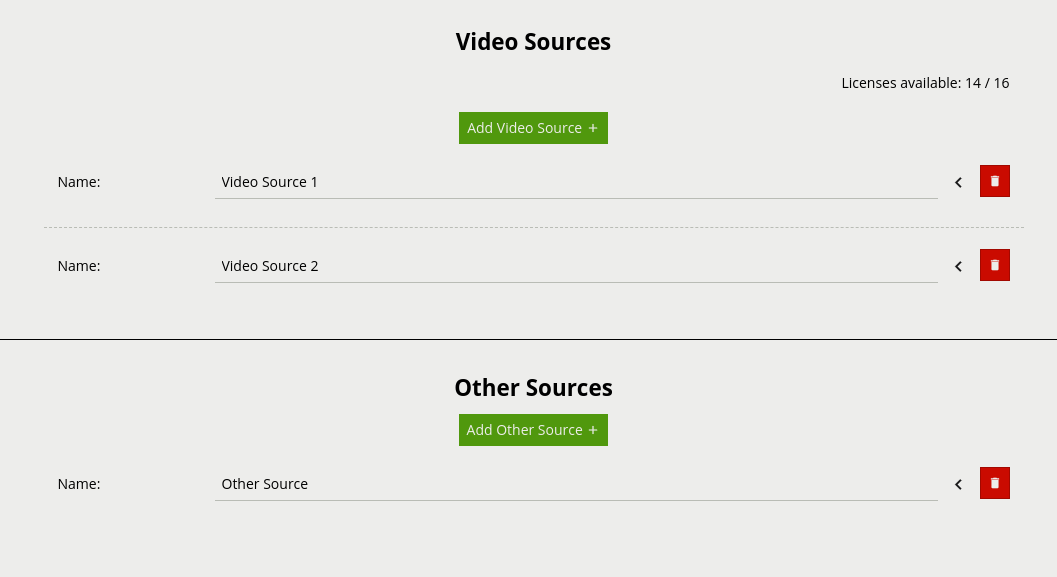

Źródła to konfigurowane przez użytkownika wejścia do systemu VCAcore, które obejmują źródła wideo (np. Strumienie RTSP) i źródła inne niż wideo (np. Wejścia cyfrowe). Strona Edytuj źródła umożliwia użytkownikom dodawanie / usuwanie źródeł i edytowanie istniejących źródeł.

Wspólne Właściwości:

Po dodaniu, źródła wideo są automatycznie łączone z kanałem. Liczba dostępnych źródeł wideo zależy od dostępnej licencji.

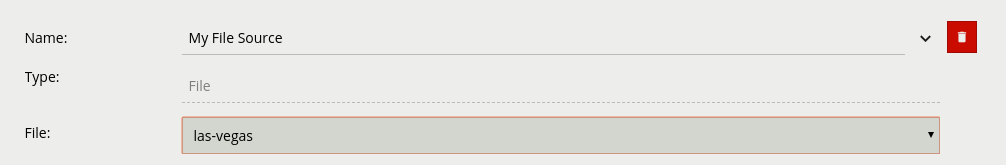

Źródła plików przesyłają strumień wideo z lokalnego pliku przykładowego osadzonego w oprogramowaniu VCAcore.

Właściwości

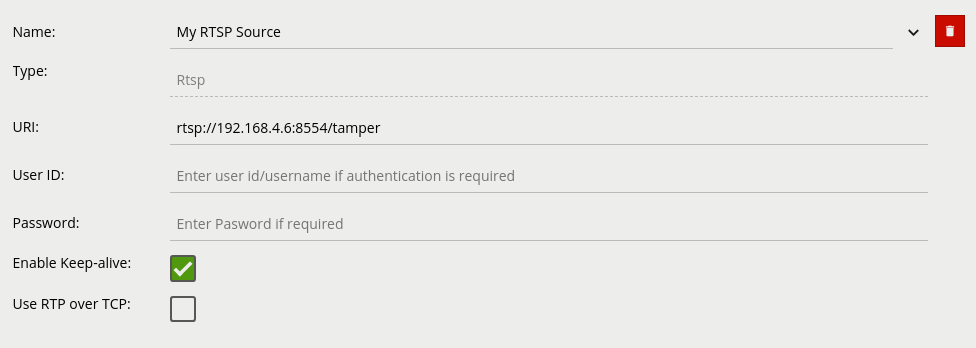

Źródła Rtsp przesyłają strumień wideo ze zdalnych źródeł RTSP, takich jak kamery IP i kodery.

Właściwości:

rtsp://ip-kamery:port-rtsp/strumień

rtsp://użytkownik:hasło@ip-kamery:port/strumień

Najlepszym sposobem na sprawdzenie prawidłowego adresu URI RTSP do kemery lub rejestratora, jest sprawdzenie jego za pomocą narzędzia ONVIF Device Manager, o ile dane urządzenie wspiera protokół ONVIF.

Poniżej przykładowe URI dla różnych producentów (domyślnie drugi strumień):

GANZ GenStar - rtsp://192.168.2.128:554/snl/live/1/2

GANZ Pixel Pro - rtsp://192.168.2.128:554/gnz_media/second

Dahua - rtsp://192.168.2.128:554/cam/realmonitor?channel=1&subtype=1&unicast=true&proto=Onvif

BCS - rtsp://192.168.2.128:554/cam/realmonitor?channel=1&subtype=1&unicast=true&proto=Onvif

Hik - rtsp://192.168.2.128:554/Streaming/Channels/102?transportmode=unicast&profile=Profile_1

Uwaga - W przypadku niektórych rozwiązań Dahua (Kamery Analogowe) należy zwrócić uwagę na ustawienia kodowania wideo, w niektórych przypadkach należy zmodyfikować ustawienia I-Frame, lub przepustowości, a czasem nawet zmienić kodek z H264H na zwykły H264 aby silnik prawidłowo śledził obiekty.

Uwaga - Zabrania się używania Smart Kodeków, albowiem modyfikują one obraz wynikowy.

Optymalne i zalecane parametry strumienia do poprawnej Analizy

Kamery, które na powyższych ustawieniach nie uzyskują dostatecznej jakości obrazu (widoczne artefakty kodowania) nie powinny być używane z Mostkiem, artefakty te będą wpływać na możliwość pojawienia się fałszywych wzbudzeń przy częstych zmianach sceny (chmury, załączenia świateł).

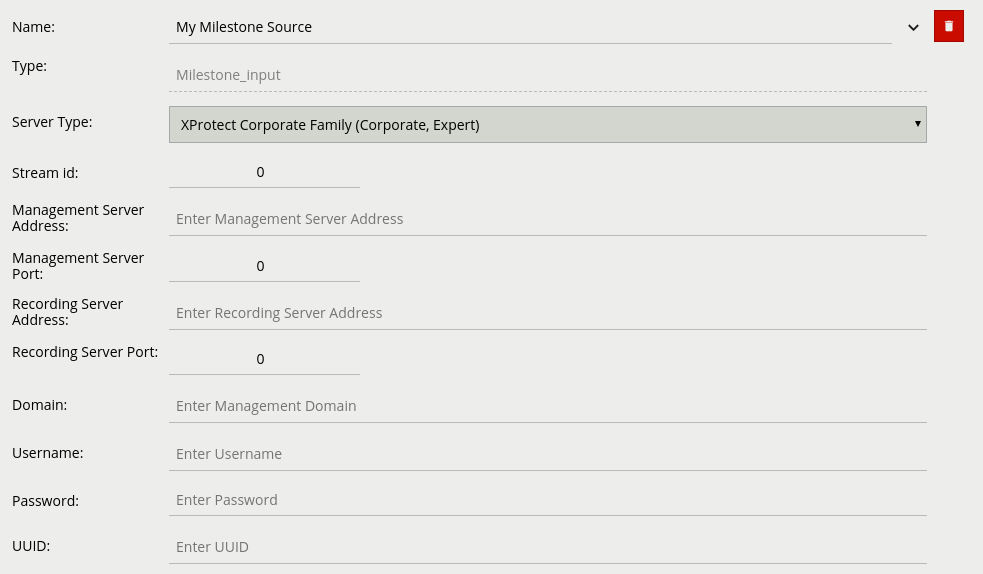

Źródła Milestone przesyłają strumień wideo z serwera Milestone XProtect VMS

Właściwości:

Różne inne źródła niż wideo są dostępne dla użytkownika. Po dodaniu, można je następnie przypisać do Akcji.

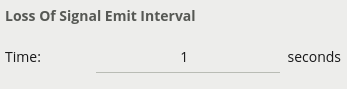

Źródła interwałów mogą być wykorzystywane do okresowego generowania zdarzeń, np. test (heartbeat), aby sprawdzić, czy urządzenie nadal działa.

Właściwości:

Jeśli dostępny jest moduł wejść cyfrowych, będą one widoczne na liście innych źródeł.

Właściwości:

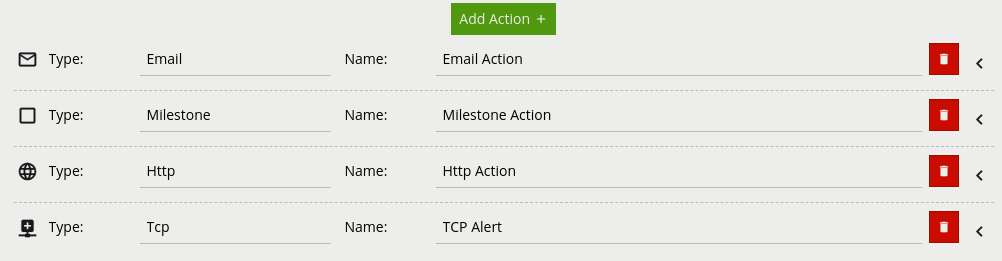

Akcje są wyjściami dowolnie konfigurowanymi przez użytkownika, które mogą być wyzwalane przez różne zdarzenia występujące w VCAcore.

Wspólne Właściwości:

Każda akcja może mieć przypisane wiele źródeł zdarzeń. Po przypisaniu źródła zdarzenia do akcji każde zdarzenie tego typu wywoła akcję. Dostępne źródła zdarzeń są pogrupowane według Źródła Wideo i obejmują albo VCA Analytics, reguły logiczne zdefiniowane przez użytkownika (z zaznaczonym polem „Can Trigger Action”) lub zdarzenie utraty sygnału i dowolne Wejście Cyfrowe lub Interwał.

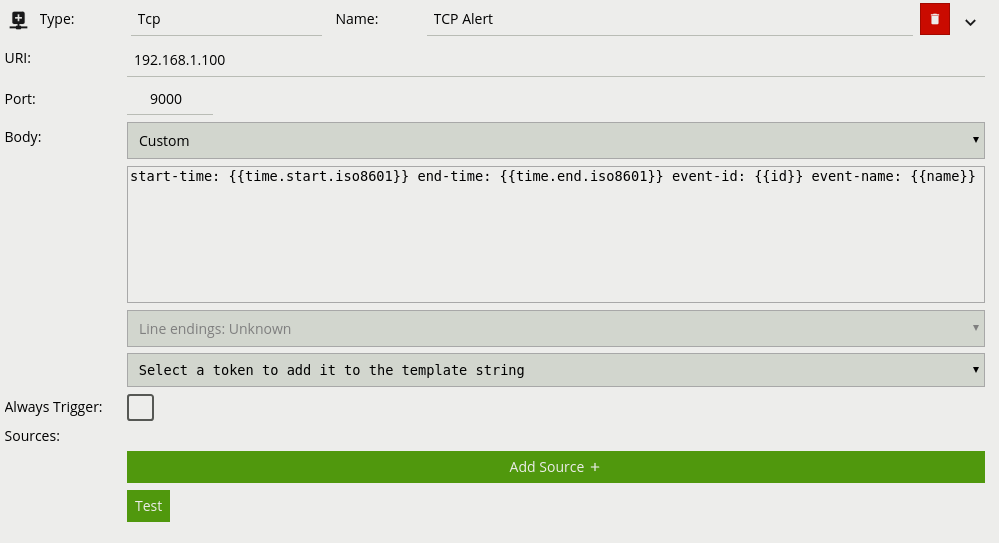

Akcja TCP wysyła dane do zdalnego serwera TCP po wyzwoleniu zdarzeniem. Format wysyłanej treści można konfigurować za pomocą zwykłego tekstu i Tokenów, które są zastępowane wartościami specyficznymi dla zdarzenia w momencie generowania zdarzenia.

URI: Adres IP lub nazwa hosta zdalnego serwera TCP, na który dane zdarzenia powinny być przesyłane.

Port: Port, na którym zdalny serwer TCP nasłuchuje.

Body: Treść komunikatu TCP do przesłania. Może być mieszaniną zwykłego tekstu i obsługiwanych Tokenów, które zostaną zastąpione danymi specyficznymi dla zdarzenia w momencie generowania zdarzenia. Domyślny szablon jest automatycznie dodawany podczas tworzenia wyjścia TCP.

Zobacz temat Tokeny, aby uzyskać szczegółowe informacje na temat systemu tokenów i przykładowych szablonów.

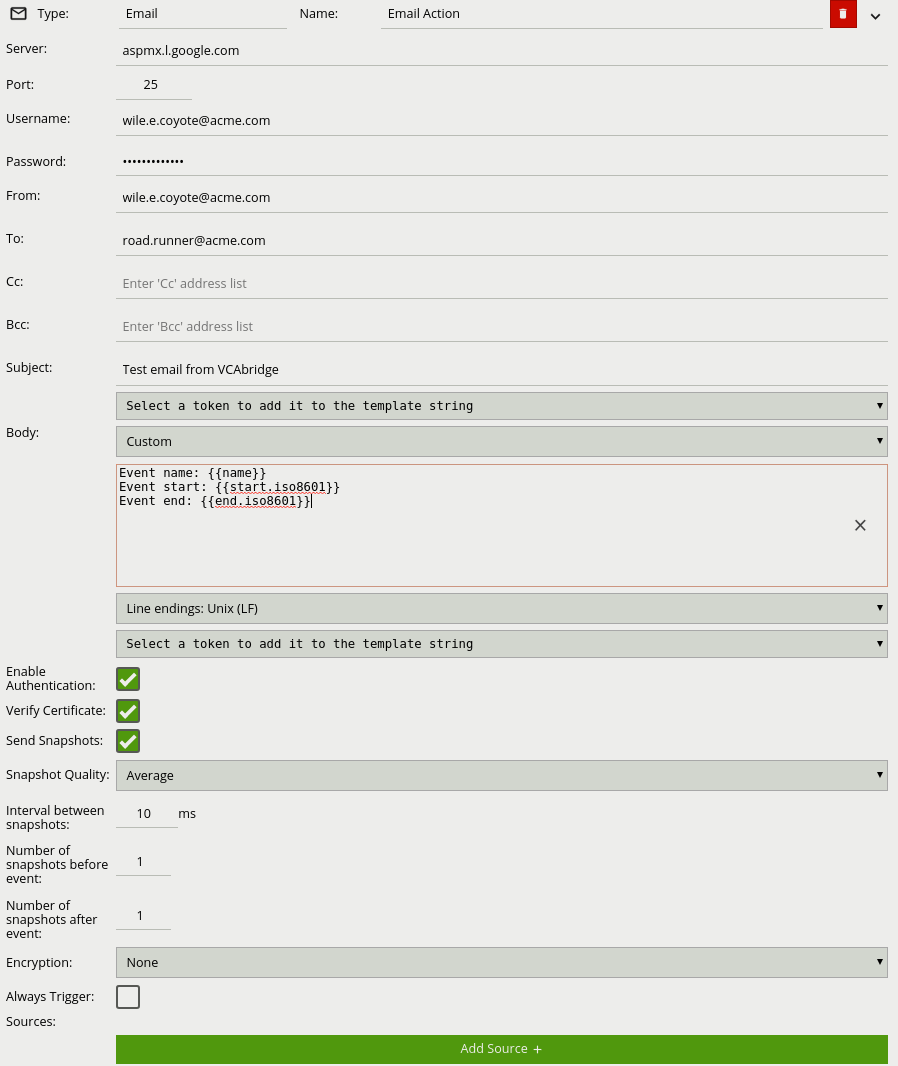

Akcja e-mail wysyła zdarzenia w formatach domyślnych lub skonfigurowanych przez użytkownika do zdalnych serwerów e-mail.

Server: Adres Serwera SMTP.

Port: Port Serwera SMTP.

Username: Login użytkownika konta e-mail używanego do wysyłania wiadomości e-mail na serwerze SMTP.

Password: Hasło użytkownika konta e-mail używanego do wysyłania wiadomości e-mail na serwerze SMTP.

From: Adres e-mail nadawcy.

To: Adres e-mail odbiorcy.

Cc: Adresy e-mail dowolnych odbiorców kopii.

Bcc: Adresy e-mail dowolnych ukrytych odbiorców kopii.

Subject: Tokenowany szablon tematu wiadomości e-mail.

Body: Tokenowany szablon treści e-mail.

Enable Authentication: Zaznacz, aby włączyć uwierzytelnianie SMTP.

Verify Certificate: Zaznacz, aby weryfikować zdalny certyfikat SSL.

Send Snapshots: Zaznacz, aby dołączyć do wiadomości e-mail zdjęcie z adnotacjami.

Snapshot Quality: Wybierz jakość zdjęć dołączonych do wiadomości e-mail. Więcej informacji na temat rozmiarów zdjęć w KB można znaleźć w poniższej tabeli.

Interval between snapshots: Ustaw szybkość przechwytywania kilku zdjęć w milisekundach (ms).

No of Snapshots sent before event: Ustaw liczbę zdjęć przed wystąpieniem zdarzenia, które chcesz dołączyć do wiadomości e-mail.

No of Snapshots sent after event: Ustaw liczbę zdjęć po wystąpieniu zdarzenia, które chcesz dołączyć do wiadomości e-mail.

Encryption: Typ szyfrowania używanego do komunikacji SMTP. Prawidłowe opcje to Brak, SSL i STLS.

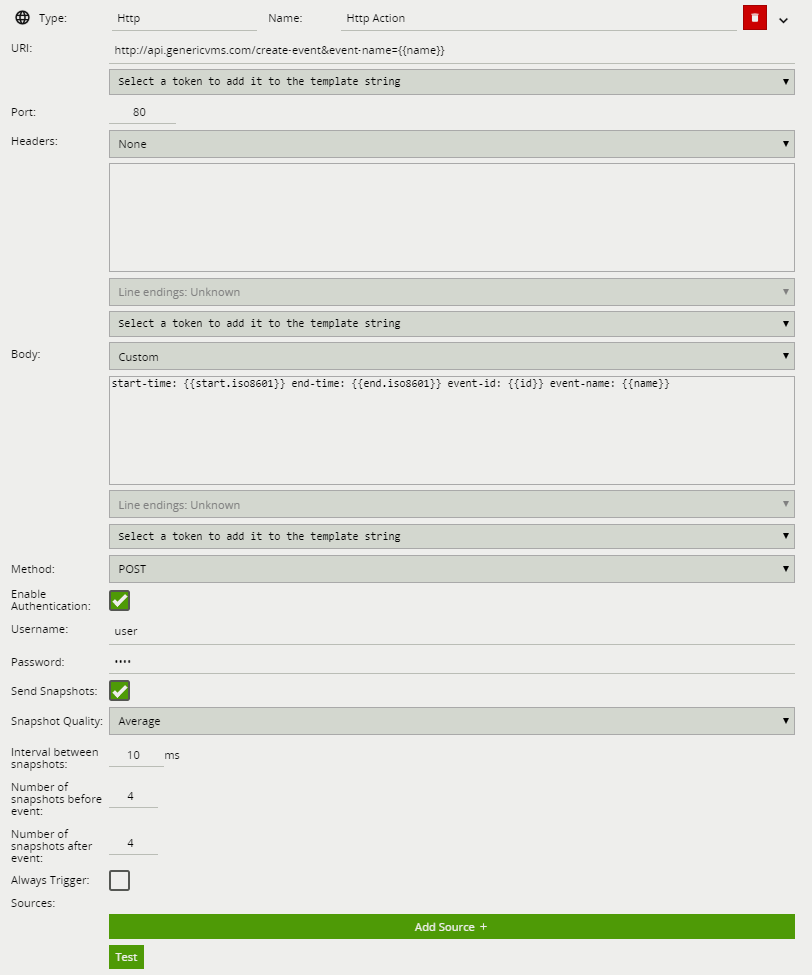

Akcja HTTP wysyła żądanie HTTP jako text/plain do zdalnego punktu końcowego po uruchomieniu. Adres URL, nagłówki HTTP i treść wiadomości

można konfigurować za pomocą zwykłego tekstu i tokenów, które są zastępowane wartościami specyficznymi dla zdarzenia w momencie generowania zdarzenia.

Dodatkowo, zdjęcia z kamery mogą być wysyłane jako żądanie multipart/form-data ze skonfigurowanymi zdjęciami dołączonymi jako image/jpeg.

URI: Zdalny URI, którego należy zażądać podczas wykonywania akcji HTTP. Jak pokazano na rysunku, identyfikator URI może

zawierać Tokeny, które zostaną zastąpione danymi specyficznymi dla zdarzenia w momencie generowania zdarzenia.

Jeśli podanie poświadczeń użytkownika w postaci zwykłego tekstu jest niepożądane, można je określić w sekcji Nagłówek

zakodowanej jako ciąg base64 jako część standardowego nagłówka Autoryzacji HTTP.

Port: Port serwera zdalnego.

Headers: Określa dowolne nagłówki HTTP do wysłania w żądaniu HTTP. Przykłady mogą obejmować Autoryzację lub nagłówki Content-Type.

Wszelkie niezbędne nagłówki będą zwykle określone przez interfejs zdalnego serwera API. Każdy nagłówek powinien być umieszczony w nowej linii.

Gdy nagłówki są przesyłane, CRLF (\r\n) jest automatycznie wstawiany między każdym nagłówkiem oraz między ostatnim nagłówkiem a treścią wiadomości.

Body: Określa treść żądania HTTP. Może być mieszaniną zwykłego tekstu i obsługiwanych Tokenów, które zostaną zastąpione danymi specyficznymi dla zdarzenia w momencie generowania zdarzenia. Domyślny szablon jest automatycznie dodawany podczas tworzenia akcji HTTP.

Method: Metoda żądania HTTP. Może być jedną z GET, POST, PUT, DELETE, HEAD. To ustawienie będzie zwykle określane przez interfejs zdalnego serwera API.

Enable Authentication: Zaznacz, aby włączyć uwierzytelnianie.

Username: Nazwa użytkownika używana do uwierzytelniania.

Password: Hasło używane do uwierzytelniania.

Send Snapshots: Zaznacz, aby dołączyć do żądania HTTP zdjęcie z adnotacjami (tylko dla metody POST).

Snapshot Quality: Wybierz jakość zdjęć dołączonych do żądania HTTP. Więcej informacji na temat rozmiarów zdjęć w KB można znaleźć w poniższej tabeli.

Interval between snapshots: Ustaw szybkość przechwytywania kilku zdjęć w milisekundach (ms).

No of Snapshots sent before event: Ustaw liczbę zdjęć przed wystąpieniem zdarzenia, które chcesz dołączyć do żądania HTTP.

No of Snapshots sent after event: Ustaw liczbę zdjęć po wystąpieniu zdarzenia, które chcesz dołączyć do żądania HTTP.

Zobacz temat Tokeny, aby uzyskać szczegółowe informacje na temat systemu tokenów i przykładowych szablonów.

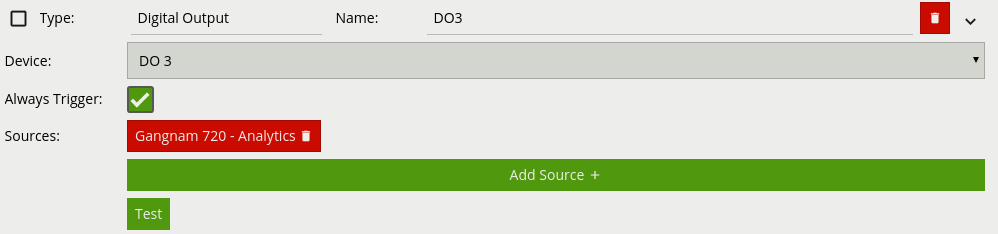

Wyjście cyfrowe jest logiczną reprezentacją fizycznego kanału wyjściowego. Aby skonfigurować właściwości fizycznego kanału wyjściowego, takie jak czas aktywacji, przejdź na stronę WE/WY Cyfrowe.

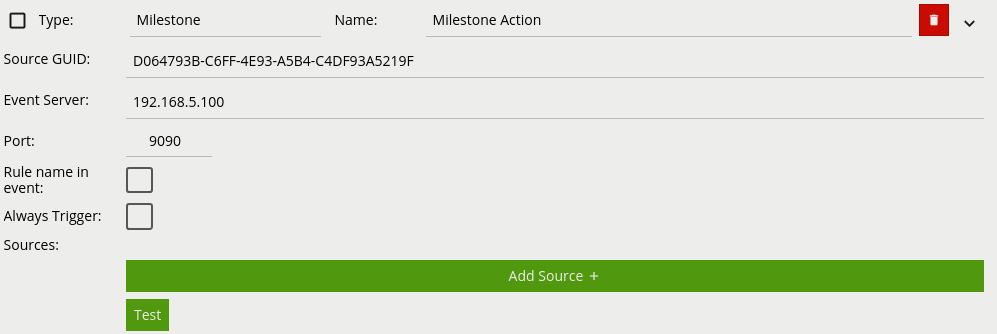

Akcja Milestone XProtect Event Server wysyła zdarzenia VCA do serwera zdarzeń Milestone XProtect VMS. Więcej informacji można znaleźć w temacie Milestone XProtect.

Source GUID: Identyfikator UUID XProtect, który identyfikuje kanał, któremu odpowiadają zdarzenia VCA. Powinien być zgodny z identyfikatorem UUID określonym dla wejścia Milestone XProtect.

Event Server: Adres IP lub nazwa hosta XProtect Event Server.

Port: Port, na którym XProtect Event Server nasłuchuje za zdarzeniami.

Rule name in event: Dołącz nazwę reguły, która wywołała akcję w wygenerowanym zdarzeniu.

Akcja Uzbrajania ustawia stan urządzenia na uzbrojony po wyzwoleniu.

Rozbrojenie ustawia stan urządzenia na rozbrojenie po wyzwoleniu.

Funkcja Uzbrajania / Rozbrajania umożliwia wyłączenie / włączenie wszystkich skonfigurowanych akcji. Na przykład, użytkownicy mogą chcieć wyłączyć wszystkie akcje alarmowe, gdy aktywność na obiekcie jest normalna i oczekiwana (np. podczas normalnych godzin pracy) i ponownie włączyć akcje, gdy aktywność na obiekcie nie jest oczekiwana.

Stan Uzbrajania / Rozbrajania można przełączać ręcznie, klikając ikonę kłódki w Pasku Nawigacyjnym lub używając akcji uzbrojenia lub rozbrojenia powiązanej z wejściami cyfrowymi lub komendami.

Do Akcji w mostku należy dodać dwie konfiguracje powiadomień HTTP, aby mostek niezależnie wysyłał zdarzenia do obsługi w Safestar, nieważne czy dodaliśmy integrację czy nie, ta czynność jest obowiązkowa. Mostek też może działać autonomicznie jako nadajnik alarmów w Safestar (bez wideo):

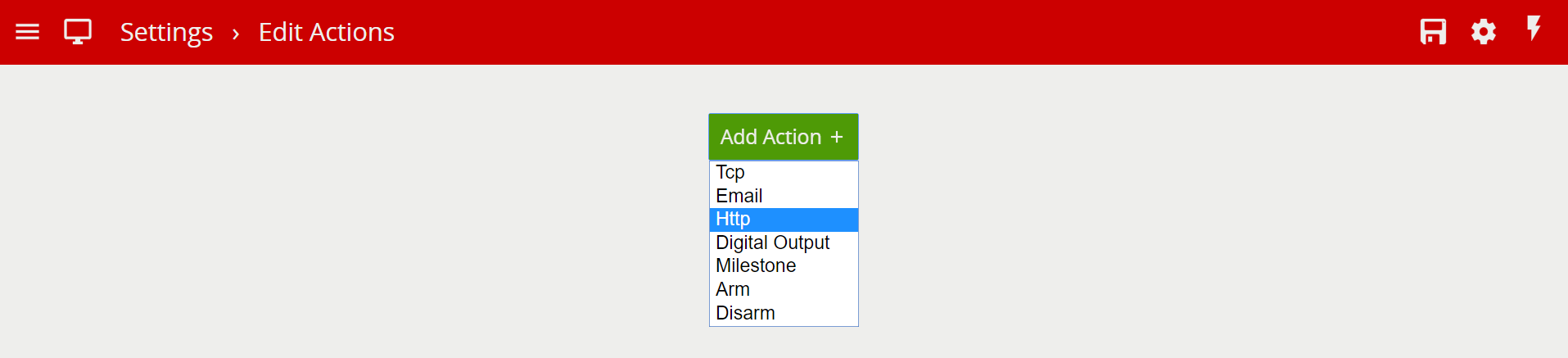

Przechodzimy do strony Ustawień klikając na ikonę  kolejnie otiweramy "Edit Actions" a następnie dodajemy akcję HTTP klikając na "Add Action +".

kolejnie otiweramy "Edit Actions" a następnie dodajemy akcję HTTP klikając na "Add Action +".

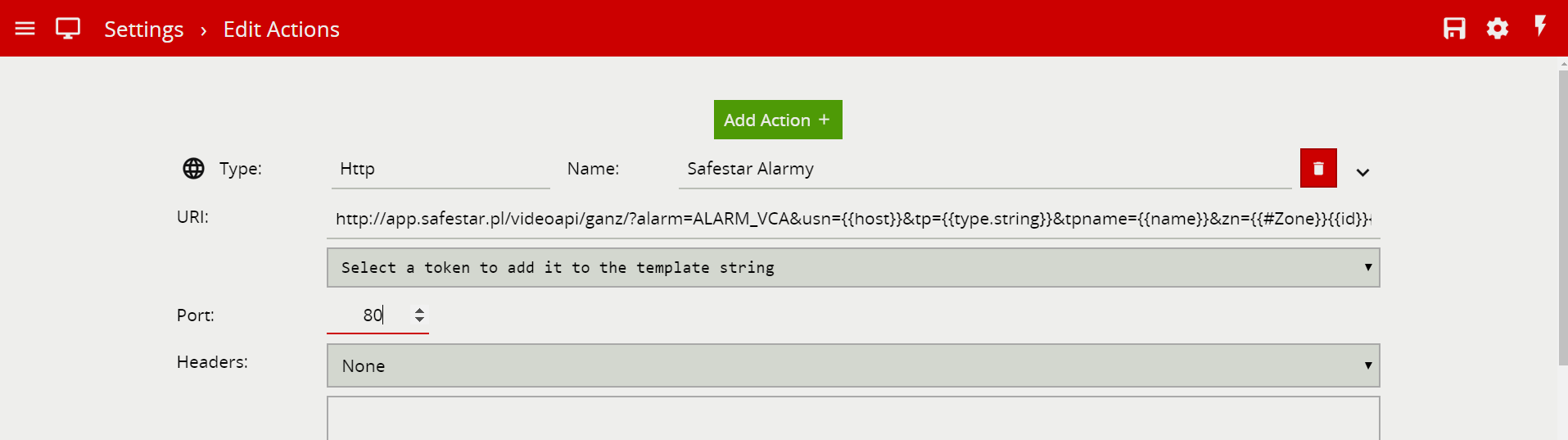

W polu Name wpisujemy nazwę, np. Safestar Alarmy, następnie klikamy w ikonę ![]() aby rozwinąć szczegółową konfigurację.

aby rozwinąć szczegółową konfigurację.

Następnie w polu URI wklejamy w całości poniższy ciąg, a w polu Port wpisujemy 80.

http://app.safestar.pl/videoapi/ganz/?alarm=ALARM_VCA&usn={{host}}&tp={{type.string}}&tpname={{name}}&zn={{#Zone}}{{id}}{{/Zone}}&ch={{#Channel}}{{id}}{{/Channel}}&rl={{#Rule}}{{id}}{{/Rule}}&cl={{#Object}}{{#Classification}}{{value}}{{/Classification}}{{/Object}}

Resztę pozostawiamy bez zmian, przewijamy teraz stronę na sam dół.

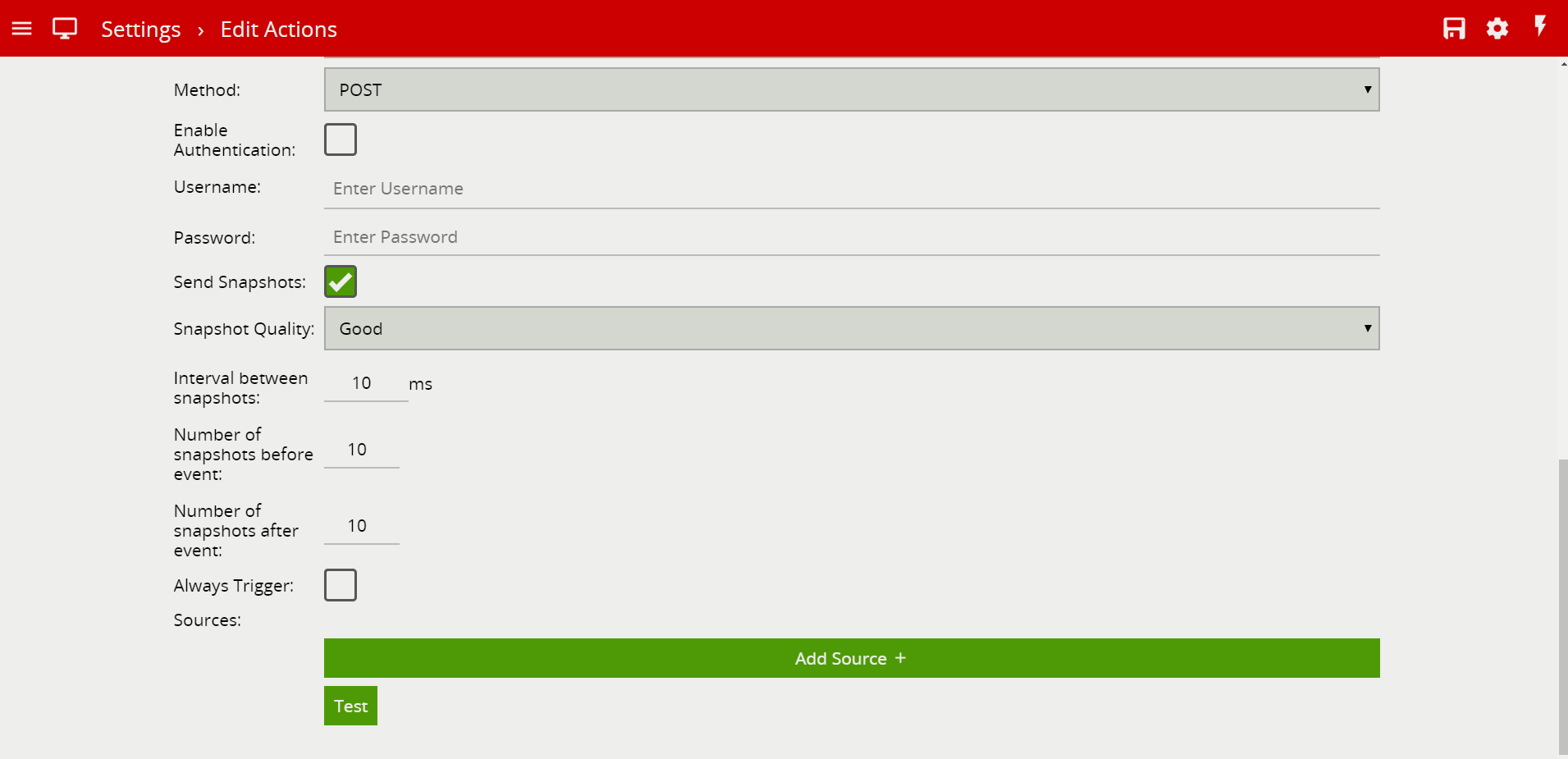

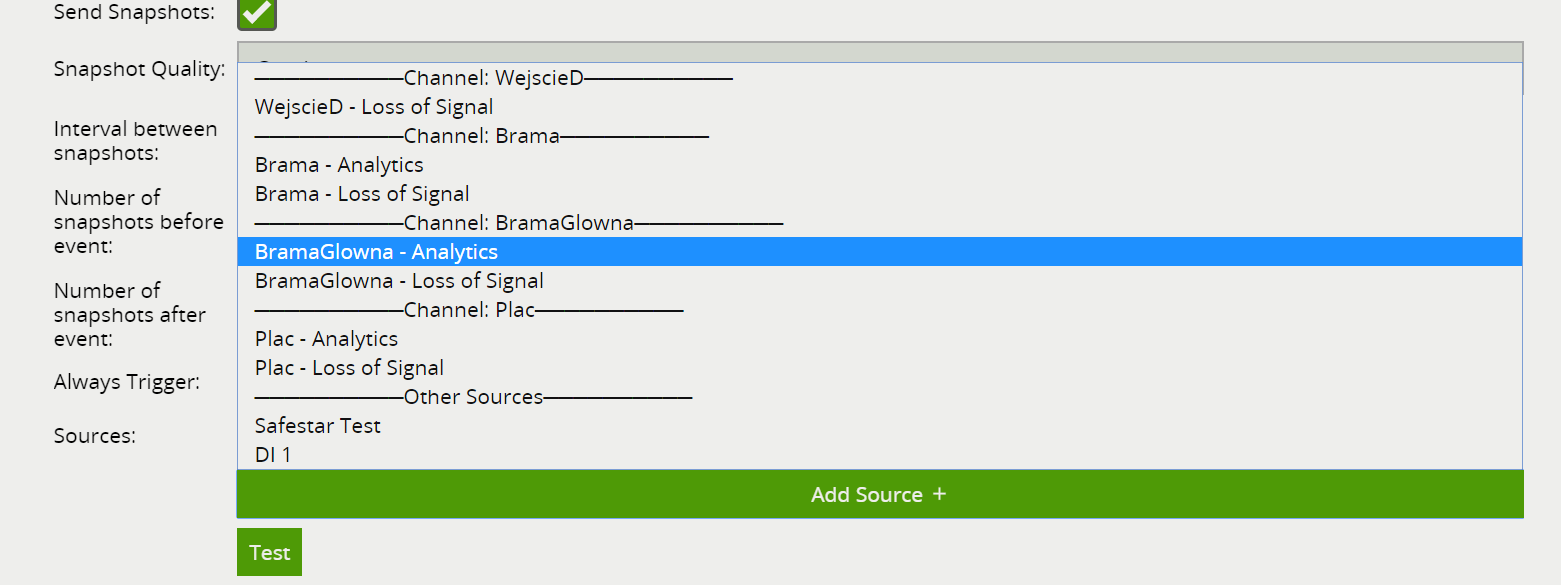

W polu Method wybieramy POST, zaznaczamy opcję Send Snapshots (wysyłanie zdjęć ze zdarzenia), możemy dostosować ich jakość Snapshot Qualtiy (jeśli ma to znaczenie, zmniejszy lub zwiększy nam zużycie internetu), następnie wybieramy odstęp między zdjęciami (Interval between snapshots), ilość zdjęć zrobionych przed zdarzeniem (Number of snapshots before event) oraz po zdarzeniu (Number of snapshots after event).

Domyślnie możemy wpisać w tych trzech polach 10, daje najlepsze efekty, natomiast jeśli chcemy zaoszczędzić na łączu internetowym można ilość zdjęć ograniczyć.

Ostatnią opcją jest Always Trigger (Wyzwalaj Zawsze), gdy nie zaznaczymy tej opcji, Mostek będzie reagował na stan uzbrojenia / rozbrojenia i tym samym, wysyłał zdarzenia do Safestar tylko wtedy gdy jego stan jest uzbrojony i odwrotnie gdy nie uzbrojony nie będzie marnował łącza i wysyłał jakichkolwiek zdarzeń.

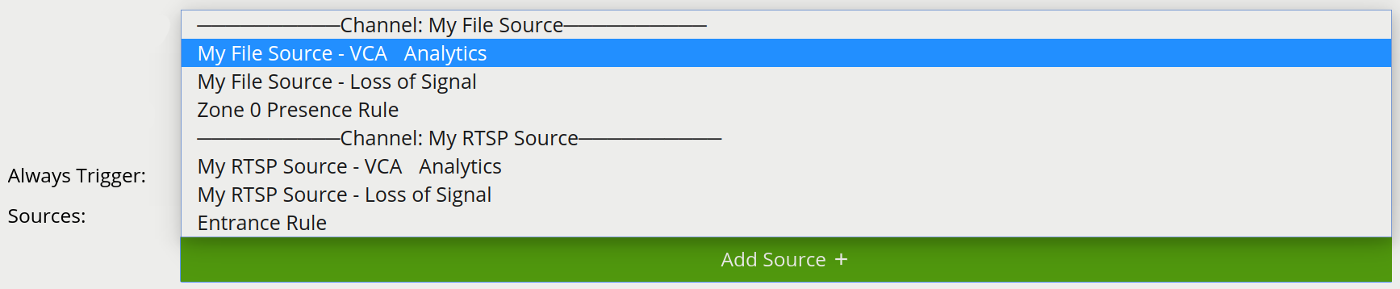

Jeśli mamy skonfigurowane już jakieś kanały, w tym miejsu też wybieramy, z których kanałów chcemy wysyłać zdarzenia do Safestar, klikając w "Add Source +" mamy możliwość wyboru kanału Analizy (Analytics), Utraty Połączenia z Kamerą (Loss of Signal), Naruszeń Wejść Cyfrowych (DI1) lub też sygnałów testowych Interval nazwanym tu Safestar Test.

Dodatkowe sygnały jak Interwał testów wysyłanych z Mostka lub naruszeń wejść cyfrowych, w pierwszej kolejności musimy dodać je w Innych Źródłach (Other Sources)

WAŻNA UWAGA: Pamiętajmy, że w przypadku gdy włączamy sterowanie uzbrajaniem / rozbrajaniem Mostka, do tej pierwszej dodanej akcji przy odznaczonym "Always Trigger" NIE DODAJEMY sygnałów takich jak Loss of Signal, Interval czy Naruszeń Wejść DI. W tym celu należy dodać nową identyczną akcję jak powyższa, nazwać ją np. Safestar Testy i zaznaczyć opcję "Always Trigger" aby Mostek zawsze wysyłał te informacje niezależnie czy jest uzbrojony czy rozbrojony!

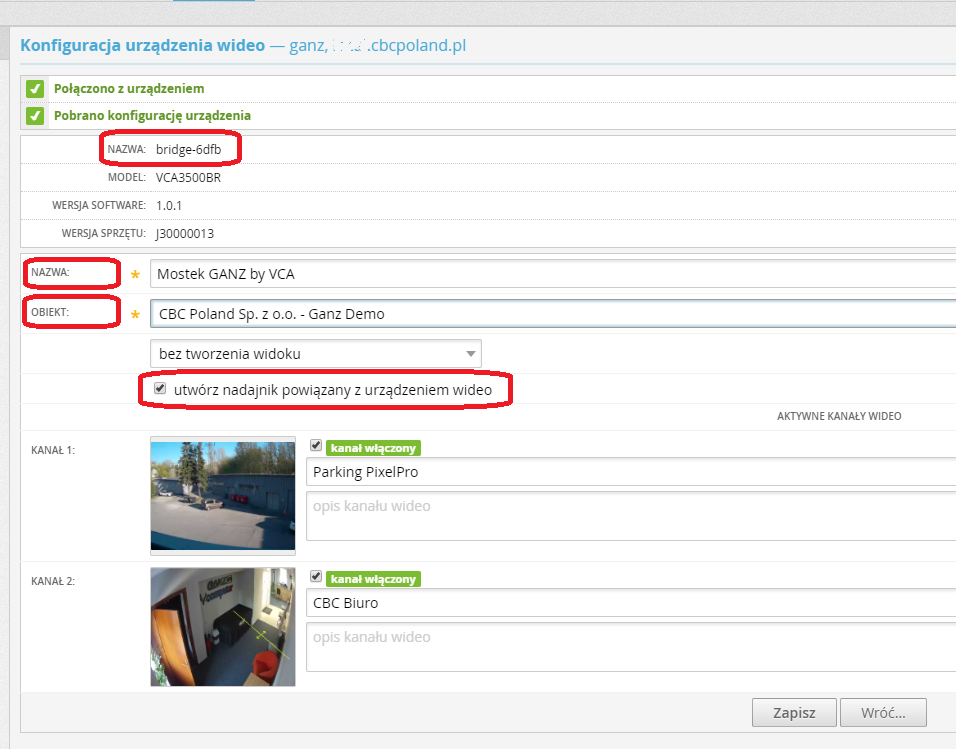

To już prawie wszystko, przechodzimy teraz na stronę Aplikacji Stacji Monitoringu Safestar (DMSI Sp. z o.o.), logujemy się na swoje konto, przechodzimy do URZĄDZEŃ WIDEO i dodajemy nowe urządzenie wybierając kafelek GANZ by CBC. Podajemy zewnętrzny adres Mostka, port komunikacji domyślnie 80, port wideo domyślnie 554, oraz Użytkownika i Hasło, KLIKAMY "Dalej...".

UWAGA!! W przypadku wystawiania urządzeń na zewnątrz na domyślnych portach, KONIECZNIE zmieniamy domyślne hasło do urządzenia, za pozostawienie domyślnego - NIE ODPOWIADAMY!

Na kolejnej podstronie, bardzo ważne są 4 pola. Pierwsze z nich to Nazwa, która jest pobierana z urządzenia, jest to numer sprzętowy nadajnika po jakim jest rozpoznawany w Safestar. Można go zmienić w Mostku w ustawieniach sieci, edytując Host Name, pamiętając przy tym by później zmienić go też na identyczny w Safestar.

Kolejne pole to Nazwa wyświetlana urządzenia w Safestar, możemy tu wpisać dowolną nazwę tak aby urządzenie było łatwo rozpoznać w systemie. Następnie podajemy Obiekt, do którego urzadzenie ma należeć oraz zaznaczamy aby automatycznie stworzyło nadajnik, to wszystko klikamy "Zapisz"

Wyczerpujące informacje jak dodać mostek krok po kroku, znajdziesz w poniższym materiale szkoleniowym w postaci wideo.

VCA obsługuje sprzęt wejść i wyjść cyfrowych do współpracy z systemami innych producentów. Wejścia cyfrowe mogą być używane jako wyzwalacze dla zdarzeń w VCAcore, a wyjścia cyfrowe mogą być wyzwalane przez VCAcore lub inne zdarzenie systemowe.

Konfiguracja wejść i wyjść cyfrowych składa się z trzech zadań:

Skonfiguruj fizyczne kanały WE/WY

Przypisz fizyczne kanały wejściowe do logicznych Źródeł

Przypisz fizyczne kanały wyjściowe do logicznych Akcji

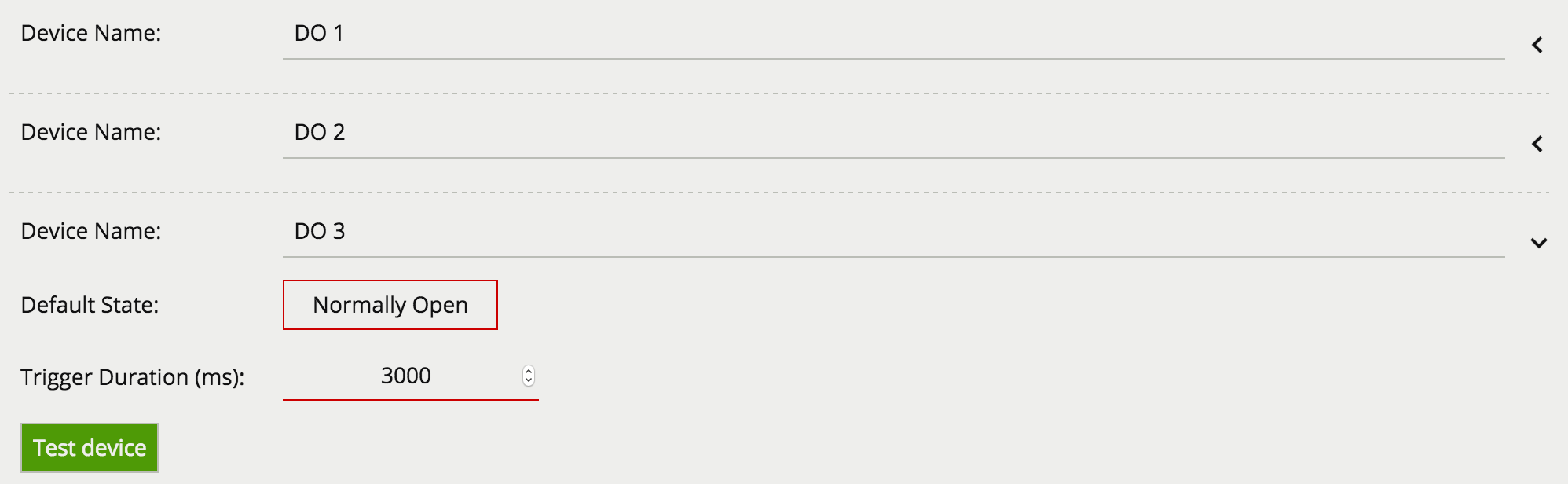

Na stronie Ustawienia wybierz Edit Digital Outputs, aby uzyskać dostęp do konfiguracji wyjść w urządzeniu.

Strona konfiguracji cyfrowego urządzenia wyjściowego zawiera sekcję dla każdego wyjścia. Należy pamiętać, że liczba dostępnych wyjść zależy od konkretnego używanego modelu urządzenia.

Wyjścia cyfrowe mogą być wyzwalane przez szereg źródeł zdarzeń analitycznych. Każdy kanał wyjściowy ma następujące właściwości:

Device Name: Nazwa wyjścia.

Default State: Domyślny stan wyjścia cyfrowego, gdy nie jest wyzwolone. Może być Normalnie Otwarty (NO) lub Normalnie Zamknięty (NC).

Po skonfigurowaniu jako Normalnie Otwarte wyjście będzie otwarte (low), gdy jest nieaktywne i zamknięte (high), gdy jest aktywne.

Po skonfigurowaniu jako normalnie zamknięte zachowanie jest odwrotne. Więcej informacji można znaleźć w tabeli.

| Domyślny Stan | DO Nieaktywne | DO Aktywne |

|---|---|---|

| Normalnie Otwarty | Otwarty (Low) | Zamkniety (High) |

| Normalnie Zamknięty | Zamkniety (High) | Otwarty (Low) |

Trigger Duration(ms): Czas aktywacji wyjścia cyfrowego w milisekundach. Po wyzwoleniu wyjścia cyfrowego zostanie ono aktywowane na określony czas, po czym zostanie wyłączone. Kolejne wyzwolenia, gdy wyjście cyfrowe jest już aktywne, są ignorowane.

Test Device: Kliknięcie przycisku aktywuje wyjście cyfrowe na określony czas. Jest to przydatne do sprawdzenia, czy urządzenia zewnętrzne są prawidłowo podłączone do wyjścia cyfrowego.

Po skonfigurowaniu wyjścia cyfrowego kanały sprzętowe muszą być przypisane do Akcji.

W urządzeniu VCAbridge jest dostępnych wiele wbudowanych cyfrowych kanałów WE/WY. Różne modele obsługują różne ilośći WE/WY. Szczegółowe informacje na temat wyprowadzeń złącza WE/WY można znaleźć w podręczniku szybkiego startu dołączonym do urządzenia. Podręczniki szybkiego startu są również dostępne na stronie CBC Poland

Aby cyfrowe kanały WE/WY mogły współdziałać z VCAcore i zdarzeniami systemowymi, należy utworzyć Źródła dla wejść cyfrowych i Akcje dla wyjść cyfrowych.

Zobacz stronę Ustawienia Systemu, aby uzyskać więcej opcji konfiguracji wejść cyfrowych.

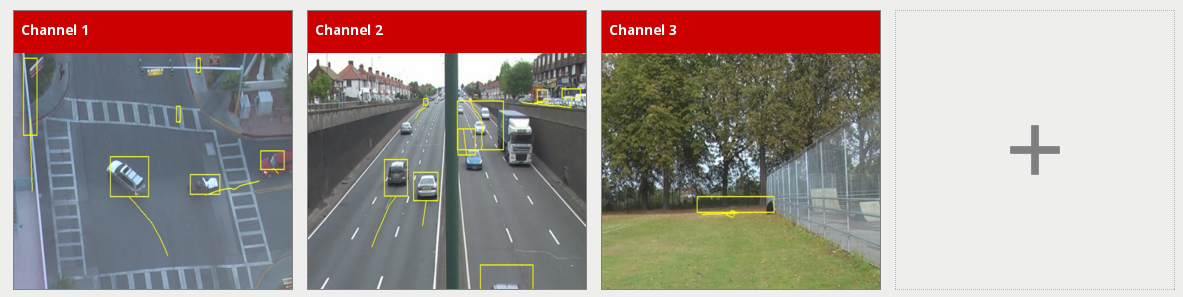

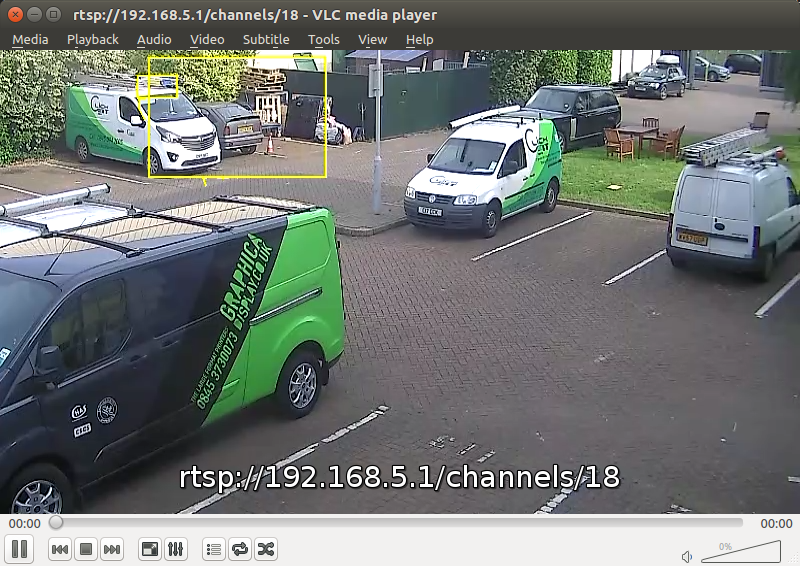

Po skonfigurowaniu kanału za pomocą odpowiedniego Źródła Wideo można go wyświetlić na stronie Podgląd Kanałów. Miniatura (lub komunikat o błędzie) jest wyświetlany dla każdego skonfigurowanego kanału. Należy zauważyć, że wyświetlane tu miniatury są odświeżane co kilka sekund, nie jest to płynny podgląd.

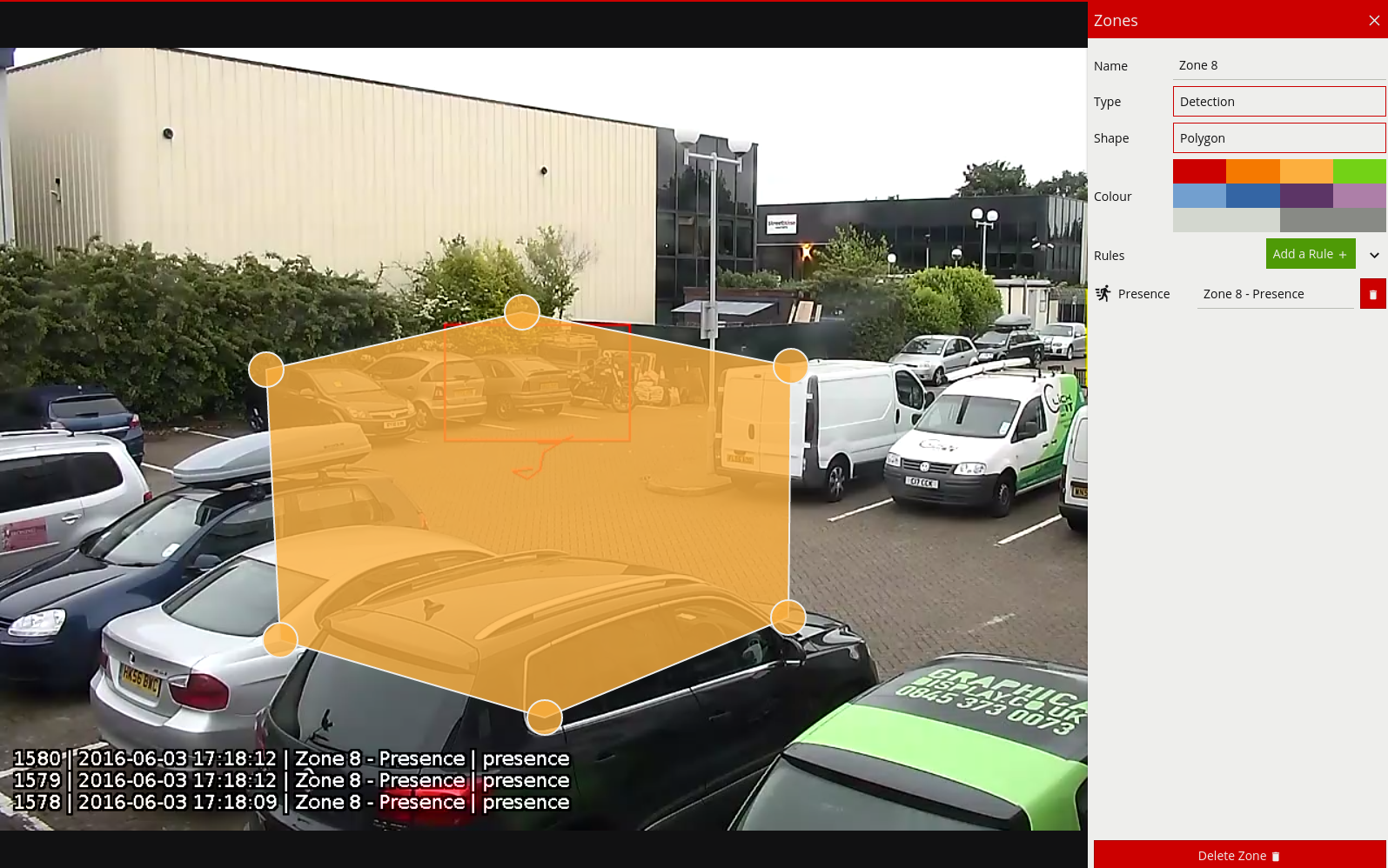

Kliknij w miniaturę, aby wyświetlić kanał oraz skonfigurować ustawienia związane z VCAcore.

Po kliknięciu kanału wyświetlany jest pełny widok strumienia wideo danego kanału wraz ze skonfigurowanymi strefami, licznikami i regułami.

Karta z ikoną  jest wyświetlana po prawej stronie strony.

Kliknij ją, aby otworzyć menu ustawień kanału.

jest wyświetlana po prawej stronie strony.

Kliknij ją, aby otworzyć menu ustawień kanału.

To menu zawiera różne przydatne linki do konfiguracji różnych aspektów kanału:

Gdy skonfigurowaliśmy już kanał możemy przejść do konfigurowania stref i reguł w celu wykrywania określonych scenariuszy.

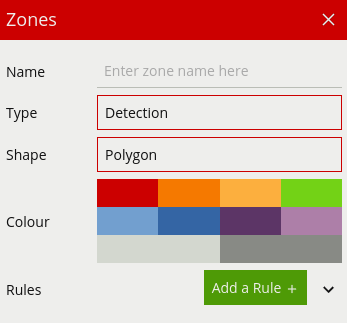

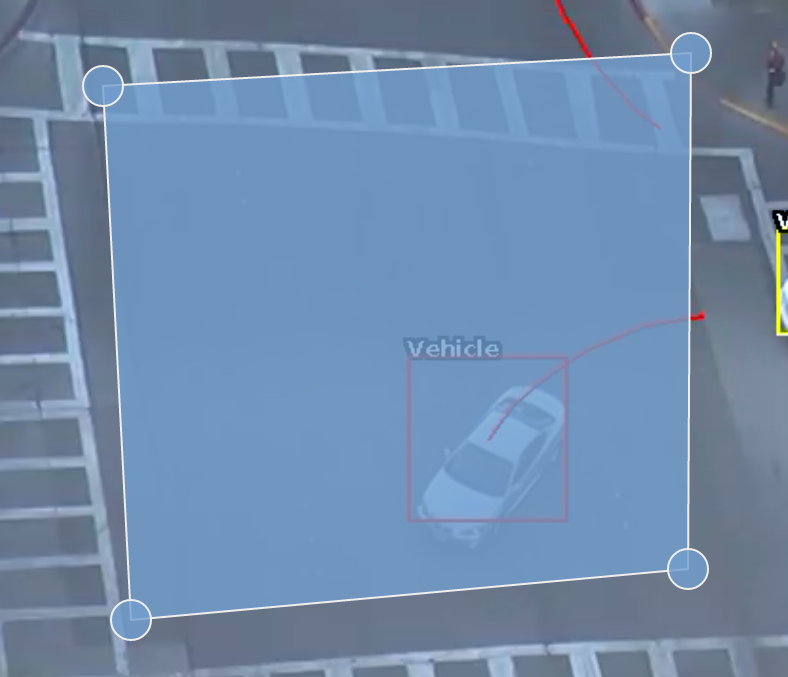

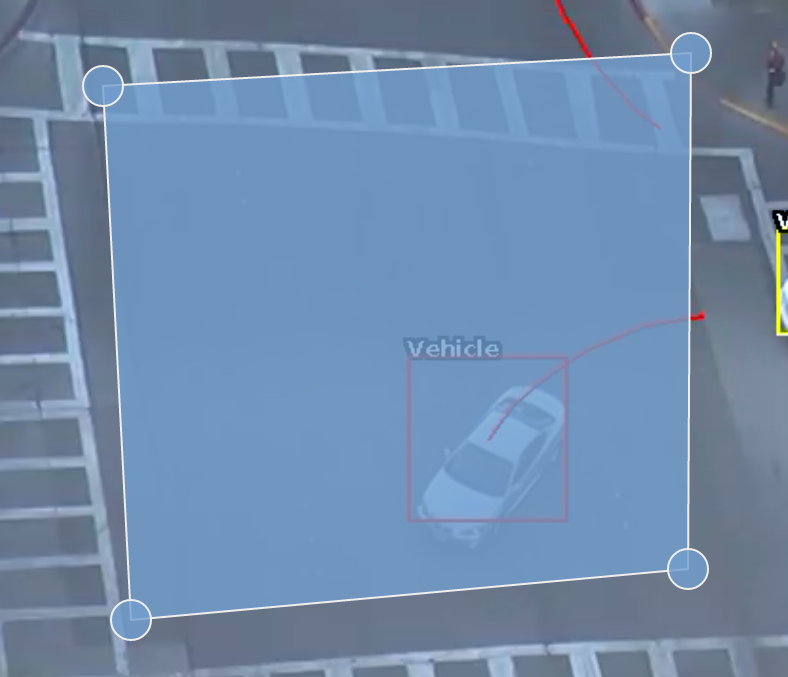

Strefy to obszary wykrywania, na których działają reguły VCAcore. Aby wykryć określone zachowanie, należy skonfigurować strefę, aby określić obszar, w którym reguła ma zastosowanie.

Strefy można dodawać na wiele sposobów:

Kliknij dwukrotnie w dowolnym miejscu na ekranie wideo.

Kliknij przycisk Utwórz strefę w menu ustawień strefy.

Kliknij prawym przyciskiem myszy lub przytrzymaj, aby wyświetlić menu kontekstowe i wybierz ikonę ![]() dodawania strefy

dodawania strefy

Kliknięcie prawym przyciskiem myszy lub przytrzymanie przycisku (na urządzeniach mobilnych) powoduje wyświetlenie menu kontekstowego zawierającego polecenia specyficzne dla bieżącego kontekstu.

Możliwe działania z menu kontekstowego to:

Aby zmienić położenie strefy, kliknij i przeciągnij strefę do nowej pozycji. Aby zmienić kształt strefy,

przeciągnij węzły, aby utworzyć wymagany kształt. Nowe węzły można dodawać, klikając dwukrotnie krawędź

strefy lub klikając ikonę ![]() dodawania węzła z menu kontekstowego.

dodawania węzła z menu kontekstowego.

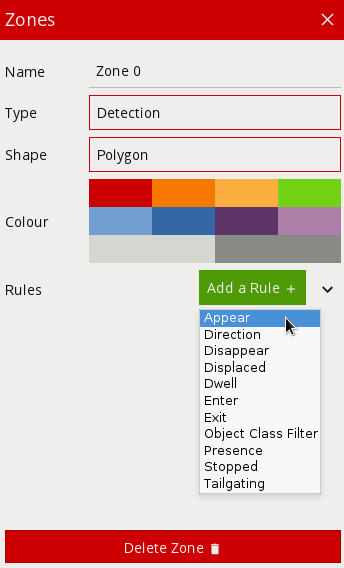

Menu konfiguracji strefy zawiera szereg parametrów konfiguracji specyficznych dla strefy:

Name: Nazwa strefy, która pojawia się w powiadomieniach zdarzeń.

Type: Typ strefy. Może być jednym z:

Detection: Strefa wykrywająca śledzone obiekty, w której można stosować reguły.

Non-detection: Strefa określająca obszar, który powinien zostać wykluczony z analizy VCAcore. Obiekty nie są wykrywane w tych strefach. Przydatne do wykluczania obszarów potencjalnie uciążliwychze sceny, które powodują fałszywe alarmy (np. Znaczne poruszanie się drzew, migające światła itp.).

Shape: Kształt strefy. Może być jednym z:

Polygon: Wieloboczny obszar wykrywania z co najmniej trzema węzłami. Reguły działają na całym obszarze.

Line: Linia jedno lub wielosegmentowa z co najmniej dwoma węzłami. Reguły działają na całej długości linii.

Colour: Kolor strefy.

Rules: Reguły wykrywania dla strefy. Więcej informacji można znaleźć w konfiguracji reguł.

Strefy można usuwać w następujący sposób:

Po skonfigurowaniu strefy można dodać reguły do wykrywania określonych scenariuszy. Aby uzyskać więcej informacji, patrz Konfiguracja Reguł.

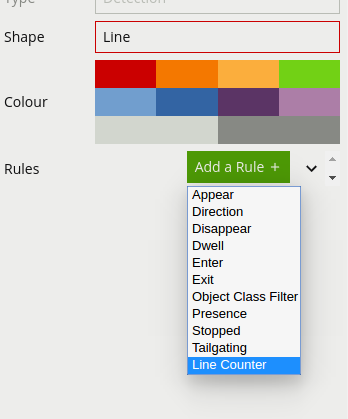

Reguły są dodawane do stref w celu wykrywania określonych zdarzeń. Przykładami reguł, które można zastosować, są wykrywanie obecności obiektu w strefie lub wykrywanie obiektu poruszającego się w określonym kierunku w strefie.

Reguły są konfigurowane w tym samym miejscu, co strefy na stronie Strefy.

Wybierz strefę, do której reguła powinna zostać dodana, i kliknij przycisk Dodaj Regułę  .

Wybierz żądaną regułę z menu rozwijanego.

.

Wybierz żądaną regułę z menu rozwijanego.

Aby usunąć regułę, kliknij odpowiednią ikonę ![]() usuwania.

usuwania.

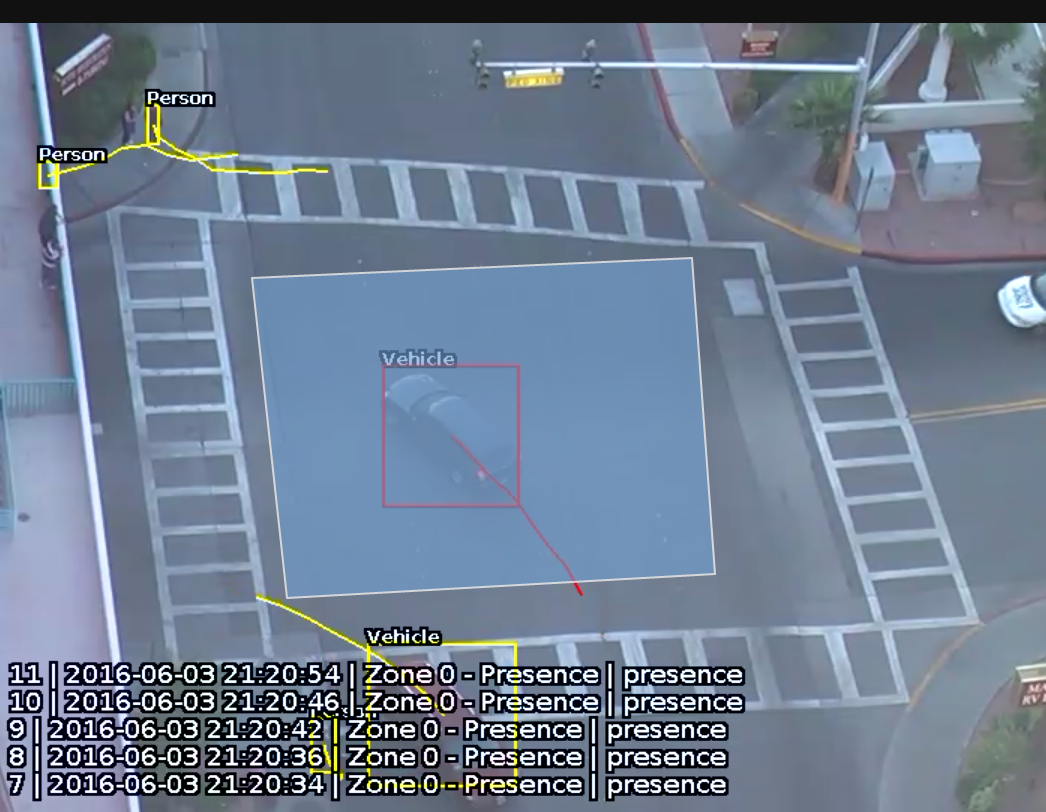

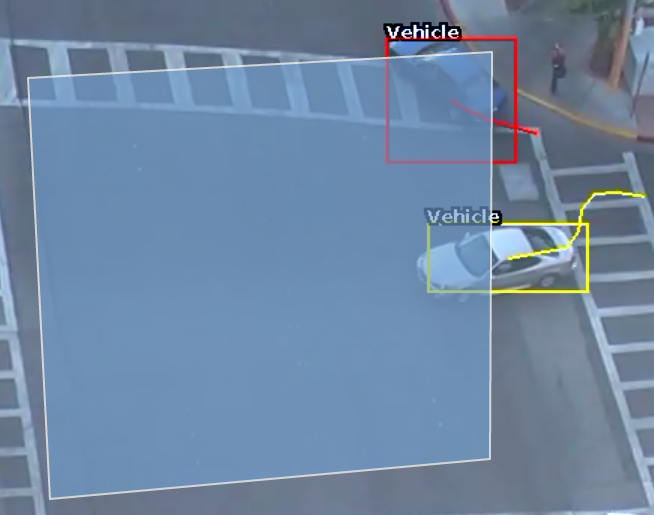

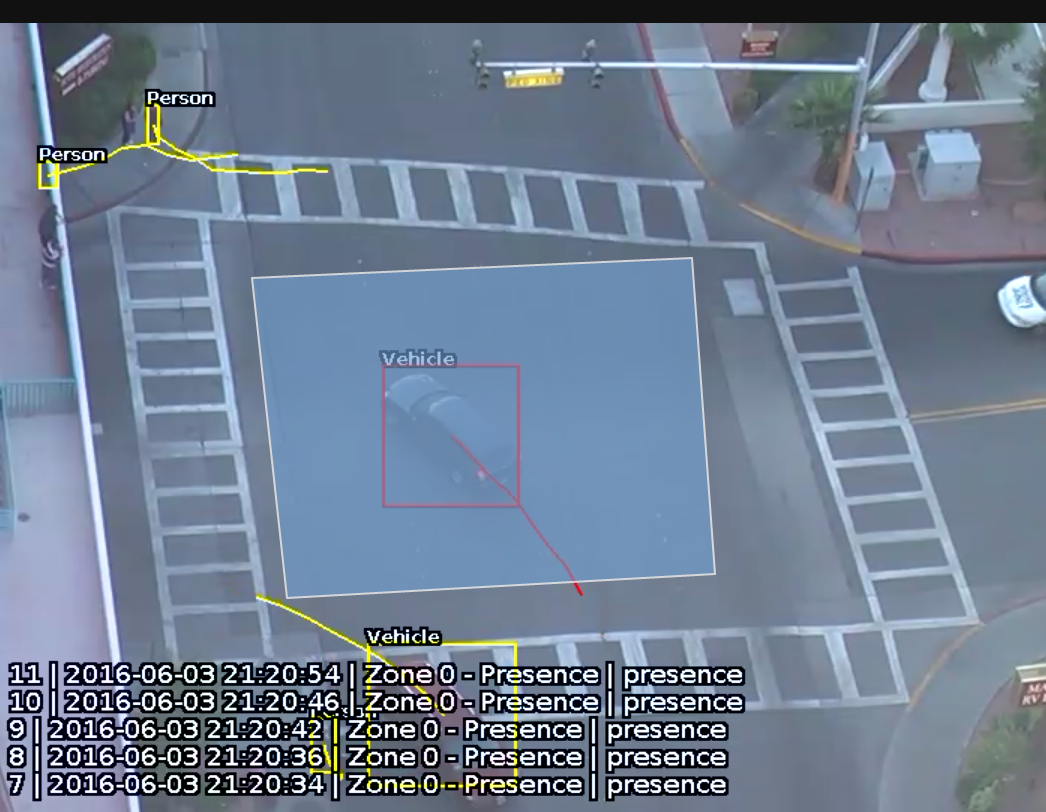

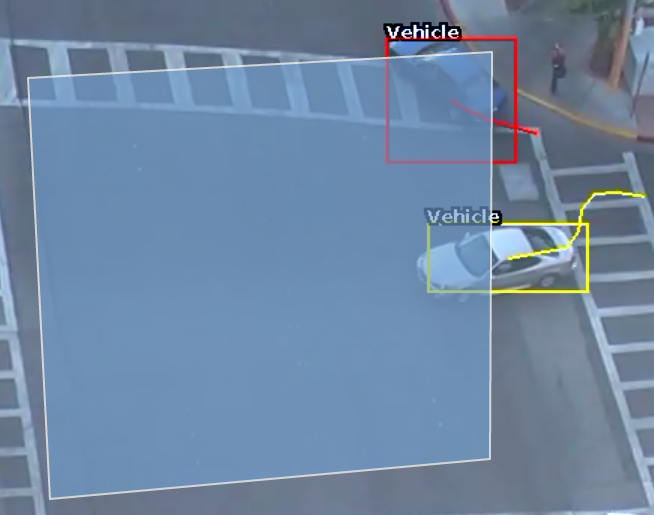

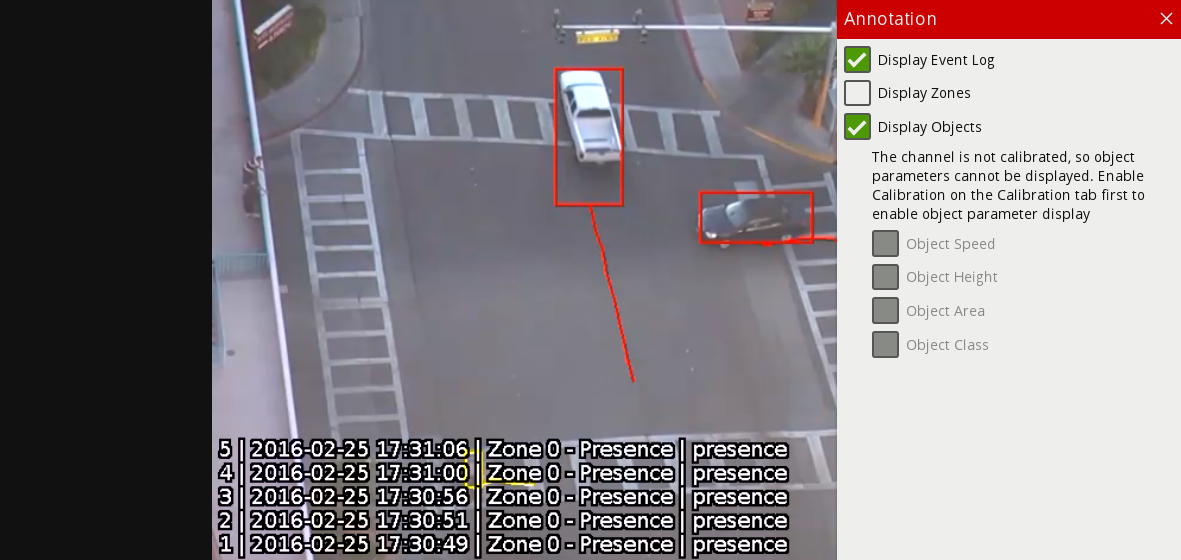

Wykryte obiekty opatrzone są ramką i śladem. Obiekty mogą być renderowane (wyświetlane) w dwóch stanach:

Non-alarmed: Domyślnie renderowany na żółto. Wykryty obiekt, który nie spełnia żadnych kryteriów wyzwalania reguły i wywoływania zdarzenia.

Alarmed: Domyślnie renderowany na czerwono. Wykryty obiekt, który wyzwolił jedną lub więcej reguł. Powoduje wyzwolenie zdarzenia.

Po wyzwoleniu zdarzenia domyślne ustawienia renderują szczegóły zdarzenia w dolnej połowie strumienia wideo.

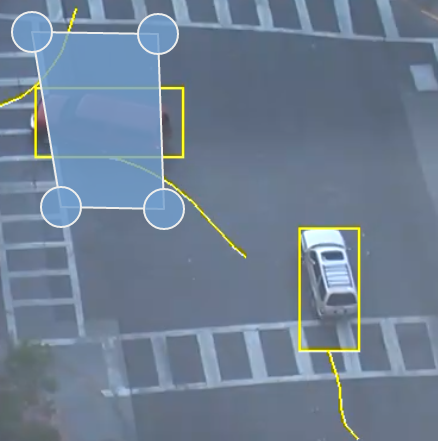

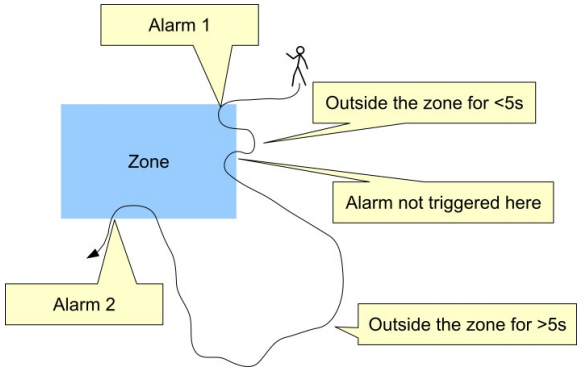

Ślad pokazuje historię, gdzie był obiekt. W zależności od kalibracji ślad może być rysowany od środka (mid-bottom) lub środkowego dolnego (mid-bottom) punktu obiektu. (Zobacz Zaawansowane Ustawienia, aby uzyskać więcej informacji).

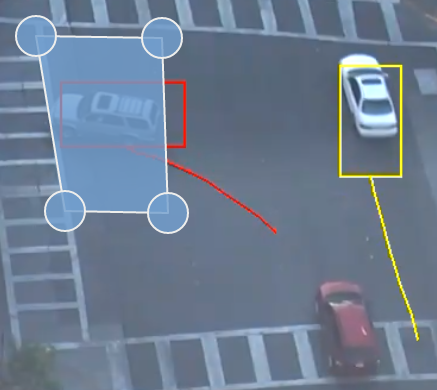

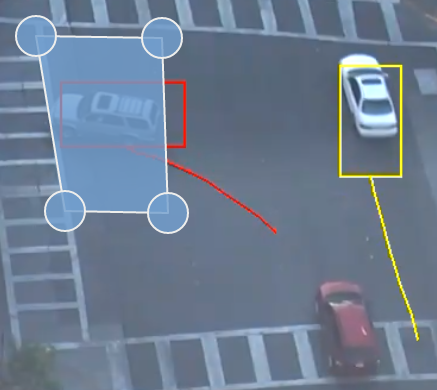

Ślad jest ważny dla określenia, w jaki sposób reguła jest uruchamiana. Przecięcie punktu trasy ze strefą lub linią określa, czy reguła jest aktywowana, czy nie. Poniższy rysunek ilustruje ten punkt: niebieski ślad pojazdu przecina strefę wykrywania i jest wyświetlany na czerwono. I odwrotnie, podczas gdy biały pojazd przecina strefę wykrywania, jego ślad nie przecina się (jeszcze) i dlatego nie wywołał reguły i jest wyświetlany na żółto.

Zachowanie każdego z typów reguł zostało wyjaśnione poniżej.

Obiekty znajdujące się w strefie lub przechodzące przez linię wyzwalają regułę i wyzwalają zdarzenie.

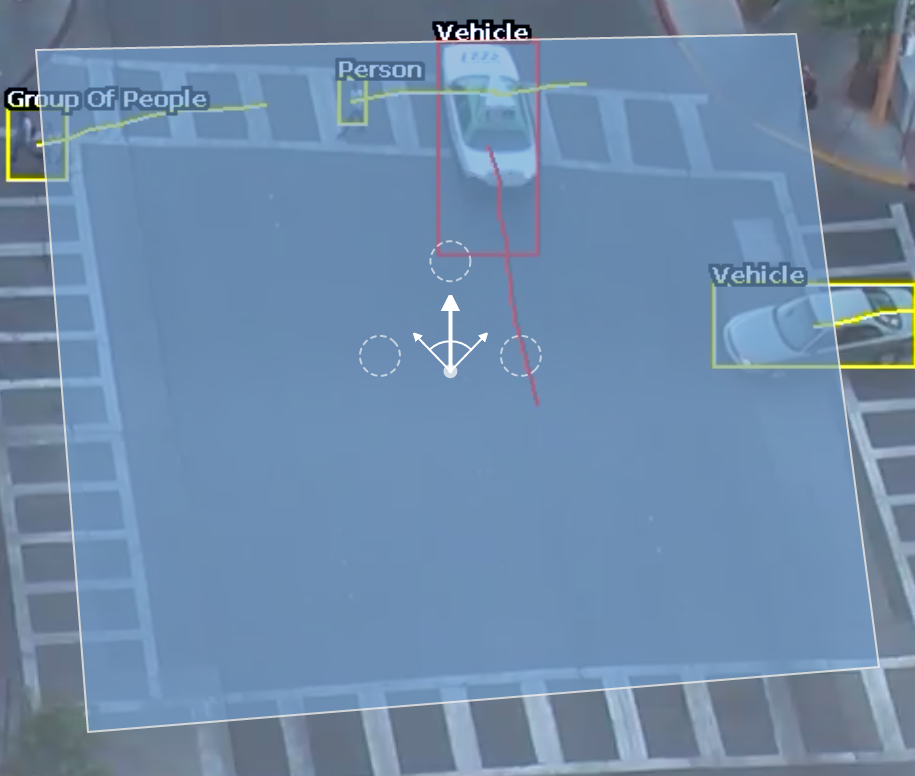

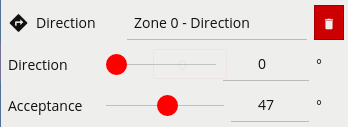

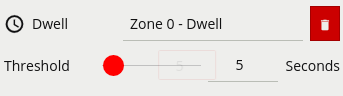

Reguła kierunku wykrywa obiekty poruszające się w określonym kierunku. Skonfiguruj kierunek i kąt akceptacji, przesuwając strzałki na widgecie sterowania kierunkiem. Główny kierunek jest wskazywany przez dużą środkową strzałkę. Kąt akceptacji jest kątem pomiędzy dwiema mniejszymi strzałkami.

Obiekty, które poruszają się w skonfigurowanym kierunku (w granicach kąta akceptacji), przez strefę lub linię uruchamia regułę i wyzwala zdarzenie.

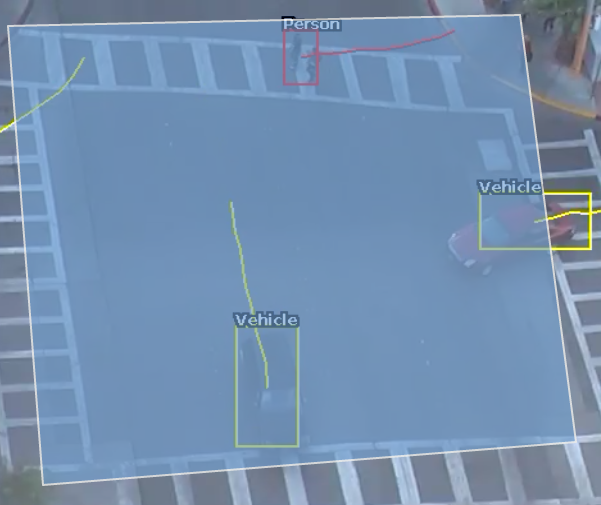

Poniższy rysunek ilustruje, w jaki sposób biały samochód poruszający się w skonfigurowanym kierunku uruchamia regułę, podczas gdy inne obiekty nie.

Parametry reguł można również skonfigurować w menu sterowania strefami:

Obiekty, które przebywają w strefie dłużej niż określony czas, uruchamiają regułę i wyzwalają zdarzenie.

Na poniższym zdjęciu osoba była w strefie dłużej niż 5 sekund, podczas gdy pojazd nie. Stąd osoba generuje zdarzenie, a pojazd nie.

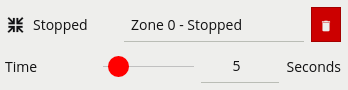

Reguła zatrzymana wykrywa obiekty, które są nieruchome w strefie dłużej niż określony czas. Uwaga: Reguła zatrzymana nie wykrywa pozostawionych obiektów. Wykrywa tylko obiekty, które poruszyły się w pewnym momencie, a następnie stały się nieruchome.

Reguła Wejścia wykrywa, kiedy obiekty wchodzą do strefy. Innymi słowy, gdy obiekty przecinają granicę strefy z zewnątrz do wnętrza.

I odwrotnie, reguła wyjścia wykrywa, kiedy obiekt opuszcza strefę: gdy przekroczy granicę strefy od wewnątrz na zewnątrz.

Uwaga: Reguły Wejścia i Wyjścia różnią się od reguł Pojawienia się i Zniknięcia, następująco:

Podczas gdy reguła Wejścia wykrywa już śledzone obiekty przekraczające granicę strefy z zewnątrz do wewnątrz, reguła pojawienia się wykrywa obiekty, które zaczynają być śledzone w strefie (np. Pojawiają się w scenie przez drzwi).

Podczas gdy reguła Wyjścia wykrywa już śledzone obiekty przekraczające granicę strefy od wewnątrz do zewnątrz, reguła zniknięcia wykrywa obiekty, które przestają być śledzone w strefie (np. Opuszczają scenę przez drzwi).

Wyświetlana reguła wykrywa obiekty, które zaczynają być śledzone w strefie, np. osoba, która pojawia się na scenie z drzwi.

I odwrotnie, reguła znikania wykrywa obiekty, które przestają być śledzone w strefie, np. osoba, która wychodzi ze sceny przez drzwi.

Uwaga: reguły Pojawienia się i Zniknięcia różnią się od reguł Wejścia i Wyjścia opisanych w regułach Wejścia i Wyjścia.

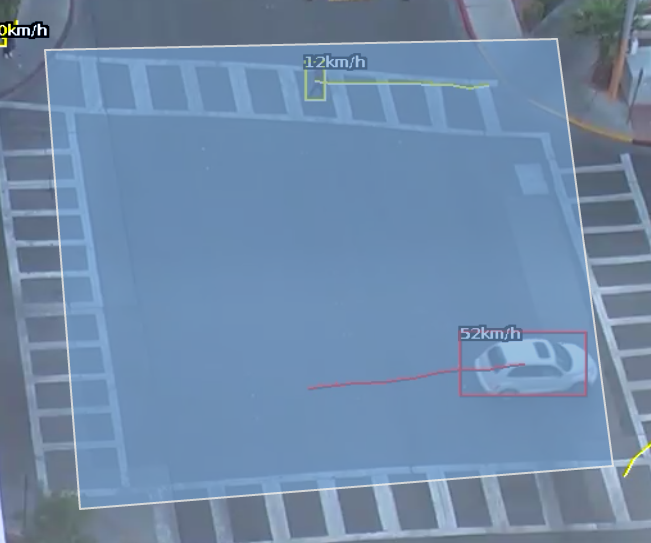

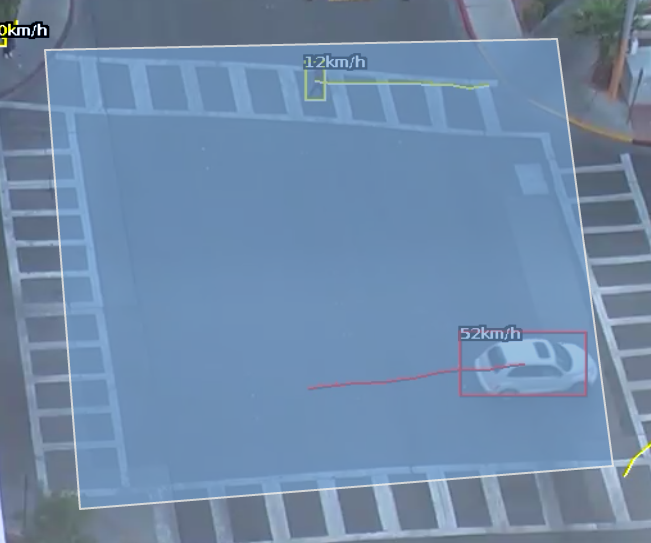

Reguła prędkości wykrywa obiekty poruszające się w zakresie prędkości określonych przez dolną i górną granicę.

Uwaga: Kanał musi być skalibrowany, aby filtr prędkości był dostępny.

Poniższy rysunek ilustruje, w jaki sposób reguła prędkości jest uruchamiana przez samochód jadący z prędkością 52 km/h, ale osoba poruszająca się z prędkością 12 km/h jest poza skonfigurowanym zakresem (50-200 km/h), a zatem nie wyzwala reguły.

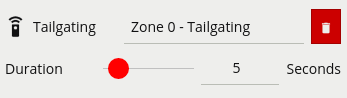

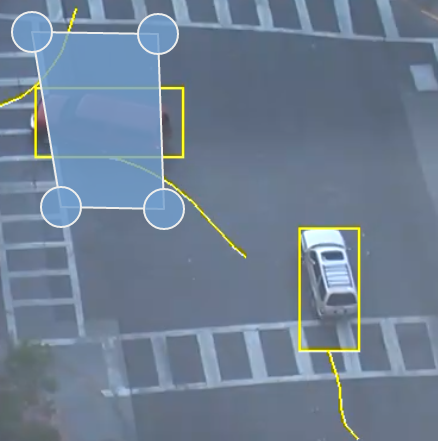

Reguła Tailgating wykrywa obiekty, które przechodzą przez strefę lub linię w krótkim odstępie od siebie. Limit czasu dla obiektu do przejścia bez wyzwolenia reguły tailgating jest konfigurowany w Strefach:

W tym przykładzie obiekt 1 ma zamiar przekroczyć linię wykrywania. Inny obiekt (obiekt 2) podąża za nim. Próg wykrywania jest ustawiony na 5 sekund. Oznacza to, że każdy obiekt przekraczający linię w ciągu 5 sekund od obiektu, który już przekroczył linię, wyzwoli regułę ustawiania obiektu.

Obiekt 2 przecina linię w ciągu 5 sekund od obiektu 1. Spowoduje to uruchomienie filtra ogonu (Tailgating) i wyzwolenia zdarzenia.

Filtr klasyfikacji obiektów pozwala regułom działać tylko na wybranych klasach obiektów (np. Osoby, Pojazdy)

Mode: określa, czy uwzględnić lub wykluczyć klasę obiektu z reguły.

Include zezwala tylko wybranym klasom obiektów na wyzwalanie skonfigurowanych reguł.

Exclude pozwala wszystkim klasom obiektów z wyjątkiem klas wybranych do wyzwolenia skonfigurowanych reguł.

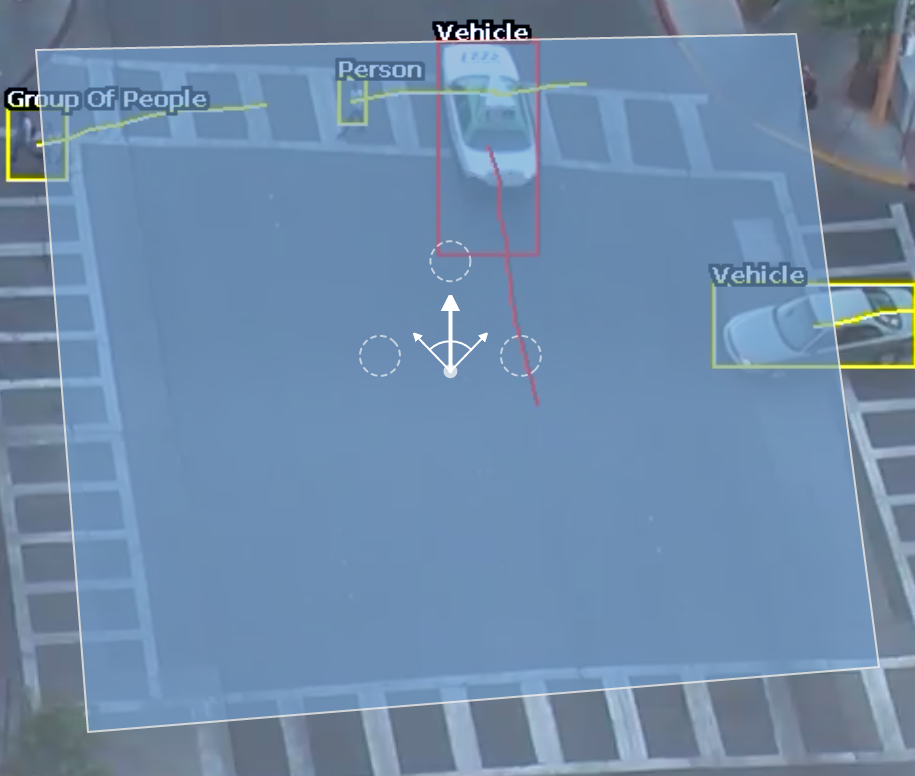

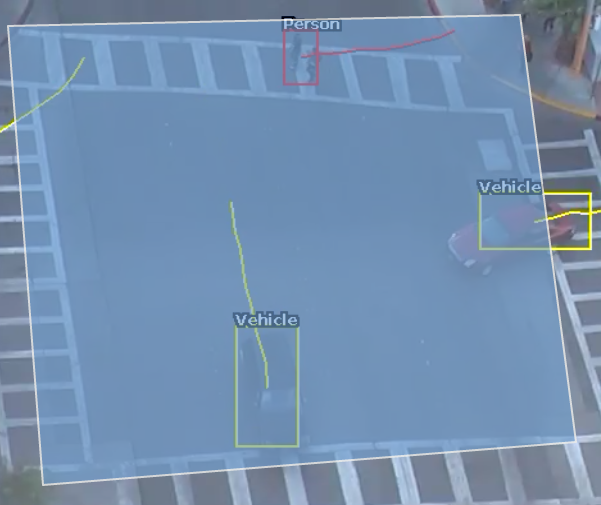

Poprzedni obraz ilustruje, w jaki sposób reguła Uwzględnij (Include) z wybraną klasą Osoba zalicza tylko obiekty Osoby w regule obecności. Pojazd w strefie jest filtrowany, ponieważ klasa Pojazd nie jest uwzględniona w wyborze filtra klasyfikacji.

Uwaga: kanał musi być skalibrowany, aby filtr klasyfikacji obiektów był dostępny.

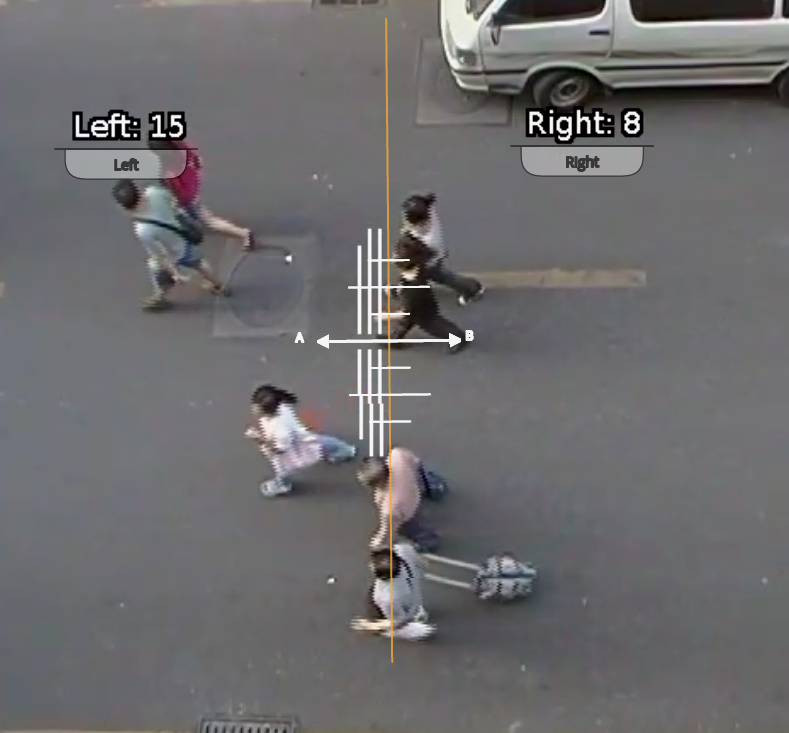

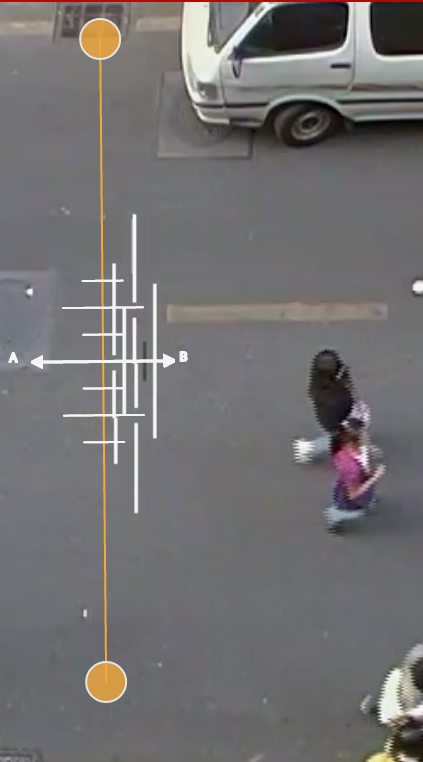

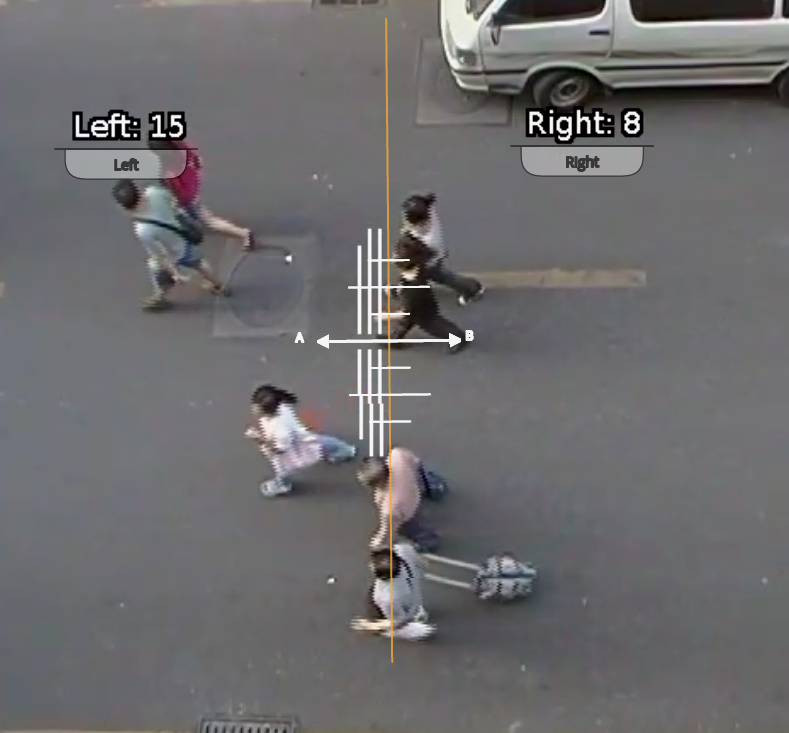

Linia zliczająca jest filtrem wykrywania zoptymalizowanym do dwukierunkowego zliczania obiektów (np. Ludzi lub Pojazdów) w bardziej zatłoczonych scenariuszach wykrywania. Przykłady takich aplikacji mogą obejmować:

Liczenie Ludzi za pomocą kamer zamontowanych z nad głowy w galeriach handlowych.

Liczenie Pojazdów za pomocą kamer zamontowanych z nad głowy na drogach publicznych.

W niektórych scenach, takich jak wejścia z zainstalowaną kamerą nad głową, linia zliczająca jest skuteczniejsza w liczeniu Ludzi czy Pojazdów niż przy użyciu liczników podłączonych do np. reguły obecności.

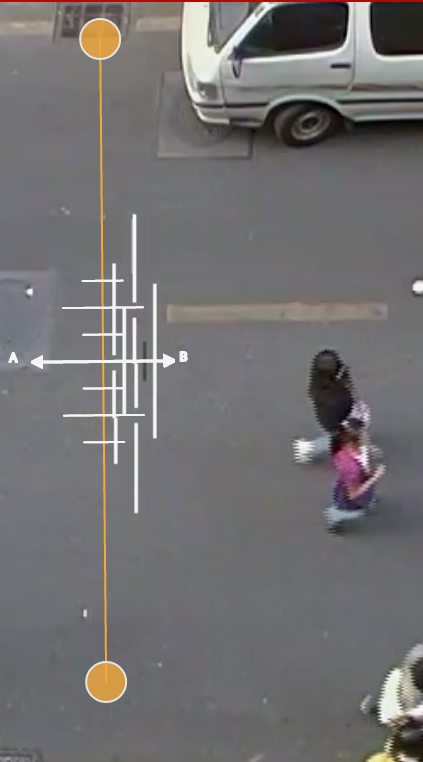

Zdarzenie jest generowane za każdym razem, gdy obiekt przekracza linię w wybranym kierunku. Jeśli wiele obiektów przekracza linię, generowanych jest wiele odpowiednich zdarzeń. Zdarzenia generowane przez linię zliczającą można powiązać z licznikami w prosty sposób sposób.

UWAGA: Maksymalna liczba filtrów linii zliczającej, które można zastosować dla każdego kanału wideo, wynosi 5.

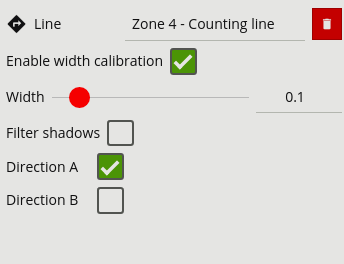

Linia zliczania jest włączana przez dodanie reguły Linii Zliczającej do linii wykrywania. Kliknij linię i dodaj regułę Linii Zliczającej:

Linia zliczająca ma wiele opcji konfiguracji, każda jest opisana poniżej:

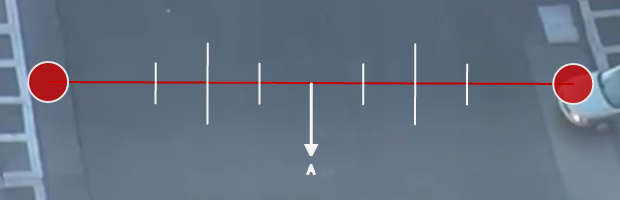

Direction A: Włącza liczenie w kierunku „A” (jeden kierunek linii).

Direction B: Włącza liczenie w kierunku „B” (przeciwny kierunek niż „A”).

Filter Shadows: Przełącza filtr cienia (patrz poniżej, aby uzyskać więcej informacji, w tym ograniczenia filtra cienia).

Enable Width Calibration: Włącza kalibrację szerokości, która umożliwia dokładniejsze zliczanie. Zobacz poniżej, aby uzyskać więcej informacji na temat kalibracji linii zliczającej.

Width Slider: Ustawia szerokość kalibracji. Można to również wykonać przez przeciąganie linii kalibracji wyświetlane prostopadle do linii zliczania. Więcej informacji na temat kalibracji linii zliczających można znaleźć poniżej.

Linia zliczająca sama generuje zdarzenia, gdy zostanie wykryty obiekt, który ma być zliczony. Aby policzyć zdarzenia, można utworzyć liczniki (po jednym dla każdego kierunku) i skonfigurować je do zliczania zdarzeń generowanych przez linię. Aby utworzyć liczniki, zobacz temat Liczniki.

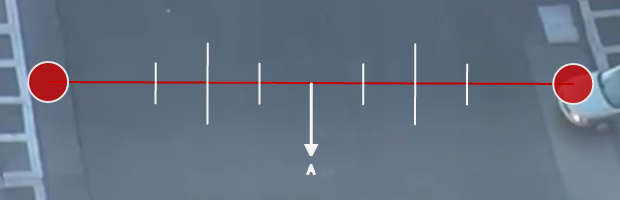

Aby generować dokładne zliczenia, linia zliczająca wymaga kalibracji. W przeciwieństwie do silnika śledzenia obiektów, nie można jej wykonać na poziomie ogólnym dla całej sceny za pomocą narzędzia Kalibracja 3D. Dzieje się tak, ponieważ linia licząca nie zawsze jest umieszczona na płaszczyźnie podłoża: może być umieszczona w dowolnej orientacji w dowolnym miejscu sceny. Na przykład linia zliczająca może być skonfigurowana pionowo z widokiem z boku kamery.

Zamiast narzędzia do kalibracji 3D, linia zliczania ma własne ustawienie kalibracji. Dwie linijki w równej odległości od środka linii reprezentują szerokość oczekiwanego obiektu. Dzięki temu linia zliczająca może odrzucić szum, a także zliczać wiele obiektów.

Aby skalibrować linię zliczającą:

Wybierz linię zliczania.

Zaznacz opcję kalibracji szerokości Width Calibration.

Użyj kółka myszy lub przeciągnij znaczniki kalibracji, aby dostosować odległość między znacznikami, aż odległość będzie w przybliżeniu równa rozmiarowi liczonych obiektów. Alternatywnie, przesuń suwak Szerokość kalibracji, aby uzyskać ten sam efekt.

Szerokość kalibracji jest wyświetlana na panelu ustawień pod regułą linii zliczającej. Ta liczba może być również edytowana bezpośrednio, aby zmienić szerokość kalibracji.

Małe znaczniki po obu stronach dużych znaczników wskazują minimalną i maksymalną szerokość, która jest liczona jako pojedynczy obiekt.

Aby umożliwić użytkownikowi dokładniejsze skonfigurowanie kalibracji linii zliczania, szerokości wykrytych obiektów są wyświetlane obok linii zliczającej, gdy obiekty przez nią przechodzą. Domyślnie ta opcja wyświetlania jest włączona. Jeśli jednak nie pojawi się, upewnij się, że opcja jest włączona w ustawieniach Nadrukowywania Adnotacji.

Informacja o kalibracji jest renderowana jako czarno-białe linie po obu stronach linii zliczającej na stronie konfiguracji Strefy. Każda linia reprezentuje obiekt wykryty przez algorytm zliczania. Szerokość linii pokazuje szerokość obiektu wykrytego przez linię. Kilka ostatnich detekcji jest wyświetlanych dla każdego kierunku, przy czym najnowszy pojawia się najbliżej linii zliczania.

Każde wykrycie jest liczone jako liczba obiektów na podstawie bieżącej kalibracji szerokości. Jest to wyświetlane w następujący sposób:

Czarna linia: zdarzenie nie policzone

Ciągła biała linia: zdarzenie liczone jako jeden obiekt

Przerywana biała linia: zdarzenie liczone jako wiele obiektów wskazane przez liczbę segmentów linii.

Wykorzystując informacje zwrotne z adnotacji diagnostycznych, można precyzyjnie dostosować kalibrację szerokości, aby policzyć obiekty o prawidłowym rozmiarze i odfiltrować fałszywe zliczenia.

Linia zliczająca zawiera filtr cienia, który ma na celu usunięcie efektów cieni obiektów wpływających na algorytm zliczania. Cienie mogą powodować niedokładne wyniki zliczania, sprawiając, że obiekt wydaje się większy niż jego prawdziwy rozmiar lub łącząc dwa lub więcej obiektów razem. Jeśli cienie powodują niedokładne zliczanie, należy włączyć filtr cienia, zaznaczając pole wyboru Filtruj Cienie (Filter Shadows) dla linii. Zaleca się, aby filtr cienia był włączony tylko wtedy, gdy występują cienie, ponieważ algorytm może pomylić pewne części obiektu z cieniami, co może prowadzić do gorszych wyników zliczania. Dotyczy to zwłaszcza obiektów, które mają niewielki kontrast w porównaniu z tłem (np. Ludzie noszą czarne płaszcze na czarnym dywanie).

Dowiedz się, jak skonfigurować Liczniki na kanale.

Reguły logiczne VCAcore służą do wykrywania określonych zdarzeń w strumieniu wideo. Mechanizm reguł logicznych VCAcore używa dwóch pojęciowych koncepcji do wykrywania zdarzeń:

Podstawowe Dane Wejściowe / Reguły: Algorytm lub filtr, który będzie wyzwalany po zaobserwowaniu określonego zachowania lub zdarzenia, np. Obecność. Jest to większość dostępnych wcześniej zdarzeń w ustawieniach stref, nazywane dalej jako podstawowe dane wejściowe. Mogą wywoływać akcje.

Warunkowe Dane Wejściowe / Reguły Logiczne: logiczne połączenie między jednym lub większą liczbą zdarzeń, aby umożliwić wykrycie bardziej dogłębnych zachowań, np. Logiczne AND "I". Warunkowe Dane Wejściowe można również wykorzystać do wywołania akcji.

Korzystając z tych pojęć, łatwo jest zbudować konfiguracje, które są używane do wyzwalania akcji. Mogą to być proste reguły dołączone do stref lub bardziej złożone konfiguracje, w których reguły można łączyć lub rozszerzać za pomocą reguł logicznych. Nadrzędnym celem reguł logicznych jest pomoc w eliminowaniu generowania błędnych zdarzeń przez udostępnienie funkcji odfiltrowania niepożądanych zachowań od wywołania akcji.

Więcej szczegółów na temat różnic między tymi dwoma pojęciami przedstawiono poniżej:

Podstawowe dane wejściowe lub reguły mogą być używane tylko do wyzwalania akcji lub jako dane wejściowe do innej reguły. Wejście do reguły można traktować jako warunek wejściowy wymagany do wyzwolenia operatorów logicznych.

Pełna lista podstawowych danych wejściowych to:

Warunkowe dane wejściowe to takie, które nie mogą samodzielnie wywołać akcji. Wymagają, aby dodać wejście innej reguły lub reguły logicznej by działały. Przykładem tego jest reguła AND. Reguła AND wymaga dwóch danych wejściowych do porównania w celu działania.

Pełna lista Reguł Warunkowych to:

Po skonfigurowaniu reguł są one stosowane w kanale w czasie rzeczywistym, co pozwala uzyskać informacje o ich działaniu. Obiekty, które wywołały regułę, opatrzone są obwiednią i śladem. Obiekty mogą być renderowane w dwóch stanach:

Jak widać poniżej, po wyzwoleniu zdarzenia domyślne ustawienia renderują szczegóły zdarzenia w dolnej połowie strumienia wideo. Adnotacje klas obiektów w tym przykładzie są generowane gdy kanał jest skalibrowany.

Ślad pokazuje historię, gdzie był obiekt. W zależności od kalibracji ślad może być rysowany od środka (mid-bottom) lub środkowego dolnego (mid-bottom) punktu obiektu. (Zobacz Zaawansowane Ustawienia, aby uzyskać więcej informacji).

Ślad jest znaczący dla określenia, w jaki sposób reguła jest uruchamiana. Przecięcie punktu trasy ze strefą lub linią określa, czy reguła jest aktywowana, czy nie. Poniższy rysunek ilustruje ten punkt: niebieski ślad pojazdu przecina strefę wykrywania i jest wyświetlany na czerwono. I odwrotnie, podczas gdy biały pojazd przecina strefę wykrywania, jego ślad nie przecina się (jeszcze) i dlatego nie wywołał reguły i jest wyświetlany na żółto.

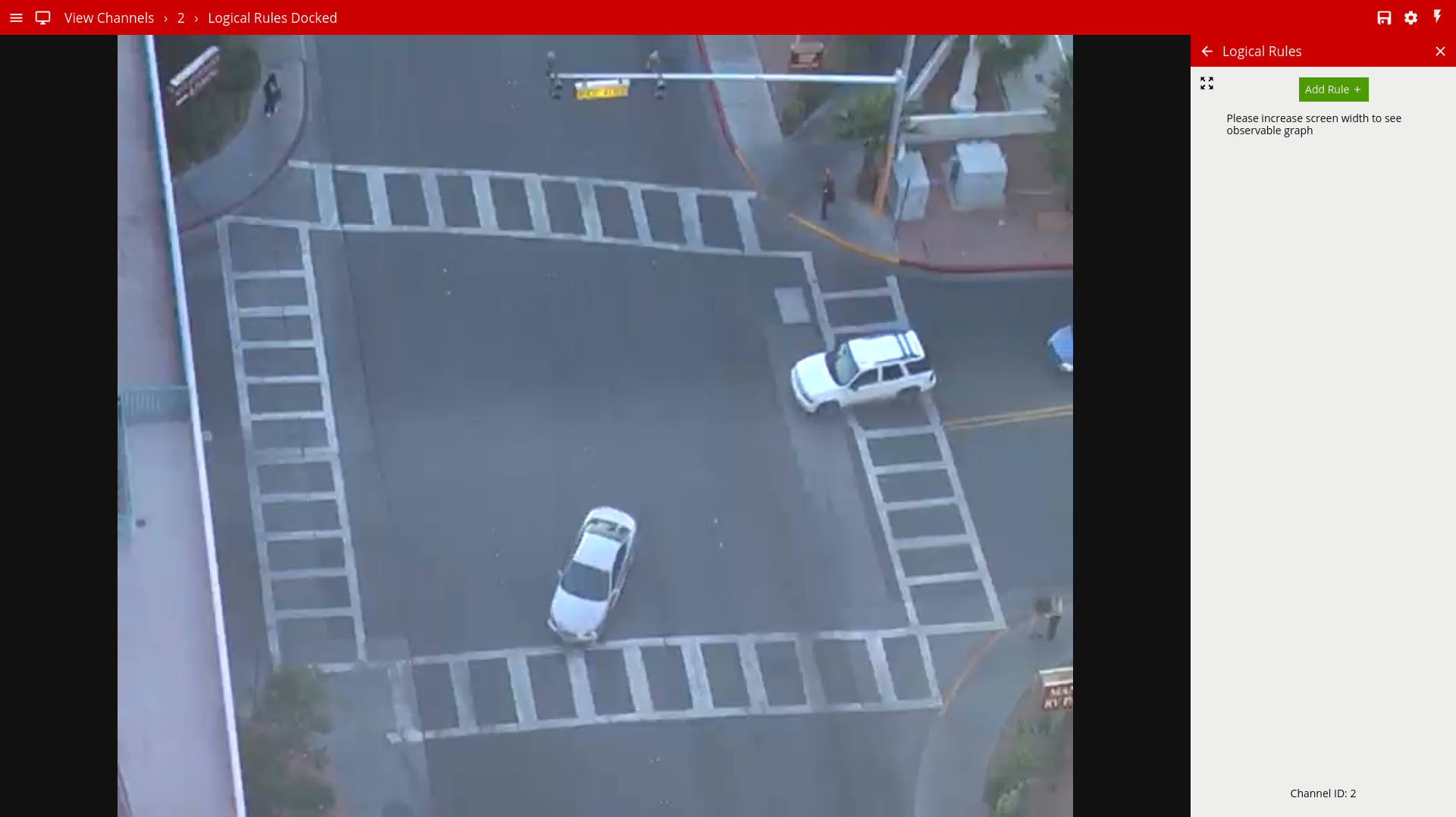

Reguły logiczne można skonfigurować na podstawie poszczególnych kanałów, otwierając wideo tego kanału i klikając podmenu kanału po lewej lub prawej stronie menu ustawień kanału. Konfiguracja jest możliwa w dwóch formach, w trybie zadokowanym, w którym zarówno reguły, jak i strumień wideo są widoczne lub rozszerzonym, w których dostarczana jest reprezentacja w postaci drzewa w celu wizualizacji sposobu łączenia reguł.

Początkowo strona reguł logicznych otwiera się w trybie „zadokowany” obok strumienia wideo na żywo.

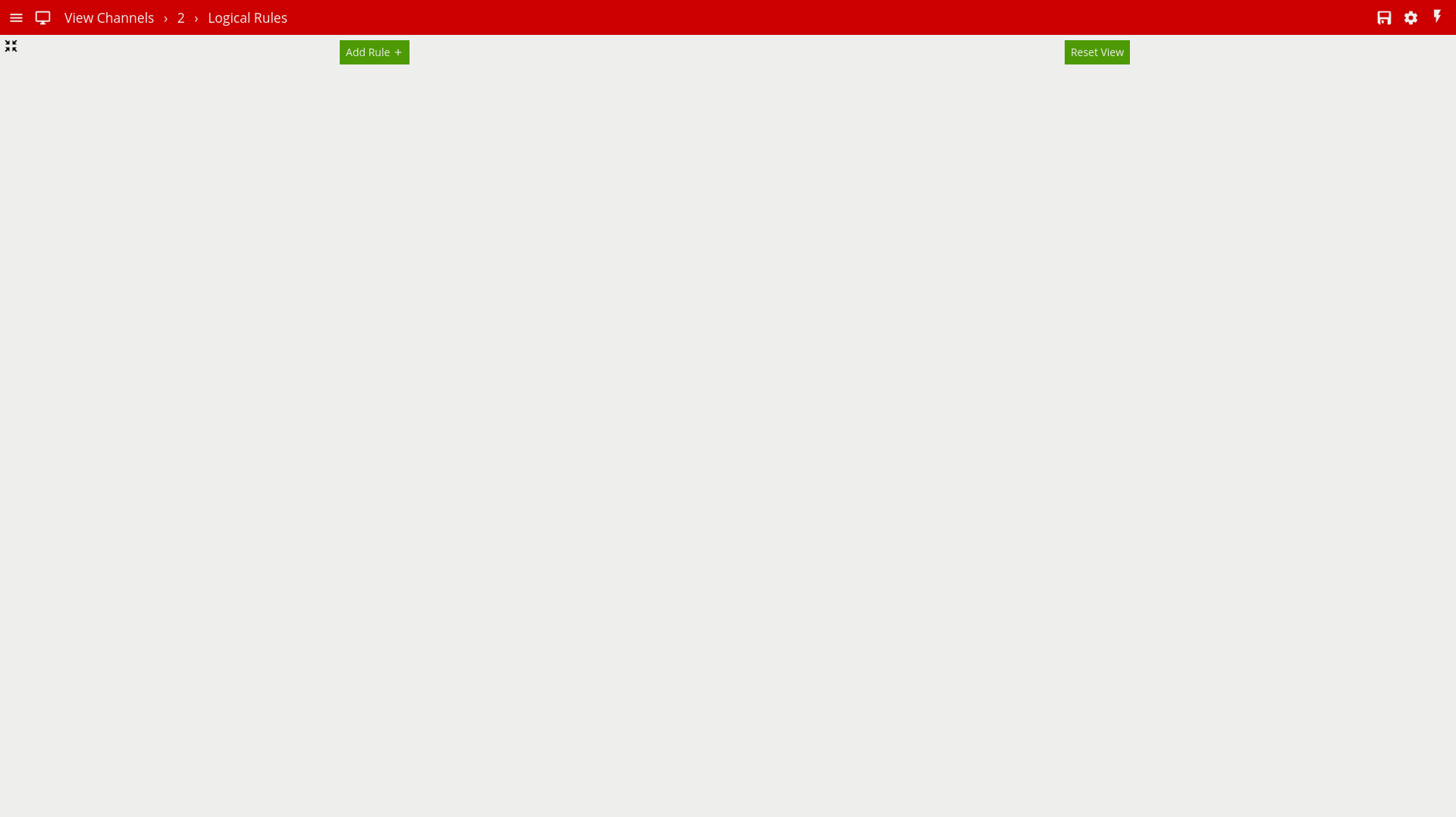

Użytkownik może kliknąć przycisk rozwijania (obok przycisku „Dodaj Regułę”), aby przejść do widoku rozszerzonego. Należy pamiętać, że wykres reguł logicznych jest widoczny tylko w widoku rozszerzonym.

W rozszerzonym widoku użytkownik może dodawać reguły i używać Edytora Reguł do łączenia reguł ze sobą. Wykres po prawej stronie jest aktualizowany w czasie rzeczywistym, aby odzwierciedlić zmiany użytkownika.

Pierwszymi krokami do zdefiniowania reguły logicznej jest dodanie początkowych podstawowych danych wejściowych, skonfigurowanie parametrów reguły i powiązanie ich ze strefą. Kliknij przycisk "Add a Rule" i wybierz żądaną regułę z menu rozwijanego.

Aby usunąć regułę, kliknij odpowiednią ikonę usuwania ![]() .

Pamiętaj, że reguły dowolnego typu nie mogą być usunięte, jeśli służą jako dane wejściowe do innej reguły. W takim przypadku należy najpierw usunąć drugą regułę.

.

Pamiętaj, że reguły dowolnego typu nie mogą być usunięte, jeśli służą jako dane wejściowe do innej reguły. W takim przypadku należy najpierw usunąć drugą regułę.

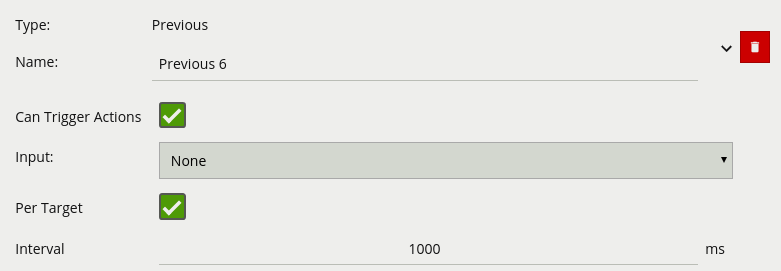

Poniżej znajduje się lista aktualnie obsługiwanych reguł wraz ze szczegółowym opisem każdej z nich.

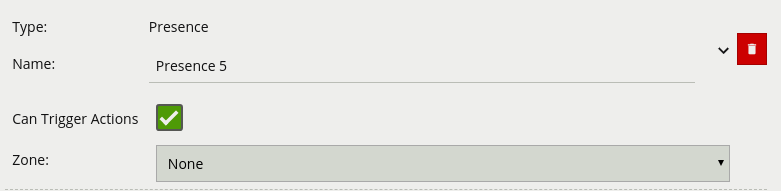

Reguła, która wywołuje zdarzenie, w którym obiekt został po raz pierwszy wykryty w określonej strefie.

Uwaga: Reguła Obecności zawiera wiele różnych zachowań, na przykład reguła Obecności zostanie uruchomiona w tych samych okolicznościach, co reguła Enter i Appear. Wyboru odpowiedniej reguły należy dokonać w zależności od scenariusza.

| Właściwość | Opis |

|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje |

| Zone | Strefa, z którą ta reguła jest powiązana |

Reguła kierunku wykrywa obiekty poruszające się w określonym kierunku. Skonfiguruj kierunek i kąt akceptacji, przesuwając strzałki na widgecie sterowania kierunkiem. Główny kierunek jest wskazywany przez dużą środkową strzałkę. Kąt akceptacji jest kątem pomiędzy dwiema mniejszymi strzałkami.

Obiekty, które poruszają się w skonfigurowanym kierunku (w granicach kąta akceptacji), przez strefę lub linię uruchamia regułę i wyzwala zdarzenie.

Poniższy rysunek ilustruje, w jaki sposób biały samochód poruszający się w skonfigurowanym kierunku uruchamia regułę, podczas gdy inne obiekty nie.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Direction#" |

| Angle | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | 0 |

| Acceptance | Dozwolona wariancja z każdej strony głównego kierunku, która nadal wyzwoli regułę | 0 |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

Reguła zatrzymana wykrywa obiekty, które są nieruchome w strefie dłużej niż określony czas.

Uwaga: Reguła zatrzymana nie wykrywa pozostawionych obiektów. Wykrywa tylko obiekty, które poruszyły się w pewnym momencie, a następnie stały się nieruchome.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Stopped#" |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

| Time | Dozwolona wariancja z każdej strony głównego kierunku, która nadal wyzwoli regułę | 0 |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

Reguła Wejścia wykrywa, kiedy obiekty wchodzą do strefy. Innymi słowy, gdy obiekty przecinają granicę strefy z zewnątrz do wnętrza.

I odwrotnie, reguła wyjścia wykrywa, kiedy obiekt opuszcza strefę: gdy przekroczy granicę strefy od wewnątrz na zewnątrz.

Uwaga: Reguły Wejścia i Wyjścia różnią się od reguł Pojawienia się i Zniknięcia, następująco:

Podczas gdy reguła Wejścia wykrywa już śledzone obiekty przekraczające granicę strefy z zewnątrz do wewnątrz, reguła pojawienia się wykrywa obiekty, które zaczynają być śledzone w strefie (np. Pojawiają się w scenie przez drzwi).

Podczas gdy reguła Wyjścia wykrywa już śledzone obiekty przekraczające granicę strefy od wewnątrz do zewnątrz, reguła zniknięcia wykrywa obiekty, które przestają być śledzone w strefie (np. Opuszczają scenę przez drzwi).

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Enter#" |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Exit#" |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

Wyświetlana reguła wykrywa obiekty, które zaczynają być śledzone w strefie, np. osoba, która pojawia się na scenie z drzwi.

I odwrotnie, reguła znikania wykrywa obiekty, które przestają być śledzone w strefie, np. osoba, która wychodzi ze sceny przez drzwi.

Uwaga: reguły Pojawienia się i Zniknięcia różnią się od reguł Wejścia i Wyjścia opisanych w regułach Wejścia i Wyjścia.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Appear#" |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Disappear#" |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

Reguła porzuconego i usuniętego obiektu jest uruchamiana, gdy obiekt zostanie pozostawiony w zdefiniowanej strefie, np. osoba pozostawiająca torbę na peronie kolejowym lub gdy przedmiot jest usuwany z określonej strefy. Porzucona reguła ma właściwość trwania, która określa czas, przez który obiekt musiał zostać porzucony lub usunięty, aby uruchomić regułę.

Poniżej znajduje się przykładowy scenariusz, w którym torba jest pozostawiona w określonej strefie, co powoduje uruchomienie reguły..

Poniżej znajduje się podobny przykładowy scenariusz, w którym torba jest usuwana ze zdefiniowanej strefy, co powoduje uruchomienie reguły..

Uwaga: Algorytm wykorzystywany do wykrywania porzuconych i usuniętych obiektów jest w każdym przypadku taki sam i dlatego nie może odróżniać obiektów, które zostały porzucone lub usunięte. Wynika to z faktu, że algorytm analizuje tylko zmiany bloków pikseli w stosunku do modelu tła.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Abandoned#" |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

| Duration | Okres, przez który obiekt musi zostać porzucony lub usunięty, zanim reguła zostanie uruchomiona | 0 |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

Reguła prędkości wykrywa obiekty poruszające się w zakresie prędkości określonych przez dolną i górną granicę.

Uwaga: Kanał musi być skalibrowany, aby filtr prędkości był dostępny.

Poniższy rysunek ilustruje, w jaki sposób reguła prędkości jest uruchamiana przez samochód jadący z prędkością 52 km/h, ale osoba poruszająca się z prędkością 12 km/h jest poza skonfigurowanym zakresem (50-200 km/h), a zatem nie wyzwala reguły.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Presence#" |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Min Speed | Minimalna prędkośc obiektu w km/h która wywołuje akcję | 0 |

| Max Speed | Maksymalna prędkośc obiektu w km/h która wywołuje akcję | 0 |

Poniższy przykład logicznej reguły sprawdza, czy obiekt wyzwalający regułę Presence 4 w strefie Center, również przemieszcza się z prędkością pomiędzy 50 a 200 km/h zgodnie z regułą prędkości Speed 3.

Tylko reguła AND Centre Zone Speed jest ustawiona na Can Trigger Actions, co oznacza, że tylko ten składnik reguły logicznej będzie dostępny jako źródło akcji.

Reguła Tailgating wykrywa obiekty, które przechodzą przez strefę lub linię w krótkim odstępie od siebie.

W tym przykładzie obiekt 1 ma zamiar przekroczyć linię wykrywania. Inny obiekt (obiekt 2) podąża za nim. Próg wykrywania jest ustawiony na 5 sekund. Oznacza to, że każdy obiekt przekraczający linię w ciągu 5 sekund od obiektu, który już przekroczył linię, wyzwoli regułę ustawiania obiektu.

Obiekt 2 przecina linię w ciągu 5 sekund od obiektu 1. Spowoduje to uruchomienie filtra ogonu (Tailgating) i wyzwolenia zdarzenia.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Tailgating #" |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

| Duration | Maksymalny czas pomiędzy objektami wchodzącym w strefę i wywołującymi alarm | 0 |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

Uwaga: Definiowanie filtrów (od fw.1.1.1) znajduje się w Regułąch logicznych. Poniższy opis przedstawia tylko zasadę działania klasyfikacji.

Filtr klasyfikacji obiektów pozwala regułom działać tylko na wybranych klasach obiektów (np. Osoby, Pojazdy)

Mode: określa, czy uwzględnić lub wykluczyć klasę obiektu z reguły.

Include zezwala tylko wybranym klasom obiektów na wyzwalanie skonfigurowanych reguł.

Exclude pozwala wszystkim klasom obiektów z wyjątkiem klas wybranych do wyzwolenia skonfigurowanych reguł.

Obraz ilustruje, w jaki sposób reguła Uwzględnij (Include) z wybraną klasą Osoba zalicza tylko obiekty Osoby w regule obecności. Pojazd w strefie jest filtrowany, ponieważ klasa Pojazd nie jest uwzględniona w wyborze filtra klasyfikacji.

Uwaga: kanał musi być skalibrowany, aby filtr klasyfikacji obiektów był dostępny.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "ObjectFilter #" |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Input | Strefa, z którą ta reguła jest powiązana | None |

| Classes | Klasa obiektu która wywołuje alarm | None |

W poniższym przykładzie logiczna reguła filtruje obiekty z reguły Presence. Klasy obiektów Person i Group of People wywołują alarm natomiast klasy typu Vehicle i Clutter w tym przypadku nie wywyłują alarmu. Odznaczenie Can Trigger Actions w regule robi z niej regułę wejściową Input dla filtra ObjectFilter23 który wywołuje akcję.

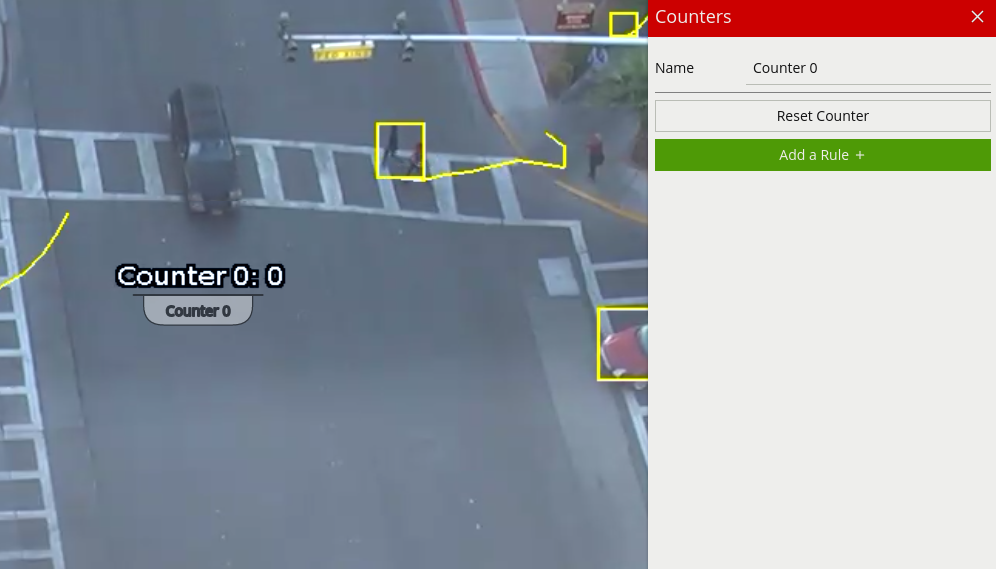

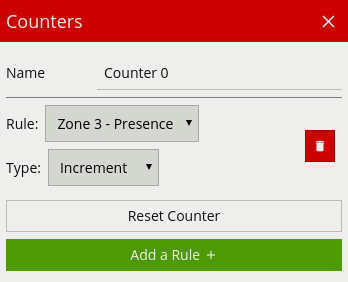

Liczniki mogą być skonfigurowane do liczenia, ile razy reguła jest uruchamiana, na przykład liczba osób przekraczających linię. Reguła licznika jest przeznaczona do wykorzystania na trzy sposoby:

Więcej niż jedną regułę można przypisać do dowolnego z trzech wejść licznika. Pojedynczy licznik nie powinien być wykorzystywany jednocześnie do zliczania zajmowania-occupacy i zwiększania-increment/zmniejszania-decrement.

Liczniki można przemieszczać, chwytając „handle” pod nazwą licznika i przesuwając licznik w żądane miejsce.

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Counter #" |

| Increment | Po wyzwoleniu reguły wartość licznika będzie zwiększana. Licznik jest zwiększany o dołączone reguły (+1 dla każdego wyzwalacza reguły) | None |

| Decrement | Po wyzwoleniu reguły wartość licznika zostanie zmniejszona. Licznik jest zmniejszany o dołączone reguły (-1 dla każdego wyzwalacza reguły) | None |

| Occupancy | Licznik pokaże aktualną liczbę aktywnych wyzwalaczy w strefie | None |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

| Reset Counter | Przycisk którym możemy zresetować licznik do zera | None |

Poniższy przykład licznika zwiększa licznik oparty na dwóch regułach Enter Center i Enter Top, co oznacza, że gdy którakolwiek z tych reguł wyzwala licznik zostanie zwiększony o + 1. Licznik również zmniejsza wartość o 1 na podstawie akcji Decrement bazując na regule Exit za każdym razem, gdy obiekt opuści strefę Centre.

Tylko licznik dla reguły Counter jest ustawiony na Can Trigger Actions, co oznacza, że tylko ten składnik reguły logicznej będzie dostępny jako źródło akcji. W takim przypadku akcja wykorzystująca tę regułę jako źródło będzie uruchamiała zmianę licznika.

Linia zliczająca jest filtrem wykrywania zoptymalizowanym do dwukierunkowego zliczania obiektów (np. Ludzi lub Pojazdów) w bardziej zatłoczonych scenariuszach wykrywania. Przykłady takich aplikacji mogą obejmować:

Liczenie Ludzi za pomocą kamer zamontowanych z nad głowy w galeriach handlowych.

Liczenie Pojazdów za pomocą kamer zamontowanych z nad głowy na drogach publicznych.

W niektórych scenach, takich jak wejścia z zainstalowaną kamerą nad głową, linia zliczająca jest skuteczniejsza w liczeniu Ludzi czy Pojazdów niż przy użyciu liczników podłączonych do np. reguły obecności.

Zdarzenie jest generowane za każdym razem, gdy obiekt przekracza linię w wybranym kierunku. Jeśli wiele obiektów przekracza linię, generowanych jest wiele odpowiednich zdarzeń. Zdarzenia generowane przez linię zliczającą można powiązać z licznikami w prosty sposób sposób.

UWAGA: Maksymalna liczba filtrów linii zliczającej, które można zastosować dla każdego kanału wideo, wynosi 5.

Aby generować dokładne zliczenia, linia zliczająca wymaga kalibracji. W przeciwieństwie do silnika śledzenia obiektów, nie można jej wykonać na poziomie ogólnym dla całej sceny za pomocą narzędzia Kalibracja 3D. Dzieje się tak, ponieważ linia licząca nie zawsze jest umieszczona na płaszczyźnie podłoża: może być umieszczona w dowolnej orientacji w dowolnym miejscu sceny. Na przykład linia zliczająca może być skonfigurowana pionowo z widokiem z boku kamery.

Zamiast narzędzia do kalibracji 3D, linia zliczania ma własne ustawienie kalibracji. Dwie linijki w równej odległości od środka linii reprezentują szerokość oczekiwanego obiektu. Dzięki temu linia zliczająca może odrzucić szum, a także zliczać wiele obiektów.

Aby skalibrować linię zliczającą:

Wybierz linię zliczania.

Zaznacz opcję kalibracji szerokości Width Calibration.

Użyj kółka myszy lub przeciągnij znaczniki kalibracji, aby dostosować odległość między znacznikami, aż odległość będzie w przybliżeniu równa rozmiarowi liczonych obiektów. Alternatywnie, przesuń suwak Szerokość kalibracji, aby uzyskać ten sam efekt.

Szerokość kalibracji jest wyświetlana na panelu ustawień pod regułą linii zliczającej. Ta liczba może być również edytowana bezpośrednio, aby zmienić szerokość kalibracji.

Małe znaczniki po obu stronach dużych znaczników wskazują minimalną i maksymalną szerokość, która jest liczona jako pojedynczy obiekt.

Aby umożliwić użytkownikowi dokładniejsze skonfigurowanie kalibracji linii zliczania, szerokości wykrytych obiektów są wyświetlane obok linii zliczającej, gdy obiekty przez nią przechodzą. Domyślnie ta opcja wyświetlania jest włączona. Jeśli jednak nie pojawi się, upewnij się, że opcja jest włączona w ustawieniach Nadrukowywania Adnotacji.

Informacja o kalibracji jest renderowana jako czarno-białe linie po obu stronach linii zliczającej na stronie konfiguracji Strefy. Każda linia reprezentuje obiekt wykryty przez algorytm zliczania. Szerokość linii pokazuje szerokość obiektu wykrytego przez linię. Kilka ostatnich detekcji jest wyświetlanych dla każdego kierunku, przy czym najnowszy pojawia się najbliżej linii zliczania.

Każde wykrycie jest liczone jako liczba obiektów na podstawie bieżącej kalibracji szerokości. Jest to wyświetlane w następujący sposób:

Czarna linia: zdarzenie nie policzone

Ciągła biała linia: zdarzenie liczone jako jeden obiekt

Przerywana biała linia: zdarzenie liczone jako wiele obiektów wskazane przez liczbę segmentów linii.

Wykorzystując informacje zwrotne z adnotacji diagnostycznych, można precyzyjnie dostosować kalibrację szerokości, aby policzyć obiekty o prawidłowym rozmiarze i odfiltrować fałszywe zliczenia.

Linia zliczająca zawiera filtr cienia, który ma na celu usunięcie efektów cieni obiektów wpływających na algorytm zliczania. Cienie mogą powodować niedokładne wyniki zliczania, sprawiając, że obiekt wydaje się większy niż jego prawdziwy rozmiar lub łącząc dwa lub więcej obiektów razem. Jeśli cienie powodują niedokładne zliczanie, należy włączyć filtr cienia, zaznaczając pole wyboru Filtruj Cienie (Filter Shadows) dla linii. Zaleca się, aby filtr cienia był włączony tylko wtedy, gdy występują cienie, ponieważ algorytm może pomylić pewne części obiektu z cieniami, co może prowadzić do gorszych wyników zliczania. Dotyczy to zwłaszcza obiektów, które mają niewielki kontrast w porównaniu z tłem (np. Ludzie noszą czarne płaszcze na czarnym dywanie).

| Właściwość | Opis | Standardowa wartość |

|---|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły | "Line_Counter #" |

| Zone | Strefa, z którą ta reguła jest powiązana | None |

| Direction | Włącz liczenie w kierunku „A” lub „B” (jeden kierunek na linię liczenia) | None |

| Enable Width Calibration | Kalibracja szerokości do dokładniejszego zliczania | None |

| Width | Szerekość kalibracji | 0 |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje | Active |

Poniższy przykład ma dwie linie liczące, Line_Counter A i Line_Counter B każda z nich powiązana ze strefą Center Line w różnych kierunkach zliczania. Line_Counter A jest skonfigurowana do zliczania (increment), Line_Counter B jest skonfigurowana do pomniejszania licznika (decrement). Tylko reguła licznika Counter jest ustawiona do wyzwalania alarmu Can Trigger Actions, co oznacza, że tylko ten składnik reguły logicznej będzie dostępny jako źródło alarmu. W takim przypadku akcja wykorzystująca tę regułę jako źródło będzie uruchamiana przy każdej zmianie licznika.

Poniżej znajduje się lista aktualnie obsługiwanych reguł logicznych wraz ze szczegółowym opisem każdej z nich.

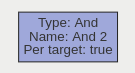

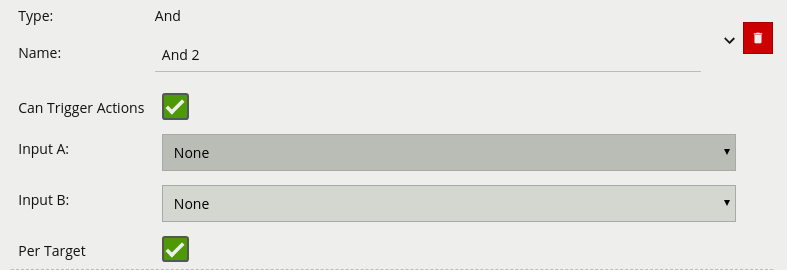

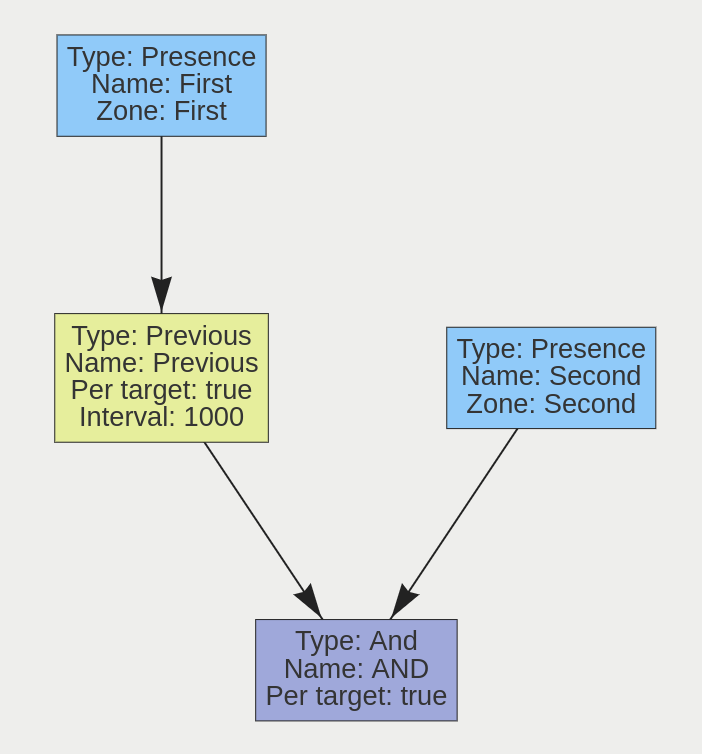

Operator logiczny, który łączy dwie reguły i wywołuje zdarzenia tylko, jeśli oba wejścia są prawdziwe.

| Właściwość | Opis |

|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje |

| Input A | Pierwsze wejście |

| Input B | Drugie wejście |

| Per Target | Wygeneruj tylko jedno zdarzenie na każdy osobny śledzony obiekt |

Jeśli weźmiemy pod uwagę scenę z dwoma regułami obecności połączonymi z dwiema oddzielnymi strefami połączonymi regułą AND, poniższa tabela wyjaśnia zachowanie właściwości Per Target. Zauważ, że obiekt tutaj odnosi się do śledzonego obiektu, jaki wykrył silnik VCA.

| Stan | Per-Target | Wynik |

|---|---|---|

| Obiekt A w wejściu A, obiekt B w wejściu B | On | Wygenerowano dwa zdarzenia, po jednym dla każdego obiektu |

| Obiekt A w wejściu A, obiekt B w wejściu B | Off | Wygenerowano tylko jedno zdarzenie |

Ponadto ważne jest, aby pamiętać, że gdy wyłączony jest Per-Target, jeśli reguła zostanie wyzwolona, nie zostanie ona ponownie wyzwolona, dopóki nie zostanie zresetowana, tj. Dopóki warunek AND nie będzie już prawdziwy.

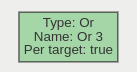

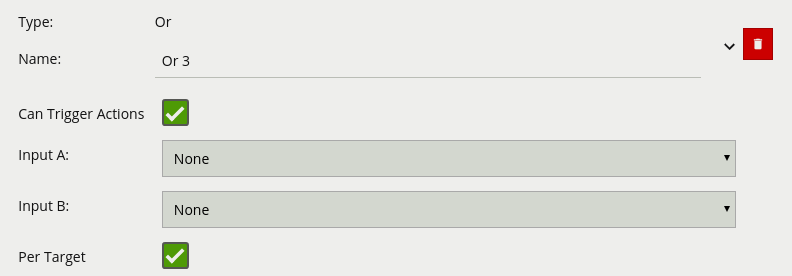

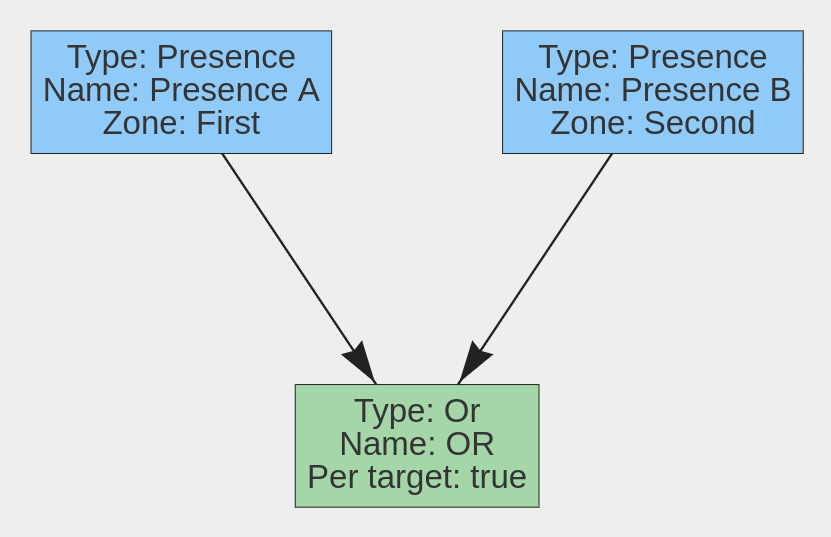

Operator logiczny, który łączy dwie reguły i wywołuje zdarzenia, jeśli jedna z nich jest prawdziwe.

| Właściwość | Opis |

|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje |

| Input A | Pierwsze wejście |

| Input B | Drugie wejście |

| Per Target | Wygeneruj tylko jedno zdarzenie na każdy osobny śledzony obiekt |

Jeśli weźmiemy pod uwagę scenę z dwoma regułami obecności połączonymi z dwiema oddzielnymi strefami połączonymi regułą OR, poniższa tabela wyjaśnia zachowanie właściwości Per Target.

| Stan | Per Target | Wynik |

|---|---|---|

| Obiekt A na wejściu A, brak obiektu na wejściu B | On | Wygenerowano dwa zdarzenia, po jednym dla każdego obiektu |

| Brak obiektu w wejściu A, obiekt B w wejściu B | On | Wygenerowano tylko jedno zdarzenie (dla obiektu B) |

| Obiekt A na wejściu A, brak obiektu na wejściu B | On | Wygenerowano tylko jedno zdarzenie (dla obiektu A) |

| Obiekt A na wejściu A, brak obiektu na wejściu B | Off | Wygenerowano tylko jedno zdarzenie |

| Brak obiektu w wejściu A, obiekt B w wejściu B | Off | Wygenerowano tylko jedno zdarzenie |

| Obiekt A na wejściu A, brak obiektu na wejściu B | Off | Wygenerowano tylko jedno zdarzenie |

Ponadto ważne jest, aby pamiętać, że gdy wyłączony jest Per Target, jeśli reguła zostanie wyzwolona, nie zostanie ona ponownie wyzwolona, dopóki nie zostanie zresetowana, tj. Dopóki warunek OR nie będzie już prawdziwy.

Operator logiczny, który wyzwala zdarzenia wejściowe, które były aktywne w pewnym momencie w poprzednim oknie czasu. To okno jest zdefiniowane między bieżącym czasem a okresem przed bieżącym czasem (określonym przez wartość parametru interwału).

| Właściwość | Opis |

|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje |

| Input | Reguła Danych Wejściowych |

| Per Target | Wygeneruj tylko jedno zdarzenie na każdy osobny śledzony obiekt |

| Interval | Czas w milisekundach |

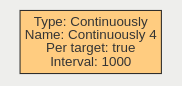

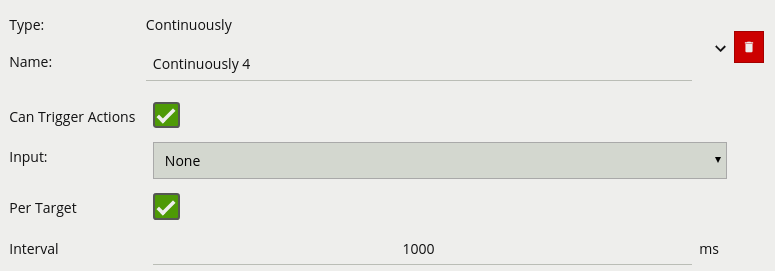

Operator logiczny, który uruchamia zdarzenie, gdy jego reguła wejściowa wystąpiła w sposób ciągły przez czas określony przez użytkownika.

| Właściwość | Opis |

|---|---|

| Name | Nazwa określona przez użytkownika dla tej reguły |

| Can Trigger Actions | Określa, czy zdarzenia generowane przez tę regułę wywołują akcje |

| Input | Reguła Danych Wejściowych |

| Per Target | Wygeneruj tylko jedno zdarzenie na każdy osobny śledzony obiekt |

| Interval | Czas w milisekundach |

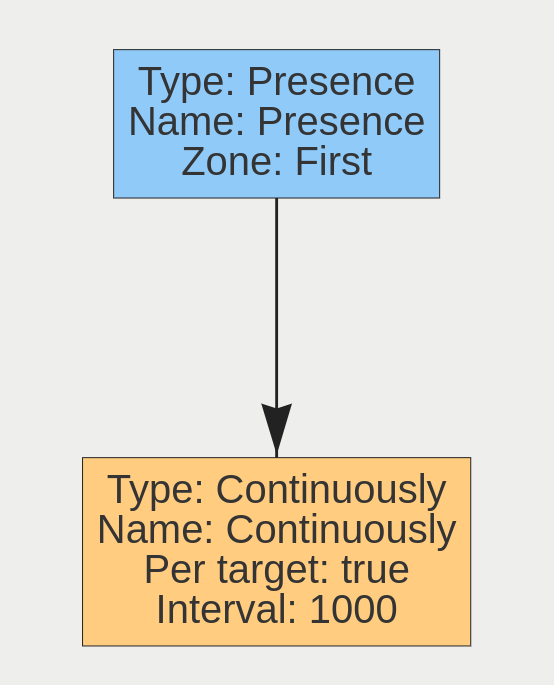

Biorąc pod uwagę scenę z jedną strefą, regułę obecności powiązaną z tą strefą oraz regułę Continuously dołączoną do tej reguły obecności, gdy właściwość Per-Target jest włączona, reguła wygeneruje zdarzenie dla każdego śledzonego obiektu, który jest stale obecny w strefie. Gdy jest wyłączona, reguła generuje tylko jedno zdarzenie, nawet jeśli w strefie znajduje się wiele śledzonych obiektów. Dodatkowo, gdy Per-Target jest wyłączony, reguła generuje tylko zdarzenia, gdy następuje zmiana stanu - tj. Warunek reguły zmienia się z true na false lub odwrotnie. Gdy opcja Per-Target jest wyłączona, stan zmieni się, gdy:

Reguła przebywania uruchamia się, gdy obiekt pozostaje w strefie przez określony czas. Regułę przebywania można łatwo zaimplementować jako regułę logiczną, łącząc reguły „Presence (Obecność)” i „Continuously (Ciągle)”. Reguła „Presence (Obecność)” jest dodawana jako pierwsza i połączona ze strefą, a następnie reguła „Continuously (Ciągle)”, która jest powiązana z regułą „Presence (Obecność)”. Parametr interwału reguły „Continuously (Ciągle)” to czas, w którym obiekt musi pozostać w strefie by wyzwolić zdarzenie. Wykres reguły przebywania jest następujący:

Prostym przypadkiem użycia tej reguły jest obszar, w którym wałęsanie się jest zabronione. Reguła przebywania może być używana do wykrywania tego zachowania.

Na poniższym zdjęciu osoba była w strefie dłużej niż 5 sekund, podczas gdy pojazd nie. Stąd osoba generuje zdarzenie, a pojazd nie.

Reguła „Podwójnego Naruszenia” jest regułą, która uruchamia się, gdy obiekt wchodzi do jednej strefy, po której następuje naruszenie innej. Reguła jest wyzwalana tylko wtedy, gdy obiekt opuszcza pierwszą strefę, a następnie wchodzi w drugą. Odstęp czasu na regule „Previous (Poprzedni)” na wykresie decyduje o tym, ile czasu upłynęło od wejścia obiektu do pierwszej strefy. Wykres reguły podwójnego naruszenia jest następujący:

Regułę można interpretować w następujący sposób: „Obiekt znajduje się w strefie 2, a poprzednio w ciągu ostatnich 1000 milisekund był w strefie 1.”. Ta reguła może być używana jako skuteczny sposób wykrywania wejścia do obszaru. Ponieważ obiekt musi wejść w dwie strefy w określonej kolejności, ma zdolność eliminowania fałszywych zdarzeń, które mogą pojawiać się z reguły Obecności (Presence).

Ta reguła uruchamia się, gdy obiekt znajduje się w strefie A lub B. Jego wykres jest następujący:

Typowym przypadkiem użycia tej reguły jest posiadanie wielu obszarów, w których dostęp jest zabroniony, ale obszary nie mogą być łatwo objęte jedną strefą. Można utworzyć dwie strefy powiązane z dwiema osobnymi regułami Obecności (Presence), a następnie połączyć je za pomocą reguły Or.

VCAcore obsługuje liczniki, które można skonfigurować do liczenia różnych rzeczy, takich jak liczba uruchomień reguły lub liczba osób przekraczających linię.

Liczniki można dodawać, klikając prawym przyciskiem myszy (lub przytrzymując na urządzeniach mobilnych) wideo, aby wyświetlić menu kontekstowe:

Liczniki można przemieszczać, chwytając „handle” pod nazwą licznika i przesuwając licznik w żądane miejsce.

Menu konfiguracji licznika zawiera szereg parametrów konfiguracyjnych specyficznych dla licznika:

Name: Nazwa licznika. Edytowanie tego pola zmienia nazwę licznika wyświetlaną na wideo.

Add a Rule: Dodaje nową regułę jako wyzwalacz źródła licznika.

Rule: Istniejące wcześniej źródło wyzwalania licznika (które zostało wcześniej dodane przez przycisk Add a Rule).

Type: Typ wyzwalacza licznika. Może być jednym z Increment, Decrement or Occupancy. Zobacz poniżej, aby uzyskać więcej informacji na temat różnych typów.

Reset Counter: Resetuje wartość licznika do zera.

Można skonfigurować źródła wyzwalania licznika jako Increment, Decrement or Occupancy. Każdy tryb jest opisany poniżej:

Dowiedz się, jak skalibrować kanał.

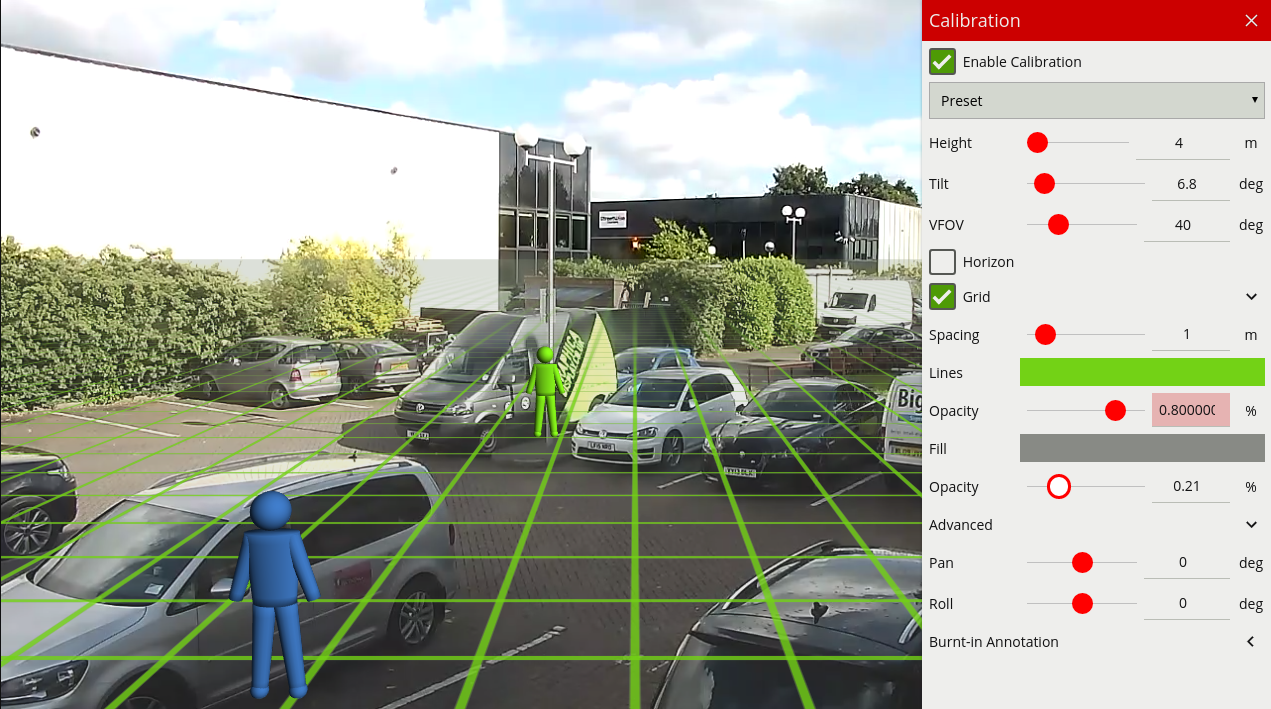

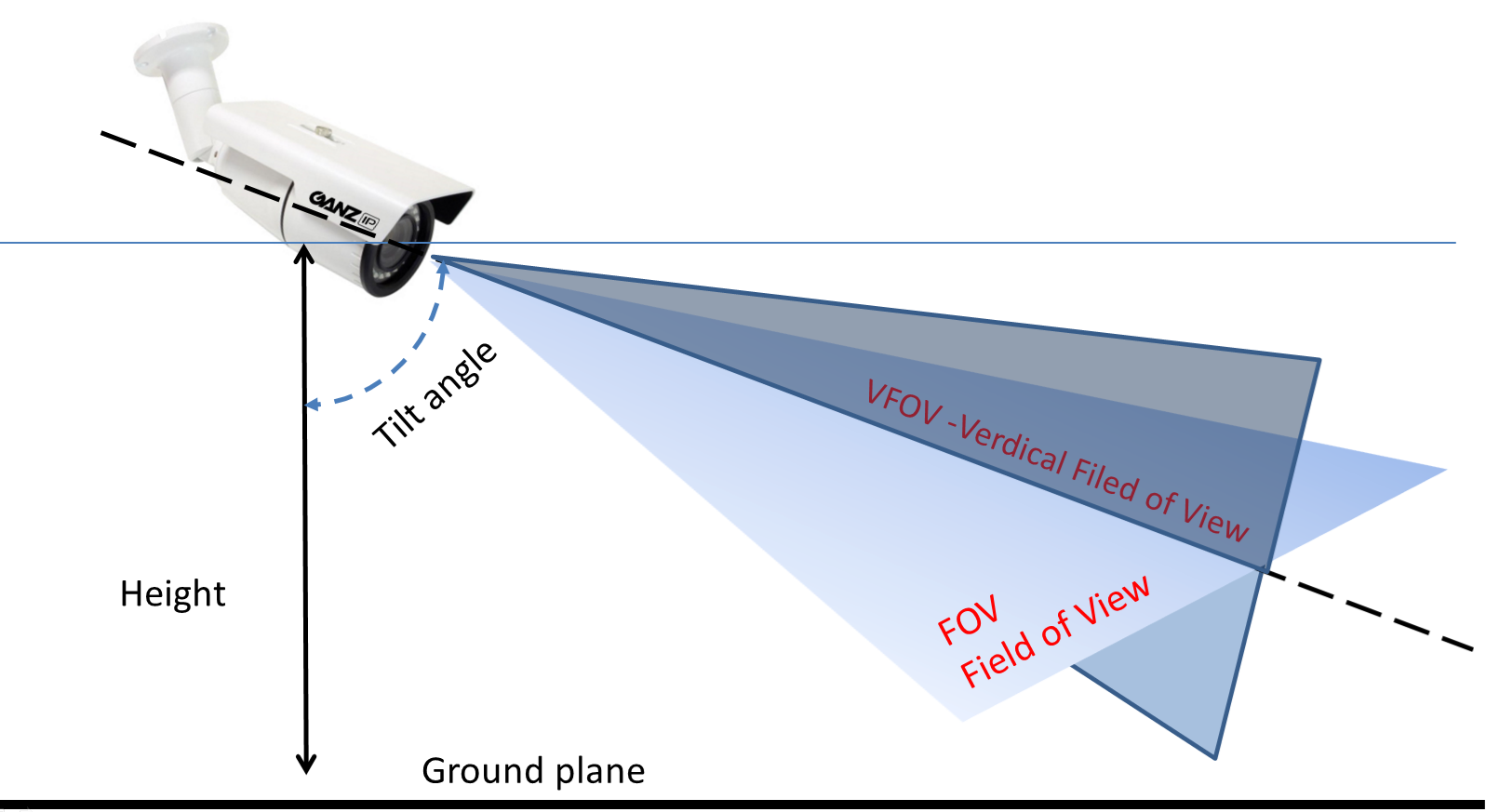

Kalibracja kamery jest wymagana, aby VCAcore mógł klasyfikować obiekty do różnych klas obiektów. Po skalibrowaniu kanału VCAcore może określić rzeczywiste właściwości obiektu, takie jak prędkość, wysokość i powierzchnia, i odpowiednio klasyfikować obiekty.

Kalibracja kamery jest podzielona na następujące podtematy:

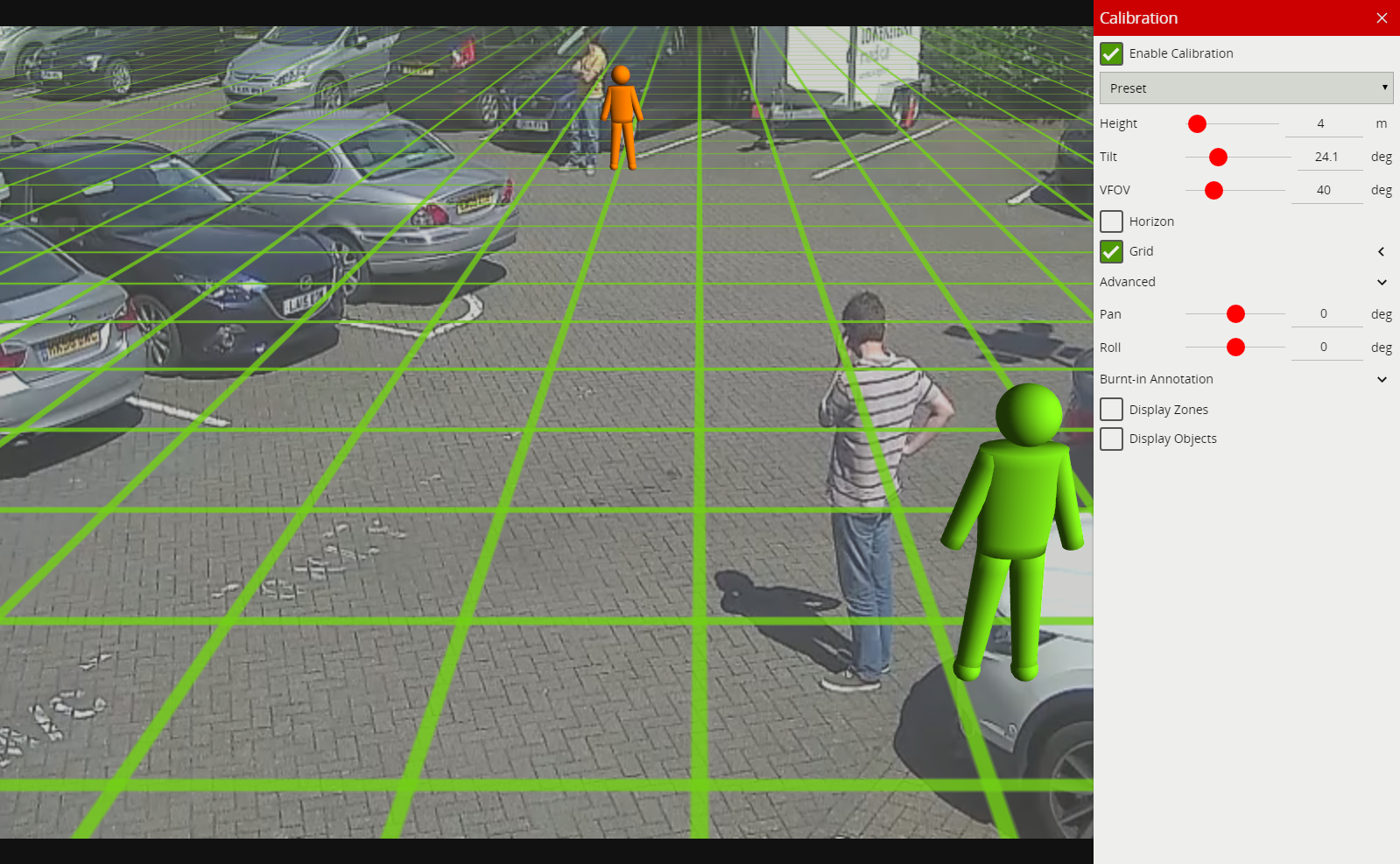

Domyślnie kalibracja jest wyłączona. Aby włączyć kalibrację na kanale, zaznacz pole wyboru Włącz Kalibrację.

Strona kalibracji zawiera wiele elementów ułatwiających kalibrację kanału tak łatwo, jak to możliwe. Każda z nich jest opisana poniżej.

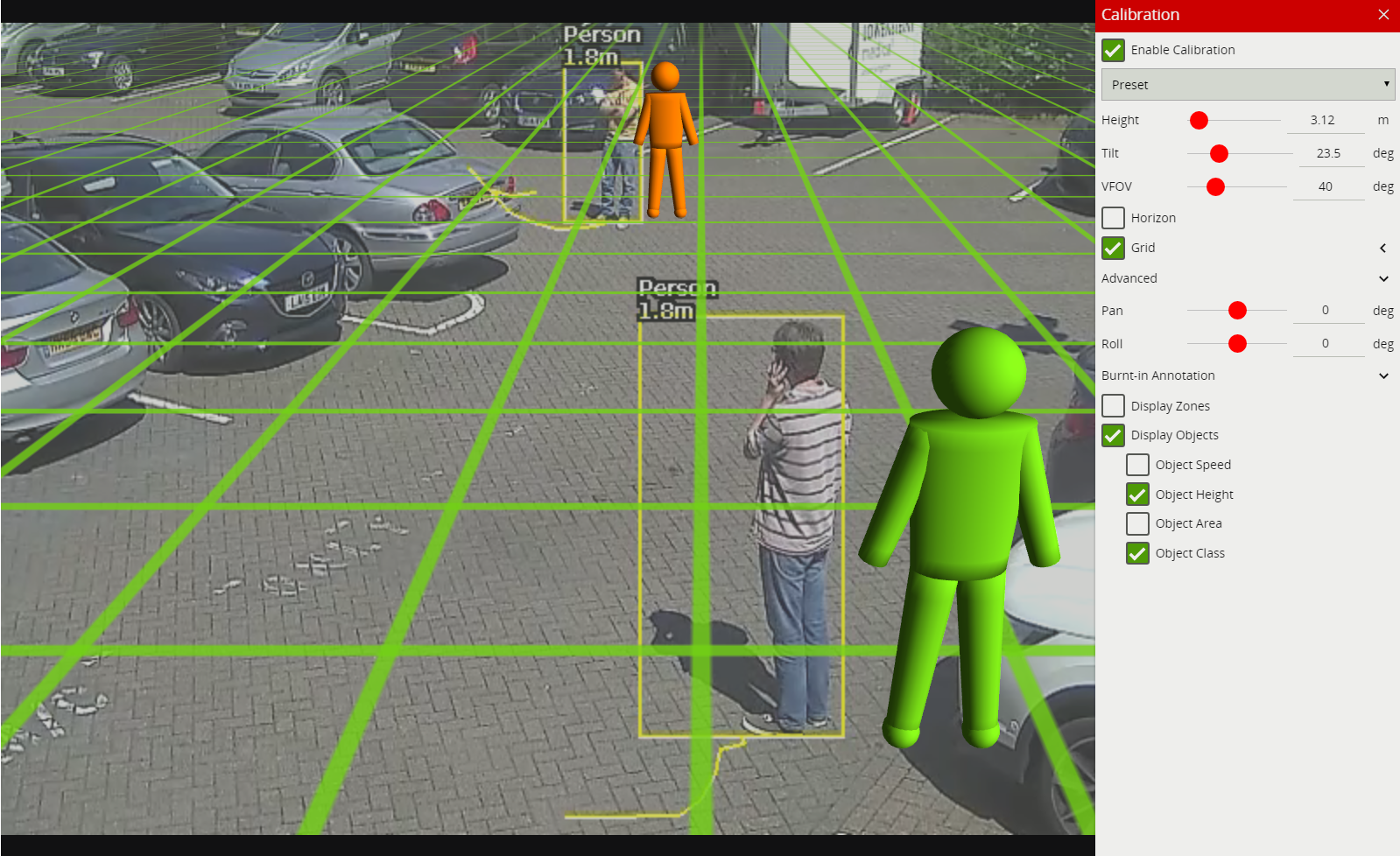

Podczas procesu kalibracji elementy obrazu wideo muszą być dopasowane do nałożonej grafiki 3D. Nałożona grafika 3D składa się z zielonej siatki reprezentującej płaszczyznę podłoża. Na płaszczyźnie podłoża umieszczonych jest kilka elementów mimicznych 3D (figur w kształcie ludzi), które przedstawiają wymiary osoby z bieżącymi parametrami kalibracji. Mimiki kalibracyjne służą do weryfikacji rozmiaru osoby w scenie i mają 1.8 metra wysokości.

Mimiki można przesuwać po scenie, aby dopasować je do ludzi (lub przedmiotów o znanej, porównywalnej wysokości) do osoby.

Parametry kalibracji można regulować za pomocą myszy w następujący sposób:

Uwaga: Suwaki w panelu sterowania mogą być również używane do regulacji kąta nachylenia i wysokości kamery.

Panel sterowania (pokazany po prawej stronie na powyższym obrazku) zawiera następujące elementy sterujące:

Kliknięcie prawym przyciskiem myszy (lub dotknij i przytrzymaj na tablecie) na siatce wyświetla menu kontekstowe:

Wykonanie tej samej czynności na mimice powoduje wyświetlenie menu kontekstowego mimiki:

Możliwe działania z menu kontekstowego to:

Kalibracja kanału jest konieczna w celu oszacowania parametrów obiektu, takich jak wysokość, powierzchnia, prędkość i klasyfikacja. Jeśli wysokość, kąt nachylenia i pionowe pole widzenia odpowiadające instalacji są znane, można je po prostu wprowadzić jako parametry w odpowiednich polach panelu sterowania.

Jeśli jednak te parametry nie są dokładnie znane, ta sekcja zawiera przewodnik krok po kroku dotyczący kalibracji kanału.

Znajdź na scenie kilka osób lub obiekty o rozmiarze ludzi. Spróbuj znaleźć osobę w pobliżu kamery i osobę znajdującą się dalej od kamery. Przydatne jest użycie sterowania odtwarzaniem / pauzą, aby wstrzymać wideo, by można było dokładnie umieścić mimikę. Umieść mimiki na górze lub w pobliżu ludzi:

Określenie prawidłowego pionowego pola widzenia jest ważne dla dokładnej kalibracji. Poniższa tabela przedstawia wstępnie obliczone wartości pionowego pola widzenia dla różnych rozmiarów przetworników.

| Focal Length(mm) | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 15 | 20 | 30 | 40 | 50 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| CCD Size (in) | CCD Height(mm) | |||||||||||||||

| 1/6" | 1.73 | 82 | 47 | 32 | 24 | 20 | 16 | 14 | 12 | 11 | 10 | 7 | ||||

| 1/4" | 2.40 | 100 | 62 | 44 | 33 | 27 | 23 | 19 | 17 | 15 | 14 | 9 | 7 | |||

| 1/3.6" | 3.00 | 113 | 74 | 53 | 41 | 33 | 28 | 24 | 21 | 19 | 12 | 11 | 9 | 6 | ||

| 1/3.2" | 3.42 | 119 | 81 | 59 | 46 | 38 | 32 | 27 | 24 | 21 | 16 | 13 | 10 | 7 | ||

| 1/3" | 3.60 | 122 | 84 | 62 | 48 | 40 | 33 | 29 | 25 | 23 | 20 | 14 | 10 | 7 | 5 | |

| 1/2.7" | 3.96 | 126 | 89 | 67 | 53 | 43 | 37 | 32 | 28 | 25 | 22 | 15 | 11 | 8 | 6 | |

| 1/2" | 4.80 | 135 | 100 | 77 | 62 | 51 | 44 | 38 | 33 | 30 | 27 | 18 | 14 | 9 | 7 | 5 |

| 1/1.8" | 5.32 | 139 | 106 | 83 | 67 | 56 | 48 | 42 | 37 | 33 | 30 | 20 | 15 | 10 | 8 | 6 |

| 2/3" | 6.60 | 118 | 95 | 79 | 67 | 58 | 50 | 45 | 40 | 37 | 25 | 19 | 13 | 9 | 8 | |

| 1" | 9.60 | 135 | 116 | 100 | 88 | 77 | 69 | 62 | 56 | 51 | 35 | 27 | 18 | 14 | 11 | |

| 4/3" | 13.50 | 132 | 119 | 107 | 97 | 88 | 80 | 74 | 68 | 48 | 37 | 25 | 19 | 15 |

Jeśli tabela nie zawiera odpowiednich parametrów, pionowy FOV można oszacować, oglądając krańce obrazu na górze i na dole. Zauważ, że bez prawidłowego pionowego pola widzenia, uzyskanie prawidłowych wielkości mimik może nie być możliwe, aby dopasować ludzi w różnych pozycjach sceny do nich.

Jeśli wysokość kamery jest znana, wpisz ją bezpośrednio. Jeśli wysokość nie jest znana, oszacuj ją jak najdokładniej i wpisz.

Dostosuj kąt pochylenia kamery (i wysokość, jeśli to konieczne), aż obie mimiki będą w przybliżeniu tego samego rozmiaru, co prawdziwa osoba w tej pozycji na scenie. Kliknij i przeciągnij płaszczyznę podłoża, aby zmienić kąt pochylenia i użyj kółka myszy lub panelu sterowania, aby dostosować wysokość montażu kamery.

Celem jest zapewnienie, że mimiki umieszczane w różnych miejscach na siatce pokrywają się z ludźmi lub obiektami o rozmiarach ludzi na scenie.

Po dostosowaniu parametrów adnotacje dla obiektu będą odzwierciedlać zmiany i odpowiednio klasyfikować obiekty.

Po skalibrowaniu sceny przeciągnij lub dodaj mimikę w różnych miejscach w scenie i sprawdź, czy pojawiają się one w tym samym rozmiarze / wysokości, co prawdziwa osoba. Sprawdź, czy wysokość i obszar zgłoszone przez adnotację VCAcore wyglądają mniej więcej poprawnie. Należy pamiętać, że ustawienia wypalenia w adnotacji w panelu sterowania mogą być używane do włączania i wyłączania różnych typów adnotacji.

Powtarzaj krok 4, aż kalibracja będzie akceptowalna.

Wskazówka: Jeśli wszystko pójdzie nie tak i mimiki znikną lub zostaną utracone z powodu dziwnej konfiguracji, wybierz jedną z wstępnie skonfigurowanych konfiguracji, aby przywrócić wyświetlanie do normalności.

Zaawansowane parametry kalibracji umożliwiają panoramowanie i walcowanie płaszczyzny podłoża bez wpływu na parametry kalibracji kamery. Może to być przydatne do wizualizacji ustawień kalibracji, jeśli scena jest przesunięta lub przekręcona względem kamery.

Uwaga: Zaawansowane parametry pan i roll wpływają tylko na orientację płaszczyzny podłoża 3D, dzięki czemu można ją lepiej dopasować do sceny wideo i nie wpływa to w rzeczywistości na parametry kalibracji.

Po skalibrowaniu kanału można skonfigurować Ustawienia Klasyfikacji.

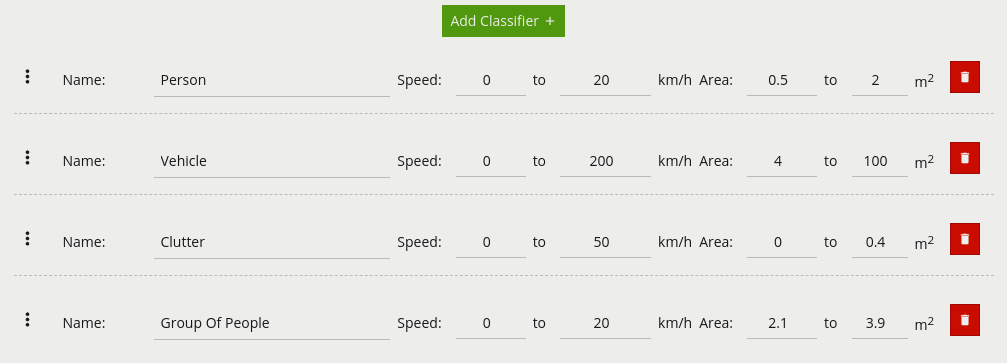

VCAcore może dokonać klasyfikacji obiektów po skalibrowaniu kamery. Klasyfikacja obiektów opiera się na właściwościach wyodrębnionych z obiektu, takich jak obszar obiektu i prędkości. VCAcore ma fabrycznie załadowane najbardziej zbliżone klasy obiektów, które w większości przypadków nie trzeba modyfikować. W niektórych sytuacjach może być konieczna zmiana parametrów klasyfikacji lub dodanie nowych klas obiektów.

Każdy z elementów interfejsu użytkownika jest opisany poniżej:

: Kliknij i przeciągnij, aby zmienić kolejność grup klasyfikacji.

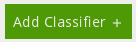

: Kliknij i przeciągnij, aby zmienić kolejność grup klasyfikacji.Aby dodać nową grupę klasyfikacji, kliknij przycisk Add Classifier  .

.

Obiekty są klasyfikowane zgodnie z tym, jak ich zmierzone i obliczone właściwości odpowiadają grupom klasyfikacyjnym. Każda grupa klasyfikacyjna określa zakres prędkości i zakres powierzchni. Obiekty, które mieszczą się w obu zakresach prędkości i powierzchni, zostaną sklasyfikowane jako obiekt odpowiedniej klasy.

Uwaga: Jeśli wiele klas zawiera nakładające się zakresy prędkości i obszarów, klasyfikacja obiektu może być niejednoznaczna (ponieważ obiekt będzie pasował do więcej niż jednej klasy). W tym przypadku rzeczywista klasyfikacja nie jest określona więc losowo może przypisać jedną z nakładających się klas.

VCAcore obsługuje również klasyfikację obiektów dzięki zastosowaniu filtra głębokiego uczenia się, w celu przedstawienia jego funkcjonalności i interakcji z klasyfikacją obiektów na skalibrowanych scenach, zobacz Ustawienia Zaawansowane.

Dowiedz się więcej o Wykrywaniu Sabotażu.

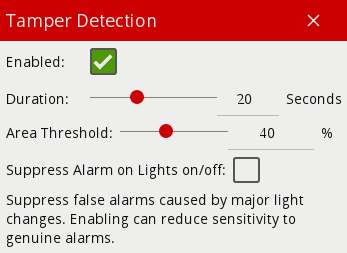

Moduł wykrywania sabotażu jest przeznaczony do wykrywania zdarzeń sabotażu kamery, takich jak zasłonięcie, rozmazanie i przesuwanie kamery. Osiąga się to poprzez wykrywanie dużych trwałych zmian w obrazie.

Aby włączyć wykrywanie sabotażu, zaznacz pole Enabled.

W zaawansowanych ustawieniach wykrywania sabotażu możliwa jest zmiana progów dla obszaru obrazu, który musi zostać zmieniony, oraz czasu, przez który musi być zmieniony, przed wyzwoleniem zdarzenia sabotażu.

Jeśli problem stanowią fałszywe alarmy, należy zwiększyć czas trwania i/lub obszar, aby duże zmiany przejściowe, takie jak bliskie obiekty tymczasowo zasłaniające kamerę, nie powodowały fałszywych alarmów.

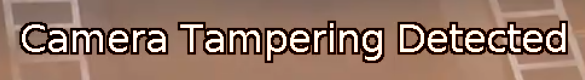

Po wykryciu sabotażu generowane jest zdarzenie sabotażu. To zdarzenie jest przesyłane przez dowolne elementy wyjściowe akcji, a także wyświetlane w strumieniu wideo:

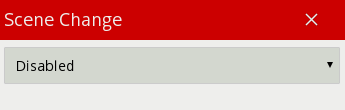

Dowiedz się więcej o Wykrywaniu Zmian Sceny.

Moduł wykrywania zmiany sceny resetuje algorytm śledzenia, gdy wykryje dużą trwałą zmianę obrazu. Zapobiega to wykrywaniu zmian w obrazie przez silnik śledzenia jako śledzonych obiektów, które mogą być potencjalnymi źródłami fałszywych alarmów.

Rodzaje zmian, które wykrywa moduł wykrywania zmiany sceny, są następujące:

Dostępne są 3 opcje trybu wykrywania zmiany sceny:

Jest to ustawienie domyślne, które automatycznie użyje zalecanych ustawień. Zaleca się pozostawienie ustawienia automatycznego, chyba że wykrywanie automatyczne zmiany sceny powoduje problemy.

Wykrywanie zmiany sceny jest wyłączone.

Należy pamiętać, że gdy wykrywanie zmiany sceny jest wyłączone, duże zmiany w obrazie nie zostaną wykryte. Na przykład, jeśli ciężarówka stoi przed kamerą, zmiana sceny nie zostanie wykryta, w wyniku czego mogą wystąpić fałszywe zdarzenia.

Umożliwia ręczzną konfigurację parametrów algorytmu wykrywania zmiany sceny.

Jeśli tryb automatyczny jest wyzwalany w sytuacjach, gdy nie jest to pożądane (np. jest zbyt czuły lub niewystarczająco czuły), parametry można dostosować ręcznie, aby dokładnie ustawić zachowaniem w takich przypadkach.

W trybie ręcznym dostępne są następujące ustawienia:

Gdy przekroczone zostaną progi czasu i obszaru, scena zostanie uznana za zmienioną i zostanie zresetowana.

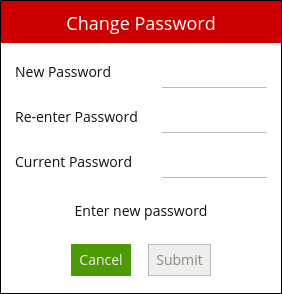

Jeśli wykrycie zmiany sceny jest błędne, czas i/lub obszar powinny zostać zwiększone, tak aby duże zmiany przejściowe, takie jak bliski obiekt tymczasowo zasłaniający kamerę, nie powodowały wykrycia zmiany sceny.